THÈSE

Pour obtenir le grade de

DOCTEUR DE L’UNIVERSITÉ SAVOIE MONT

BLANC

Spécialité : Sciences pour l’Ingénieur

Arrêtée ministériel : 25 mai 2016

Présentée par

Pierre Nagorny

Thèse dirigée par Maurice Pillet

et codirigéee par Éric Pairel

préparée au sein du Laboratoire SYMME

dans l’École Doctorale SISEO

Contrôle automatique non-invasif de la

qualité des produits

Application au procédé d’injection-moulage des

thermoplastiques

Thèse soutenue publiquement le 9 mars 2020,

devant le jury composé de :

Gilles Régnier

Professeur des Universités, Arts et Métiers-ENSAM, Président

Christophe Cudel

Professeur des Universités, Université Haute-Alsace, Rapporteur

Fabrice Mériaudeau

Professeur des Universités, Université de Bourgogne, Rapporteur

Ronan Le Goff

Ingénieur de Recherche, Centre Technique IPC, Examinateur

Maurice Pillet

Professeur des Universités, Université Savoie Mont Blanc, Directeur de thèse

Éric Pairel

Maître de conférences Habilité à Diriger les Recherches, Université Savoie Mont

Blanc, Co-Directeur de thèse

Émilio Vitale

Ingénieur Statisticien, Plastic Omnium Intelligent Exterior Systems, Invité

Remerciements & Dédicace

Remerciements

Ces quelques lignes seront insuffisantes pour remercier tous ceux qui doivent l’être. Le lecteur

se devra d’effectuer une recherche bibliographique pour réunir la liste complète de ces personnes :

co-auteurs, membres de groupements de travaux, doctorants de l’École Doctorale SISEO en 2017-

2020, les étudiants de l’IUT d’Annecy et de l’école d’ingénieur Polytech Annecy qui ont été

d’excellents cobayes.

Je souhaite remercier les professeurs Christophe Cudel et Fabrice Mériaudeau pour l’intérêt qu’ils

ont porté à ce travail et pour leurs commentaires détaillés qui ont permis d’améliorer ce manuscrit.

Merci au professeur Gilles Régnier d’avoir accepter de présider le jury; ainsi qu’à messieurs

Ronan Le Goff, Émilio Vitale pour leurs présences le jour J et leurs aides pour la réalisation

des essais expérimentaux industriels, indispensable pour avancer dans mon travail.

Je remercie particulièrement Éric Pairel et Maurice Pillet pour :

— la direction idéale de ces travaux de recherche,

— leur soutien humain infaillible,

— le partage de leurs expériences académique, professorale et de recherche.

Le financement de ce travail et son accomplissement, n’aurait pû être obtenu sans leur

persévérance. Je remercie BPI France et de manière générale l’effort de la France pour le

financement de la Recherche. Merci aux Bibliothèques Universitaires pour leur travail de

préservation des ouvrages de références, et à tous les sites de l’Internet qui rendent accessibles

une vaste connaissance librement, HAL, arXiV, Science-Hub qui ont rendus possible l’étude

bibliographique.

Cette ligne me permet de remercier efficacement l’ensemble des membres du laboratoire SYMME

d’Annecy–Le Bourget-du-Lac pour la bonne ambiance qu’ils entretiennent. Je garde un excellent

souvenir de tous les fructueux échanges qui m’ont permis d’approfondir ou de faire germer des

idées. Merci aux chercheurs, ingénieurs, administratifs et aux doctorants pour avoir égayés tous ces

moments; en particulier mon voisin de bureau Orlando; le couloir du haut : Amandine, Florian,

Jérémy, Koki, Luc, Marine, Mathias, Mickaël, Thomas, Thomas, Thomas ; le couloir du bas :

Amélie, Aurélien, Christian, Ludovic, Mathias, Thibault; les voisines de l’IREGE / label RES :

Camille, Caroline, Olga; les voisins du Bourget, Jean, Marie ; et pour la fabrication additive Blaise

et Hugues.

Coté famille, je dois d’énormes mercis à mes grands-parents, mes parents modèles —Monique et

Fred—, la merveilleuse Margot et un joyeux enfant qui a égayé la rédaction de ce manuscrit.

Enfin, merci à vous, lecteurs, qui faites vivre ce manuscrit. J’espère qu’il vous permettra d’obtenir

des réponses ou qu’il saura créer de nombreuses interrogations, tout en vous divertissant, avant de

vous endormir.

Dédicace

À ma généreuse famille, pour tout le soutien reçu, qui m’a permis de mener à bien ce travail.

i

Épigraphe

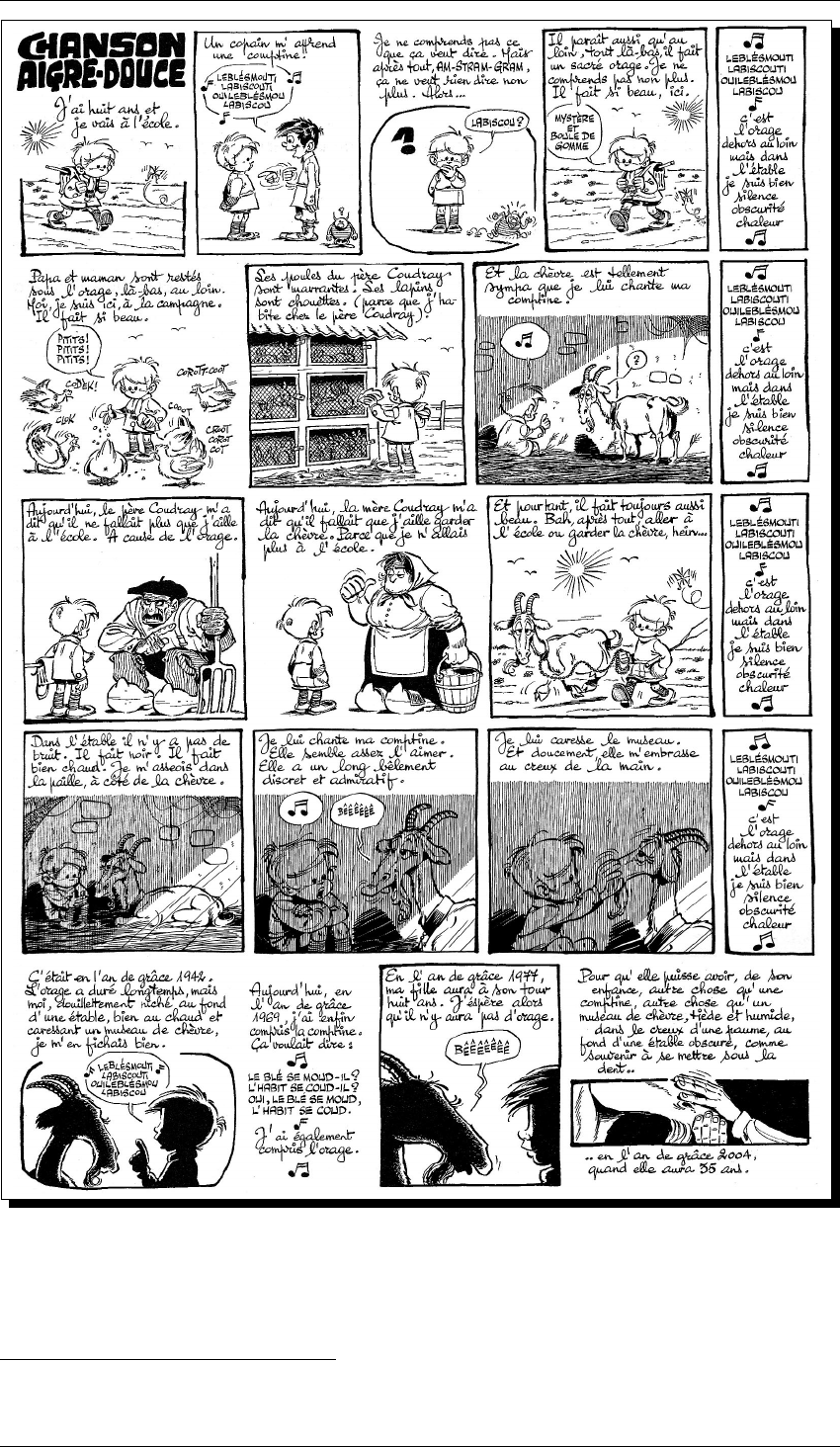

© Gotlib / Dargaud

1

Mes grands-parents ont connu l’orage.

En 2000, j’avais huit ans, il n’y avait pas d’orage chez moi. Je suis allé à l’école.

En 2027, ma fille aura à son tour huit ans. J’espère qu’il n’y aura pas d’orage.

1. Extrait de deux planches de Marcel Gotlib, publiées en Novembre 1969 dans le N°525 de l’hebdomadaire Pilote,

puis dans la Rubrique-à-Brac Taume 2, publiée aux éditions Dargaud.

iii

Table des matières

Remerciements & Dédicace . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . i

Épigraphe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . iii

Table des matières . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . v

Introduction 1

1 Contexte industriel et problématique de recherche 5

1.1 Le procédé d’injection-moulage des thermoplastiques . . . . . . . . . . . . . . . 6

1.1.1 Paramètres réglables d’une presse à injecter . . . . . . . . . . . . . . . . 8

1.2 La qualité d’un produit en injection-moulage des thermoplastiques . . . . . . . . 10

1.3 Revue de la recherche académique sur le procédé d’injection-moulage . . . . . . 12

1.3.1 Cartographie bibliographique . . . . . . . . . . . . . . . . . . . . . . . 12

1.3.2 Modélisation du procédé d’injection-moulage . . . . . . . . . . . . . . . 13

1.3.3 Maîtrise du procédé d’injection-moulage des thermoplastiques . . . . . . 17

1.4 Problématique industrielle : le contrôle qualité en ligne de production . . . . . . 19

1.4.1 Viabilité économique du déploiement du mesurage de la qualité en ligne

de production . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

1.4.2 Mesurage des variables d’état du procédé : mesurage indirect des

caractéristiques du produit . . . . . . . . . . . . . . . . . . . . . . . . . 20

1.4.3 Mesurage direct des caractéristiques du produit . . . . . . . . . . . . . . 21

1.4.4 Cahier des charges pour le contrôle de la qualité en ligne de production . 26

1.4.5 Proposition d’une définition du degré d’invasivité d’un système de mesure

pour un procédé . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28

1.4.6 Étude technico-économique du mesurage des caractéristiques du produit . 29

1.4.7 Formalisation de la notion de qualité d’une pièce . . . . . . . . . . . . . 30

1.5 Conclusion : la problématique du contrôle de la qualité en ligne de production . . 31

2 Apport de l’imagerie non-conventionnelle pour la mesure non-invasive de la qualité 33

2.1 Contexte de l’essai expérimental . . . . . . . . . . . . . . . . . . . . . . . . . . 34

2.1.1 Exploration du procédé par plan d’expériences . . . . . . . . . . . . . . 34

2.1.2 Sélection des paramètres de l’étude expérimentale . . . . . . . . . . . . 35

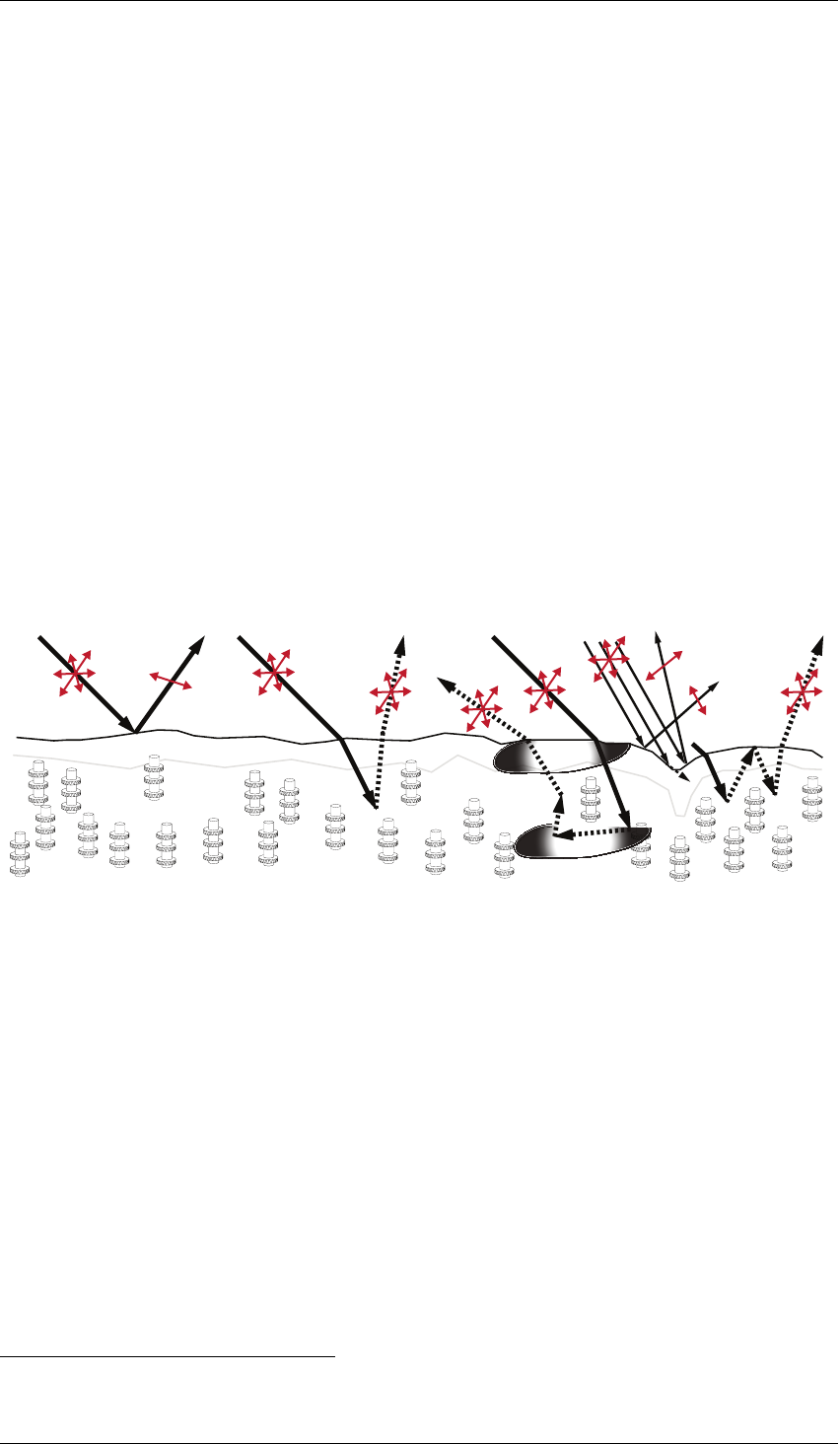

2.2 Évolution des pièces moulées après la sortie du moule . . . . . . . . . . . . . . . 37

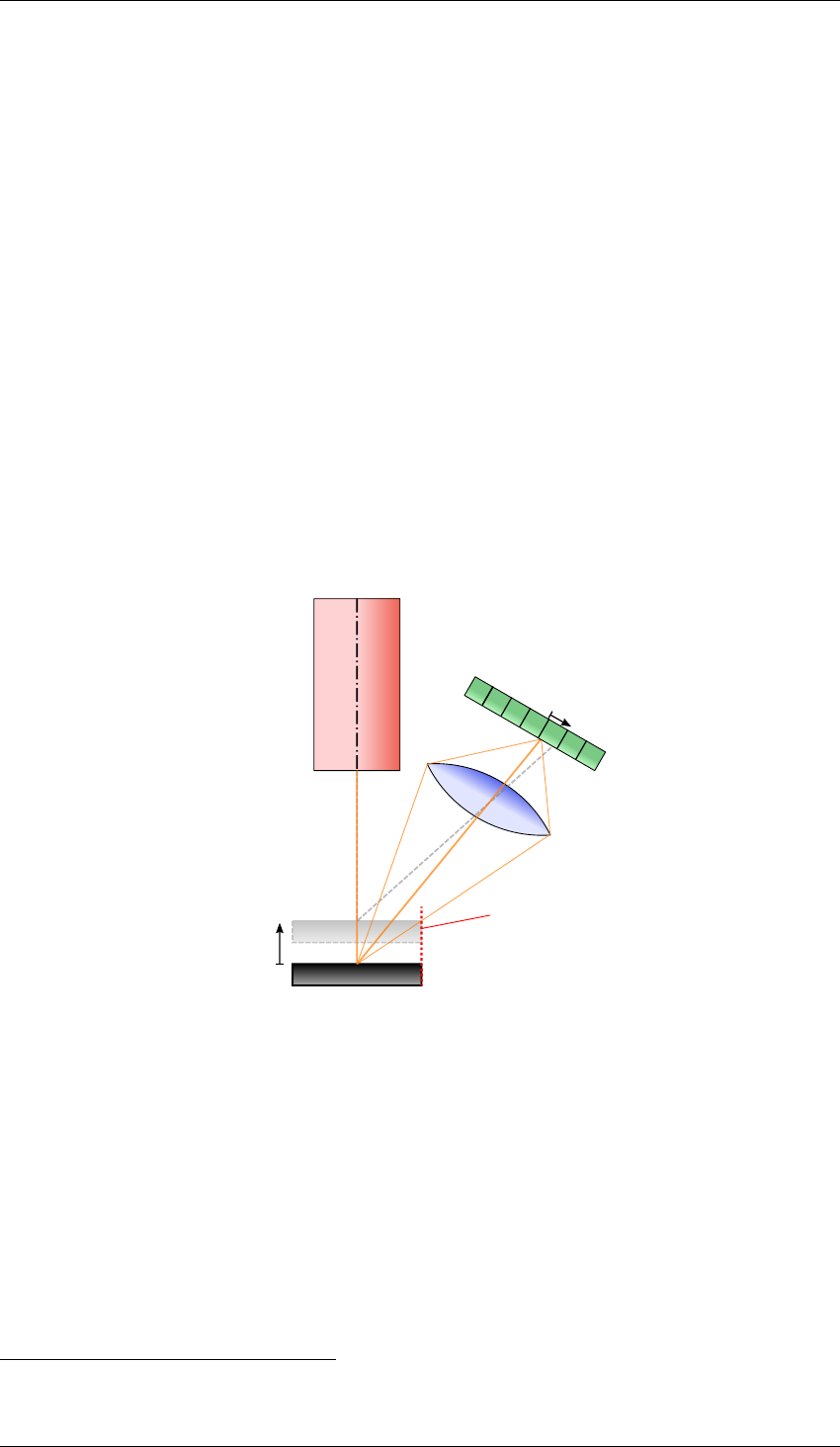

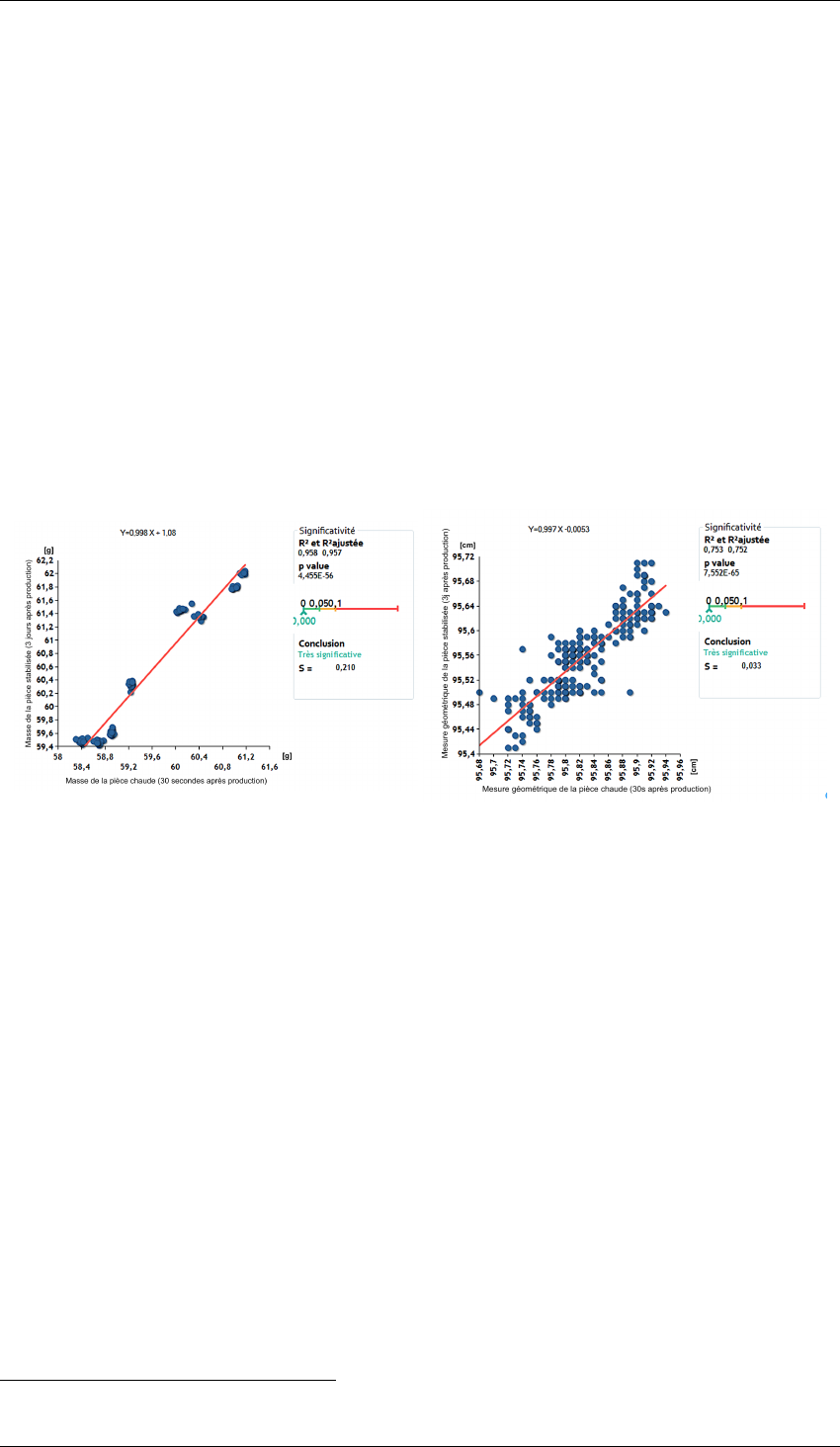

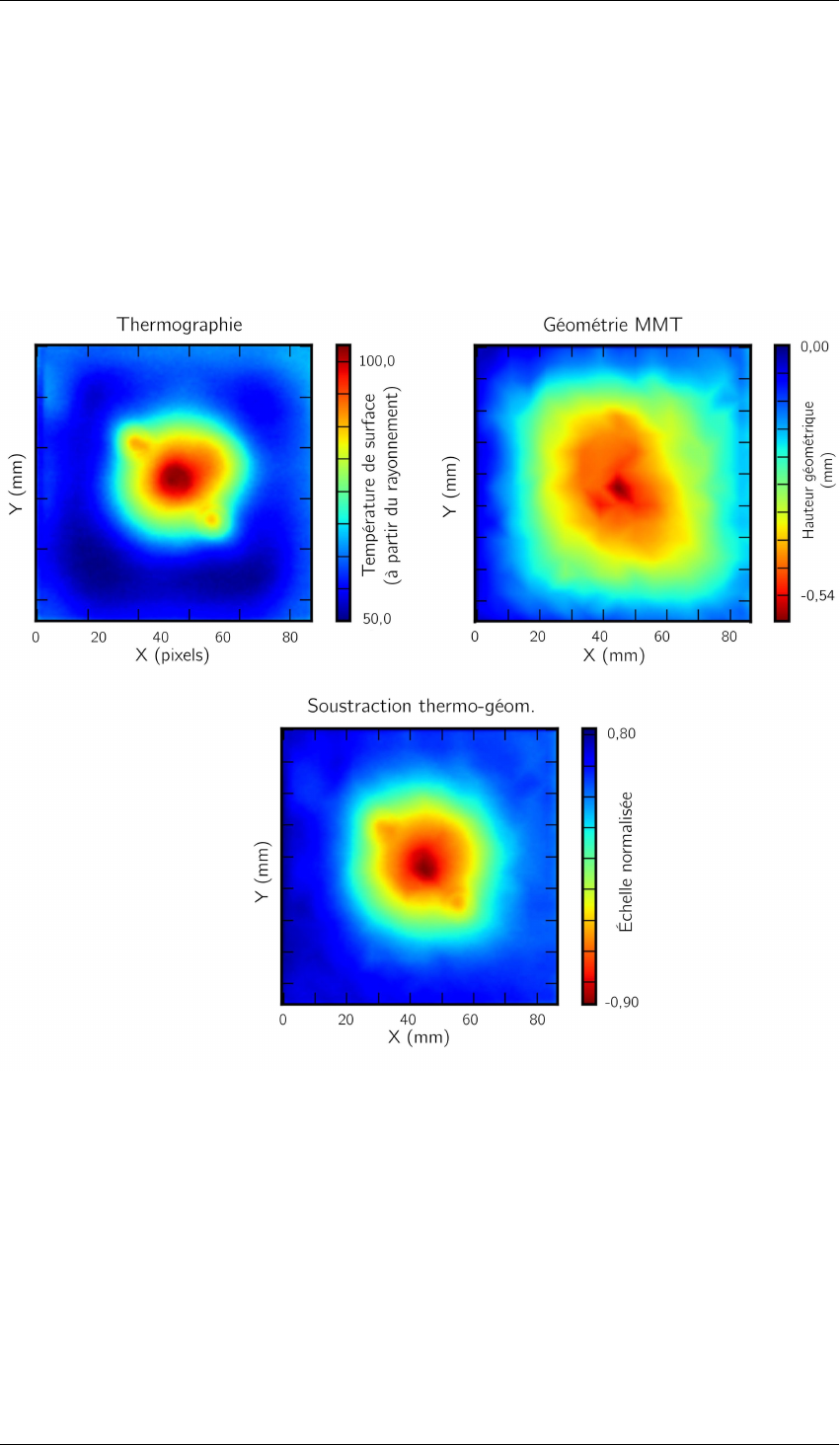

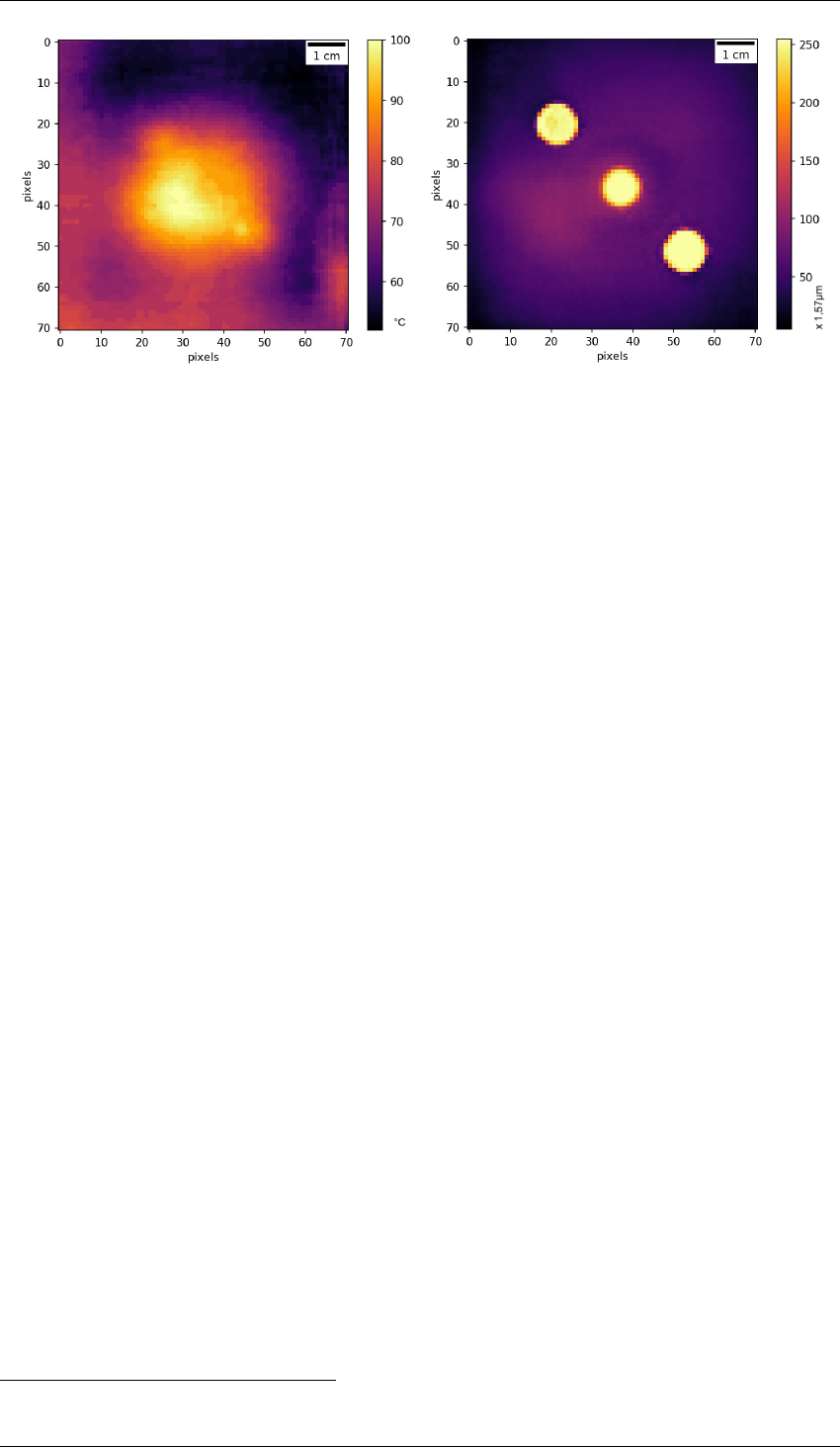

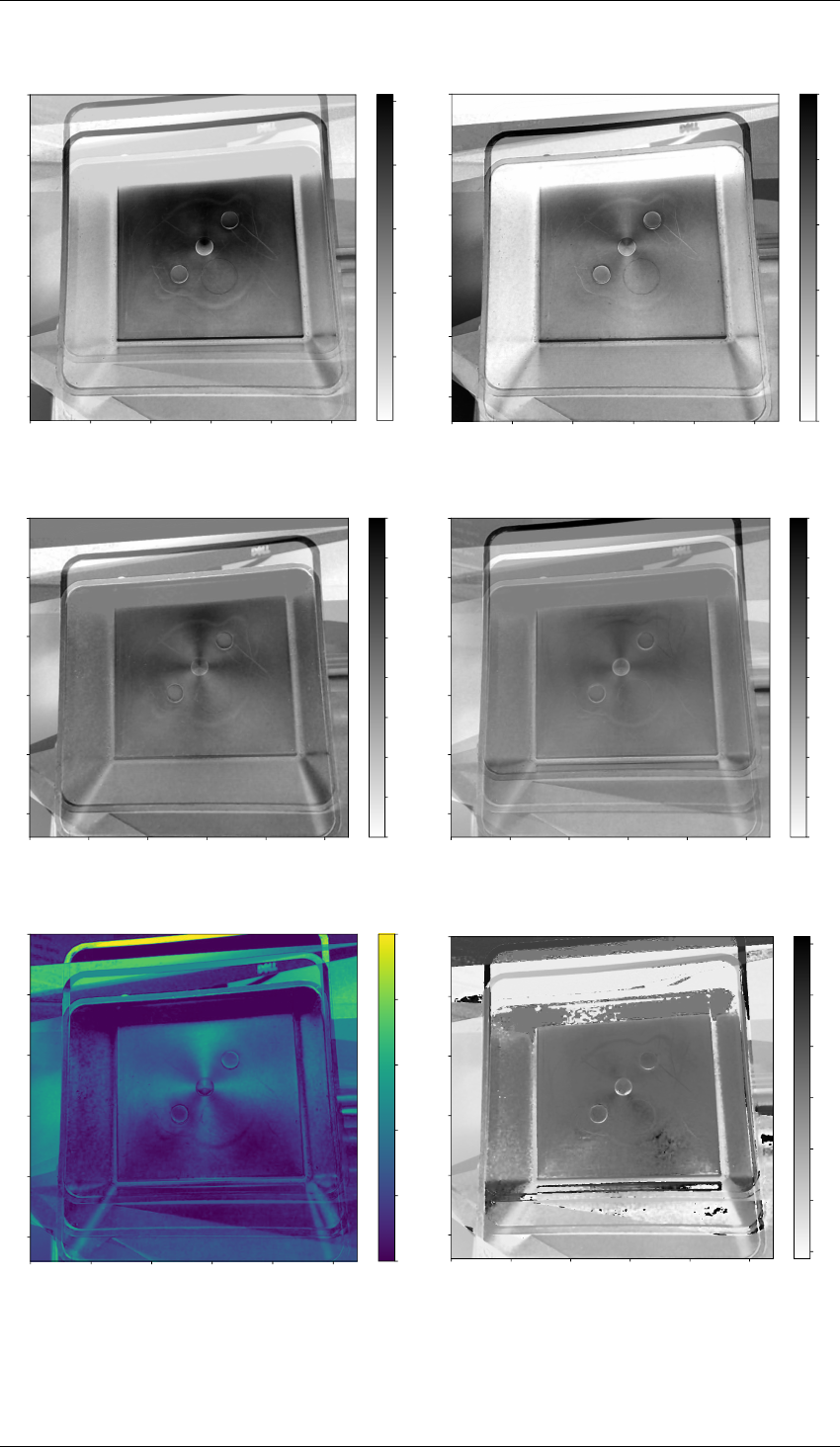

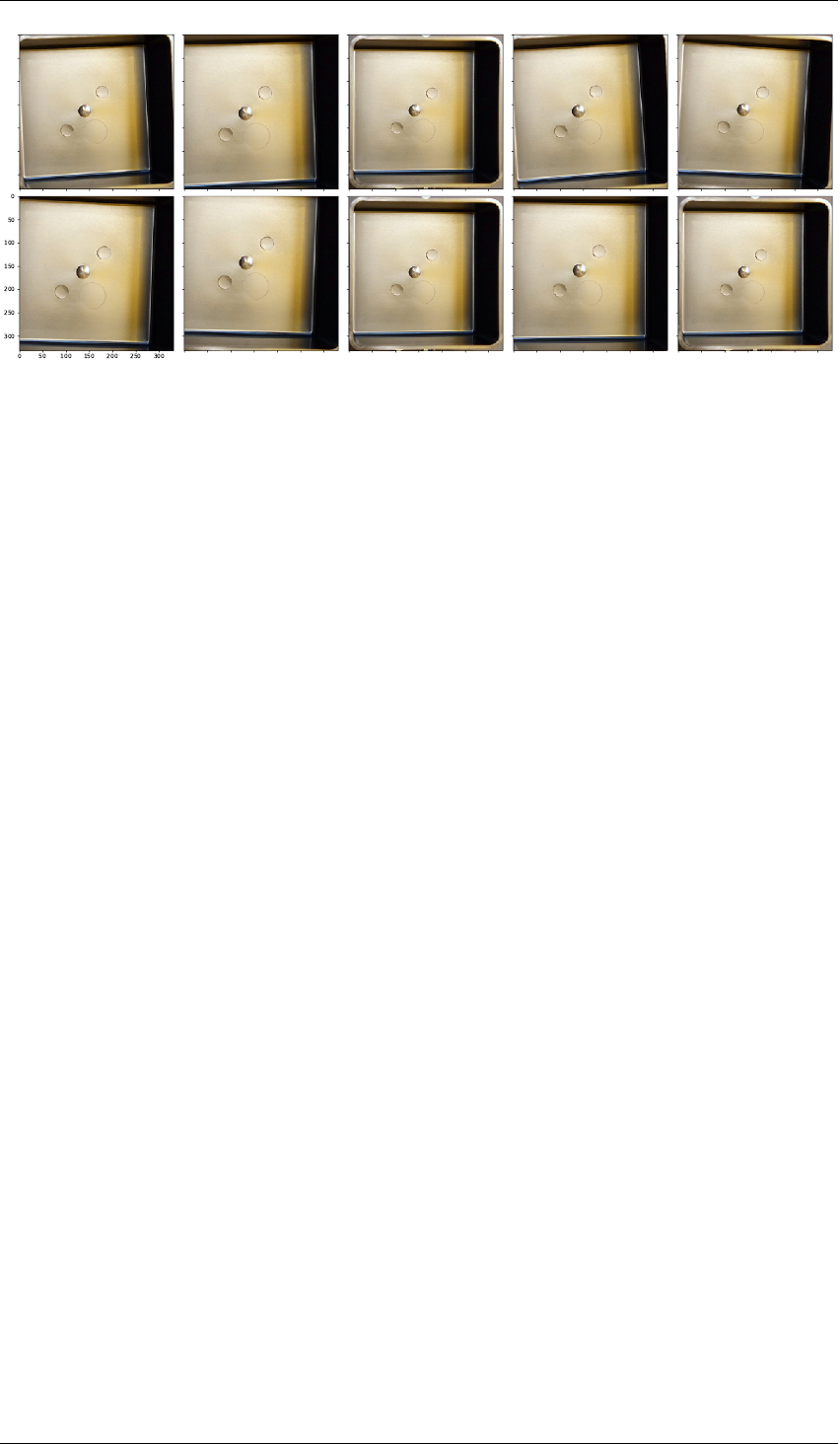

2.3 Apport de la thermographie pour le contrôle de la géométrie des pièces . . . . . . 39

2.3.1 Essai expérimental de thermographie des pièces en sortie du moule . . . 39

2.3.2 Extraction de la géométrie à partir de l’image thermique . . . . . . . . . 41

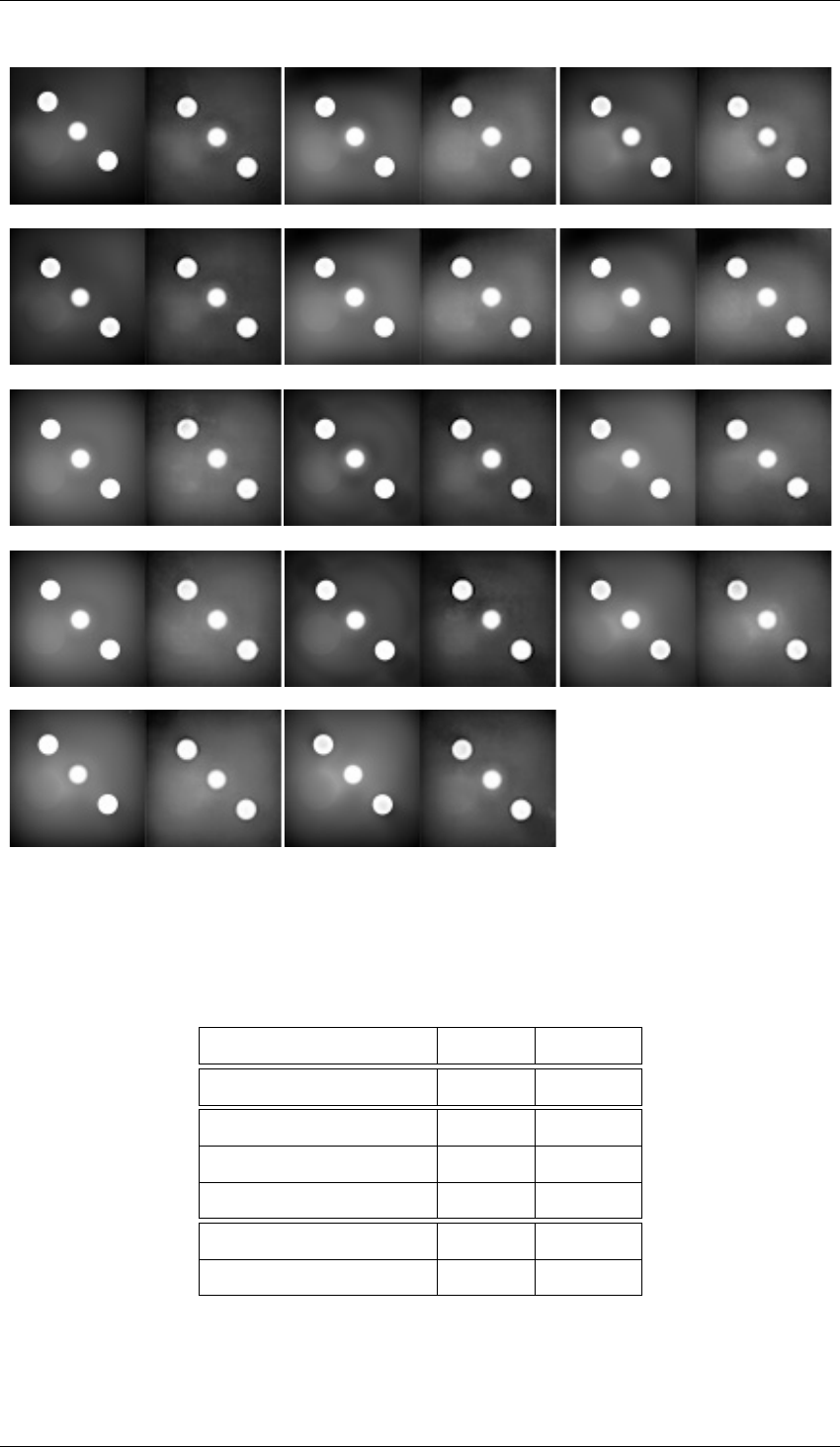

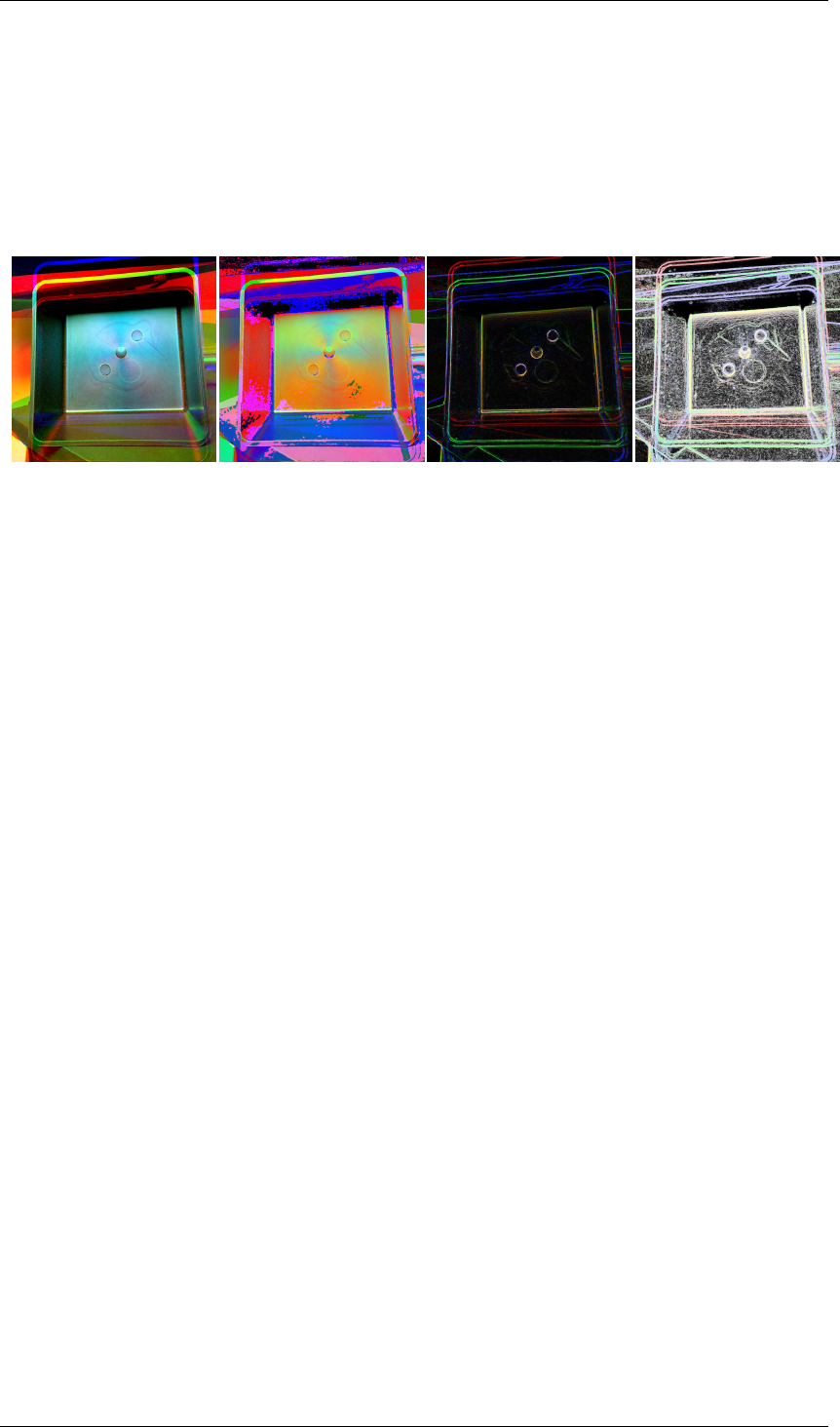

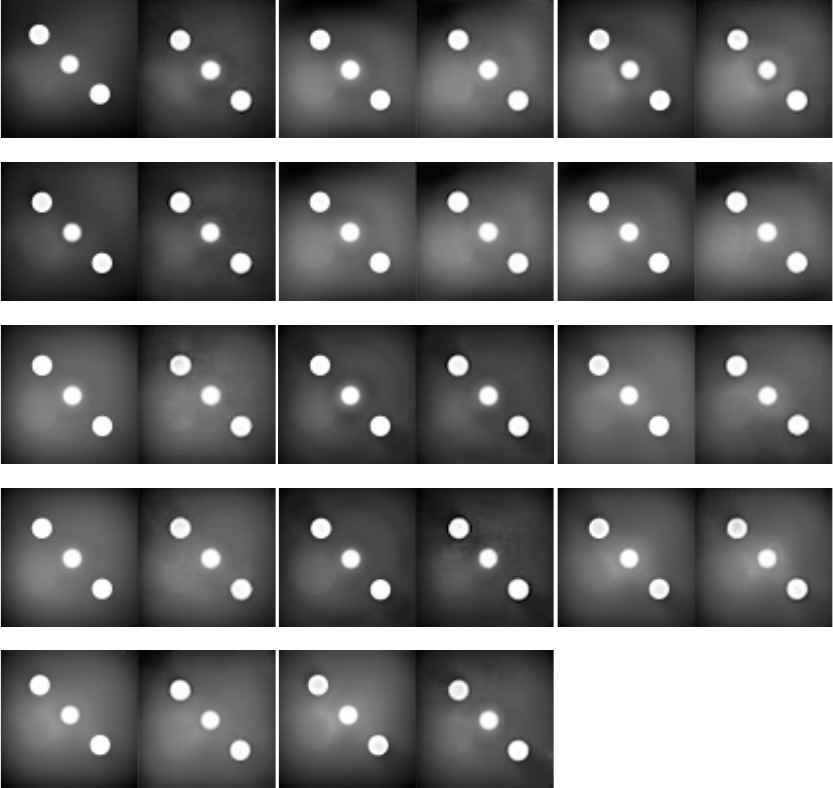

2.4 Apport de la polarimétrie pour le contrôle des défauts d’aspect . . . . . . . . . . 45

2.4.1 Polarimétrie pour mettre en valeur les défauts des pièces plastiques . . . 45

2.4.2 Conception d’un capteur polarimétrique bas-coût . . . . . . . . . . . . . 46

2.4.3 Apport de la polarimétrie sur les performances d’un classifieur de la qualité 50

2.5 Traitement et fusion de l’information issue de mesures multimodales . . . . . . . 53

2.5.1 Nécessité de l’extraction de l’information pertinente . . . . . . . . . . . 53

v

Table des matières

2.5.2 Traitement d’images amont . . . . . . . . . . . . . . . . . . . . . . . . 54

2.5.3 Descripteurs statistiques . . . . . . . . . . . . . . . . . . . . . . . . . . 54

2.5.4 Sélection automatique de descripteurs pertinents . . . . . . . . . . . . . 59

2.5.5 Description d’images par apprentissage statistique . . . . . . . . . . . . 60

2.6 Synthèse et perspectives . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

2.6.1 Synthèse : la mesure non-invasive en cycle industrielle . . . . . . . . . . 61

2.6.2 Perspectives de recherche . . . . . . . . . . . . . . . . . . . . . . . . . 61

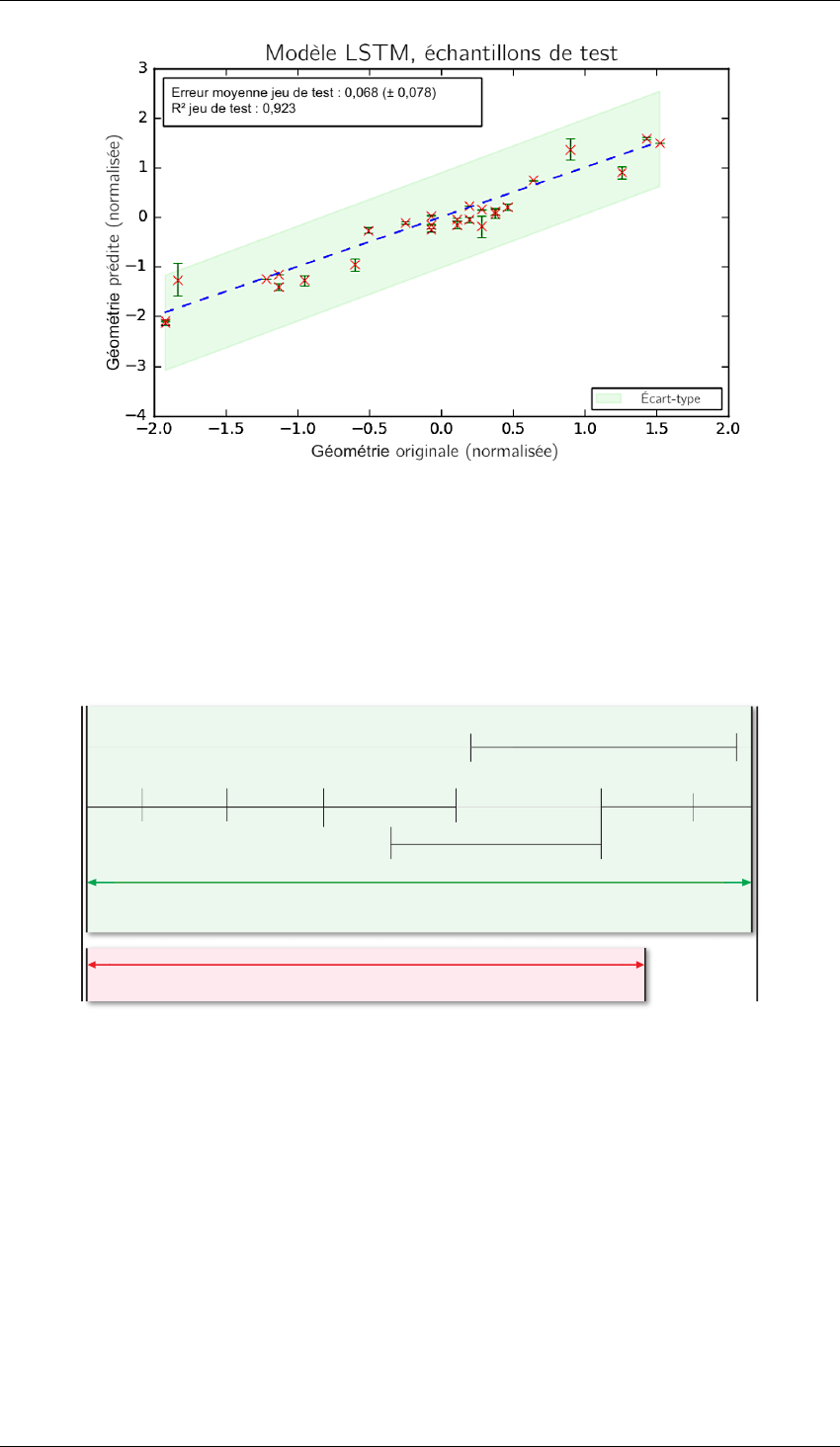

3 Modélisation de la notion de qualité par apprentissage 66

3.1 Construction d’un jeu de données représentatif . . . . . . . . . . . . . . . . . . . 68

3.1.1 Exploration humaine en cycle de production . . . . . . . . . . . . . . . . 68

3.1.2 Réglage automatique du procédé pour la création d’un jeu de données . . 68

3.1.3 Annotation humaine du jeu de données en contexte industriel . . . . . . . 69

3.1.4 Conclusion : transmission de l’expertise humaine en condition industrielle 74

3.2 Construction d’une métrique de la qualité par apprentissage . . . . . . . . . . . . 76

3.2.1 Apprentissage statistique supervisé . . . . . . . . . . . . . . . . . . . . 76

3.2.2 Apprentissage par transfert de domaine . . . . . . . . . . . . . . . . . . 80

3.2.3 Apprentissage semi-supervisé . . . . . . . . . . . . . . . . . . . . . . . 81

3.2.4 Apprentissage non-supervisé . . . . . . . . . . . . . . . . . . . . . . . . 88

3.3 Optimisation automatique des hyper-paramètres d’un modèle . . . . . . . . . . . 105

3.3.1 Optimisation par recherche aléatoire . . . . . . . . . . . . . . . . . . . . 106

3.3.2 Optimisation par méta-modèle bayésien . . . . . . . . . . . . . . . . . . 106

3.3.3 Méthodes de réduction du coût d’évaluation du méta-modèle . . . . . . . 109

3.3.4 Optimisation par algorithmes bandits . . . . . . . . . . . . . . . . . . . 110

3.3.5 Optimisation par algorithmes évolutionnistes . . . . . . . . . . . . . . . 111

3.3.6 Optimisation de l’architecture de réseaux de neurones profonds . . . . . 111

3.4 Conclusion : modélisation par apprentissage pour l’industrie . . . . . . . . . . . 113

4 Système de contrôle de la qualité par apprentissage à partir de l’imagerie non-

conventionnelle 117

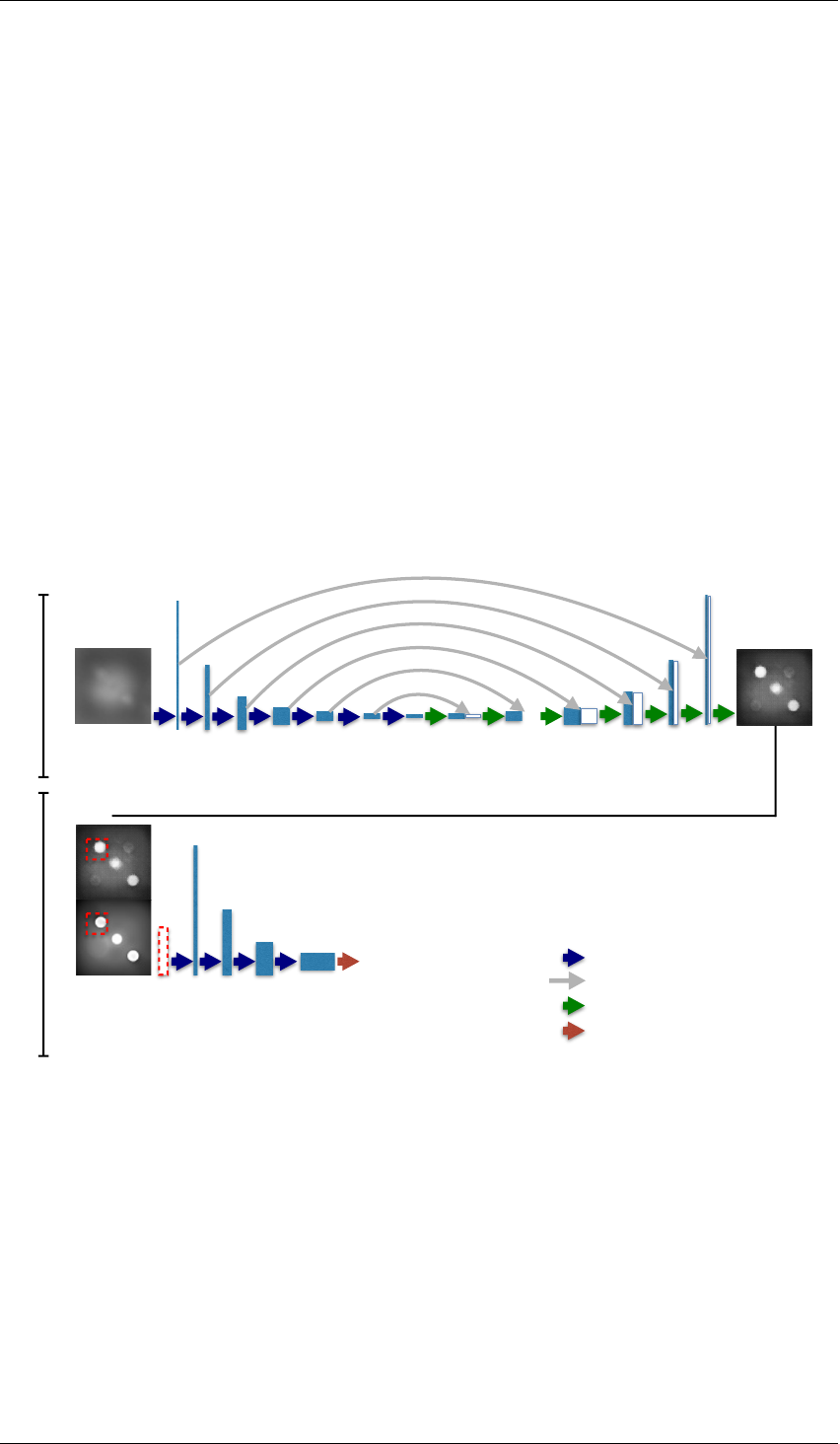

4.1 Description du système de contrôle de la qualité proposé . . . . . . . . . . . . . 118

4.1.1 Dispositif d’acquisition d’images polarimétriques et thermiques en ligne

de production . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 118

4.1.2 Solution logicielle d’analyse d’image pour inférer la qualité . . . . . . . 120

4.2 Validation expérimentale : applications industrielles . . . . . . . . . . . . . . . . 127

4.2.1 Essai "boîte noire" au Centre Techniques IPC . . . . . . . . . . . . . . . 127

4.2.2 Essai "plaques" confidentiel . . . . . . . . . . . . . . . . . . . . . . . . 131

4.2.3 Discussions et limites du système proposé . . . . . . . . . . . . . . . . . 131

4.3 Conclusion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 132

4.4 Perspectives . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 132

Conclusion générale 134

Bibliographie 137

Table des figures 159

Liste des tableaux 163

Annexes 165

vi

Table des matières

A Maîtrise du procédé d’injection-moulage des thermoplastiques 165

A.1 Réglage initial du point de fonctionnement . . . . . . . . . . . . . . . . . . . . . 167

A.1.1 Apport des systèmes experts . . . . . . . . . . . . . . . . . . . . . . . . 168

A.2 Régulation du point de fonctionnement . . . . . . . . . . . . . . . . . . . . . . . 168

A.2.1 Utilisation de l’automatique . . . . . . . . . . . . . . . . . . . . . . . . 169

A.2.2 Apport du contrôle adaptatif . . . . . . . . . . . . . . . . . . . . . . . . 170

A.2.3 Apport de la modélisation par réseaux de neurones . . . . . . . . . . . . 171

A.3 Détection de situations hors-contrôles . . . . . . . . . . . . . . . . . . . . . . . 171

A.3.1 Analyse en Composante Principale . . . . . . . . . . . . . . . . . . . . 172

A.3.2 Maîtrise Statistique des Procédés . . . . . . . . . . . . . . . . . . . . . . 172

A.4 Pilotage des caractéristiques de la pièce produite . . . . . . . . . . . . . . . . . . 173

A.4.1 Ajustement du procédé à partir de caractéristiques prédites . . . . . . . . 174

A.4.2 Ajustement à partir des caractéristiques mesurées sur le produit . . . . . 175

B Étude technico-économique du mesurage des caractéristiques du produit 177

C Économie du secteur de la plasturgie française 178

D Plan d’expériences 179

E Apprentissage statistique 182

E.1 Métrique de performances d’un classifieur . . . . . . . . . . . . . . . . . . . . . 182

E.1.1 Justesse équilibrée . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 183

E.1.2 Matrice de confusion . . . . . . . . . . . . . . . . . . . . . . . . . . . . 183

E.1.3 Précision et rappel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 183

E.1.4 F-mesure . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 183

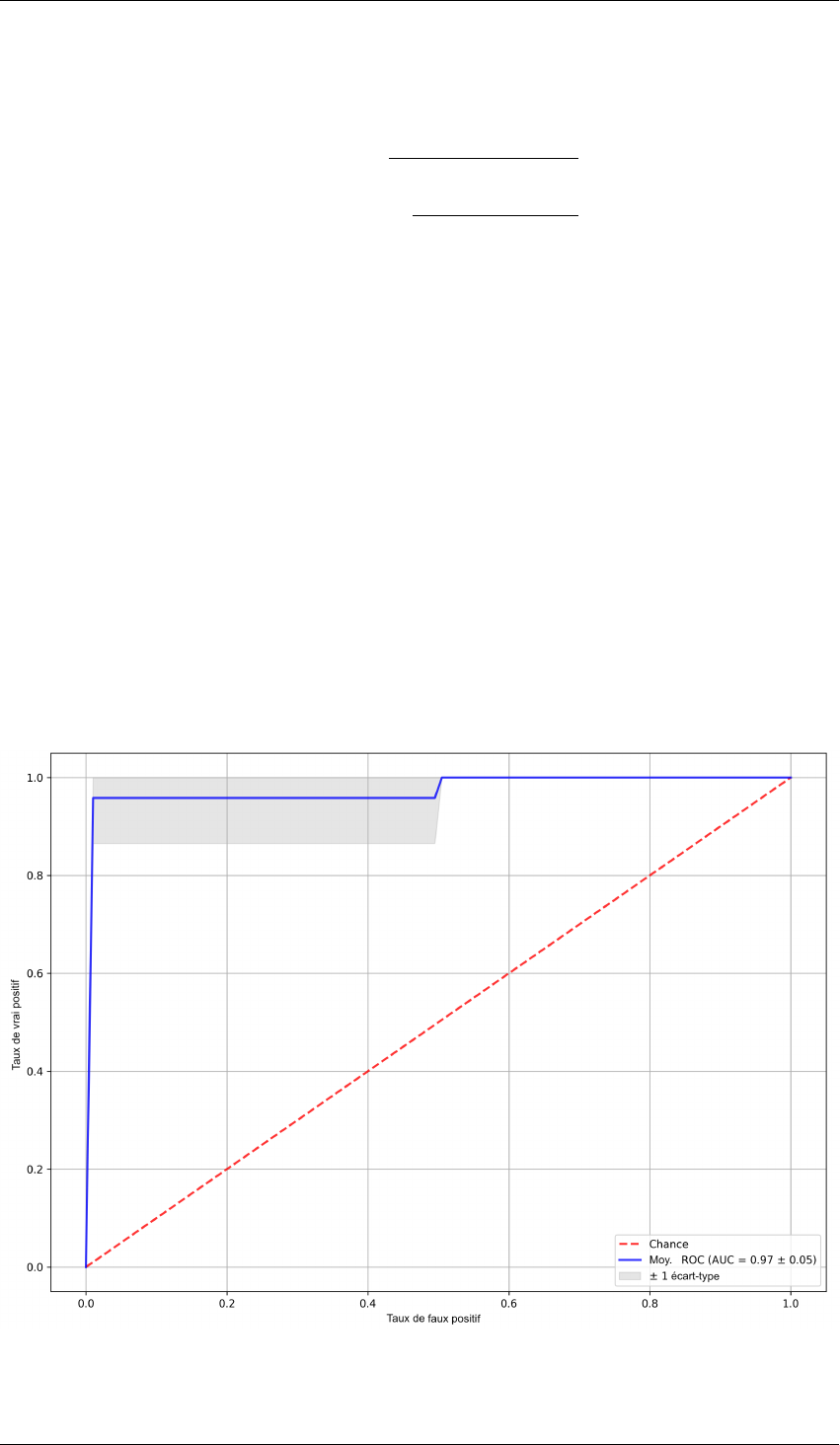

E.1.5 Courbe ROC . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 184

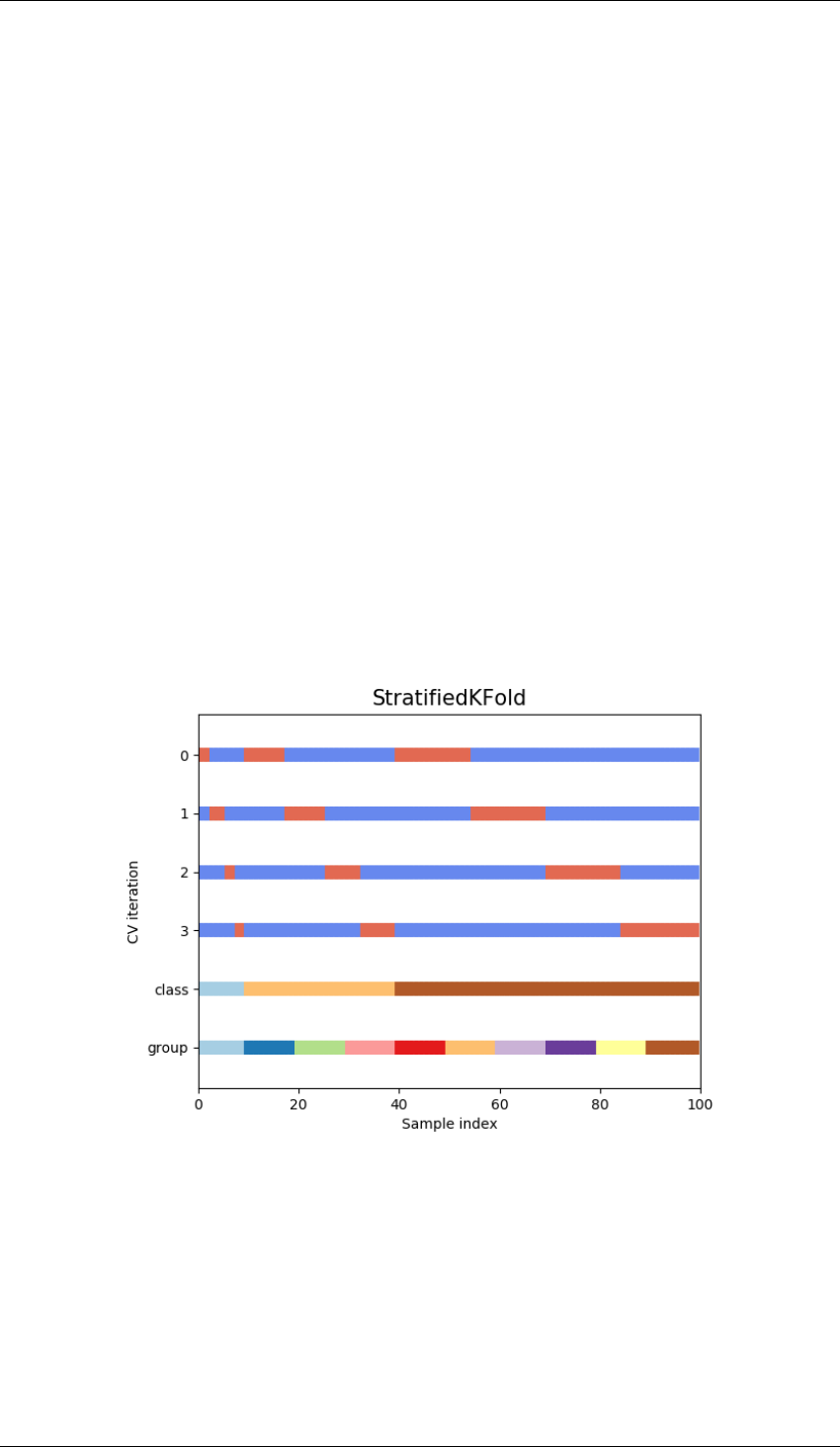

E.1.6 Validation croisée pour la comparaison des performances de classifieurs . 185

E.2 Apprentissage statistique traditionnel . . . . . . . . . . . . . . . . . . . . . . . . 186

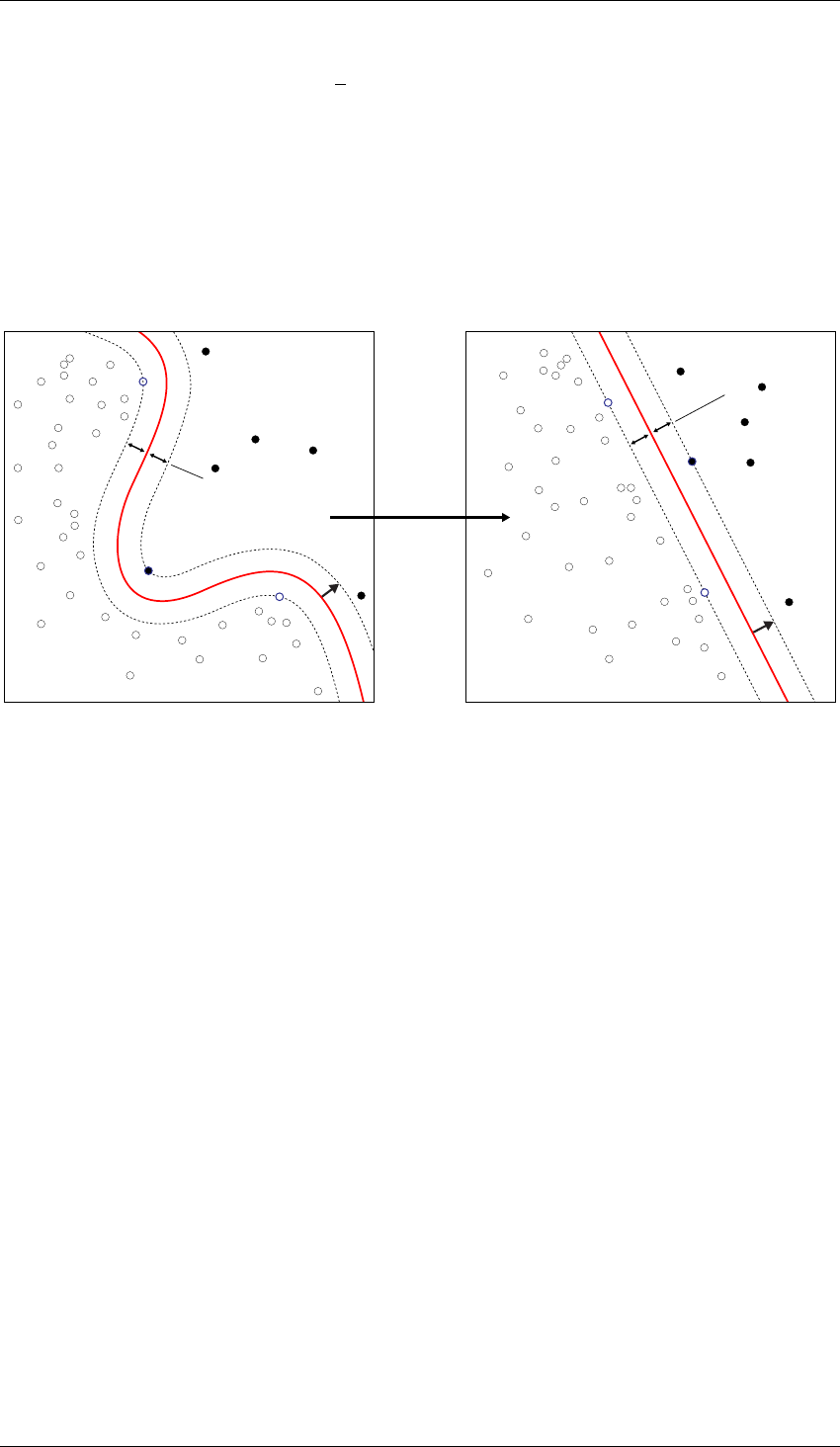

E.2.1 Machine à vecteurs de support . . . . . . . . . . . . . . . . . . . . . . . 186

E.2.2 K-plus-proches voisins . . . . . . . . . . . . . . . . . . . . . . . . . . . 187

E.2.3 Bagging . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 188

E.2.4 Forêt d’arbres décisionnels . . . . . . . . . . . . . . . . . . . . . . . . . 188

E.2.5 Boosting . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 189

E.2.6 Réseaux de neurones . . . . . . . . . . . . . . . . . . . . . . . . . . . . 189

F Réseau de convolution profond, Deep Learning 191

F.1 Historique . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 191

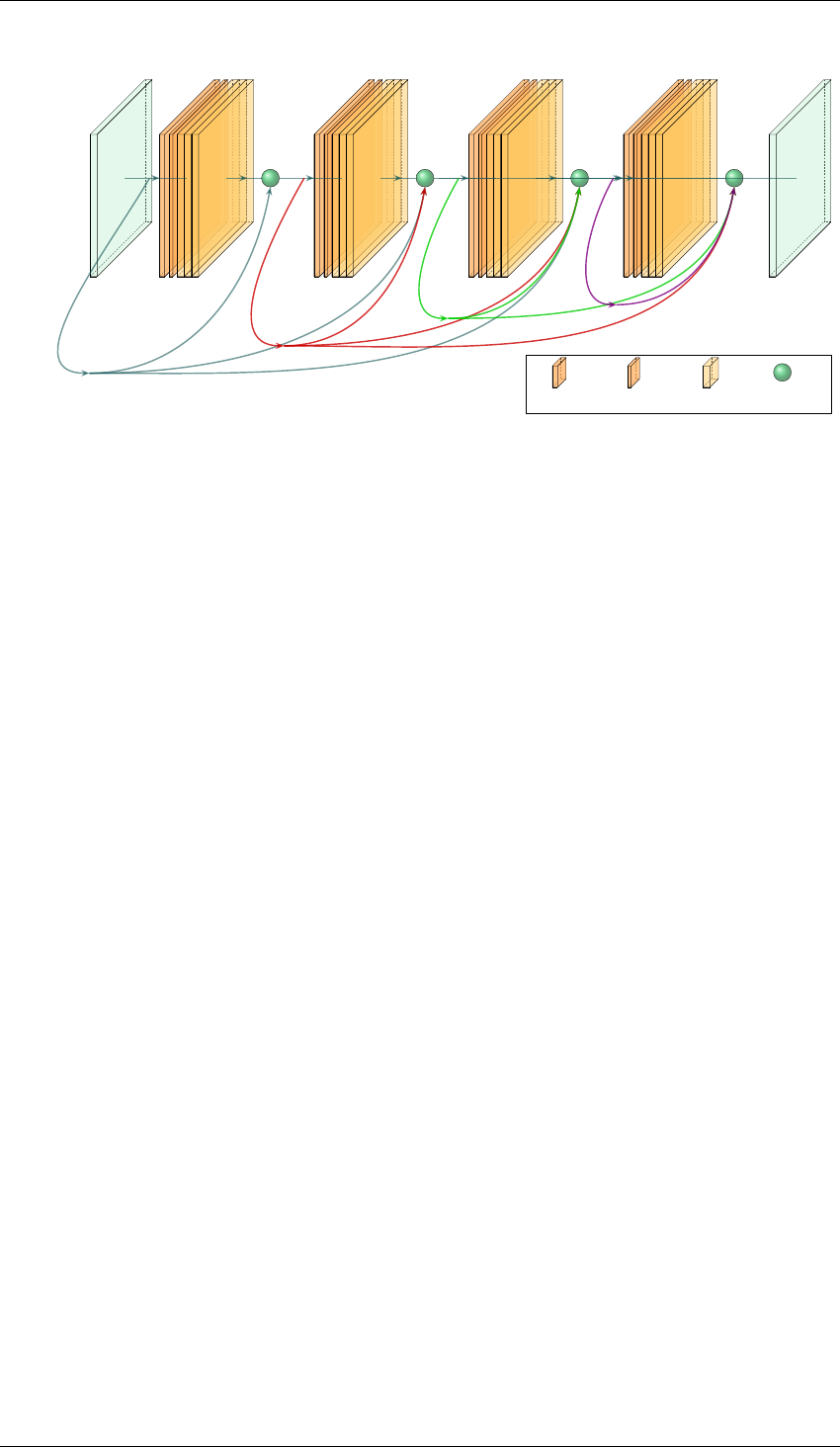

F.2 Réseaux de convolutions résiduels . . . . . . . . . . . . . . . . . . . . . . . . . 192

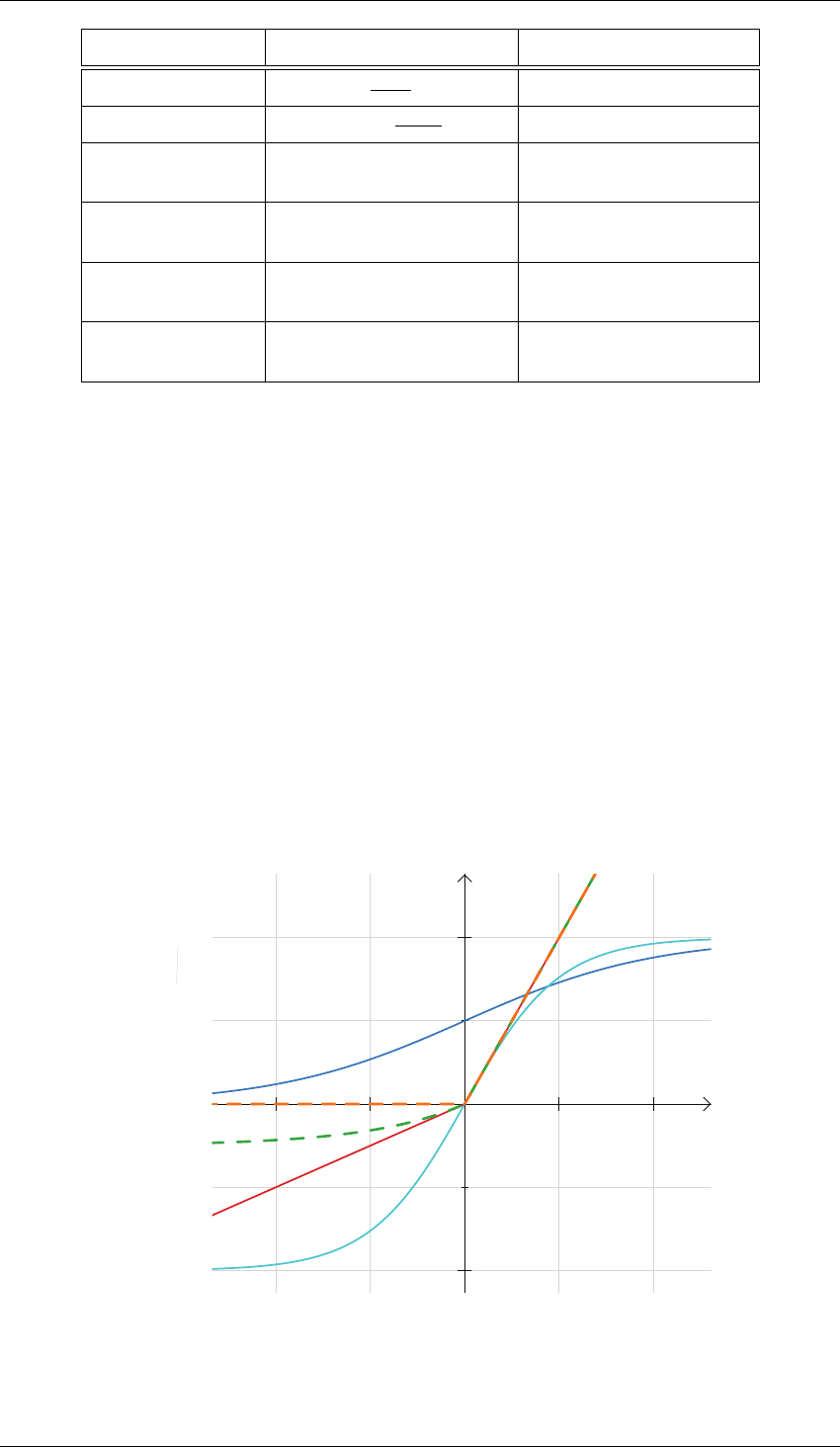

F.3 Fonctions d’activations . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 193

F.4 Méthodes de régularisation pour limiter le sur-apprentissage . . . . . . . . . . . 195

F.4.1 Dropout . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 195

F.4.2 Normalisation de lots . . . . . . . . . . . . . . . . . . . . . . . . . . . . 195

F.4.3 Arrêt prématuré de l’apprentissage . . . . . . . . . . . . . . . . . . . . . 196

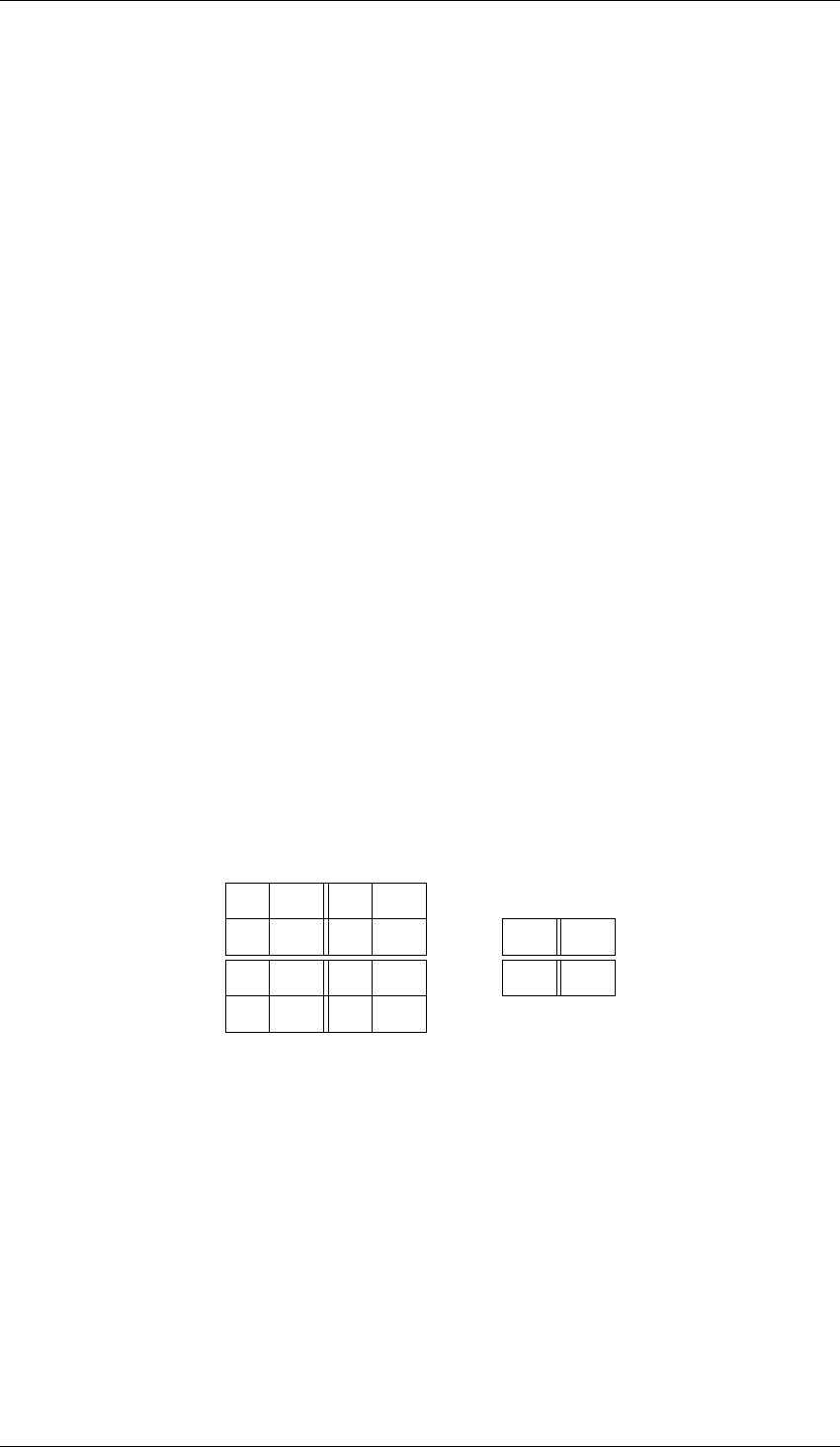

F.4.4 Réduction de dimensions par interpolation . . . . . . . . . . . . . . . . . 196

F.4.5 Pénalisation sur les poids . . . . . . . . . . . . . . . . . . . . . . . . . . 198

F.4.6 Augmentation artificielle du jeu de données . . . . . . . . . . . . . . . . 198

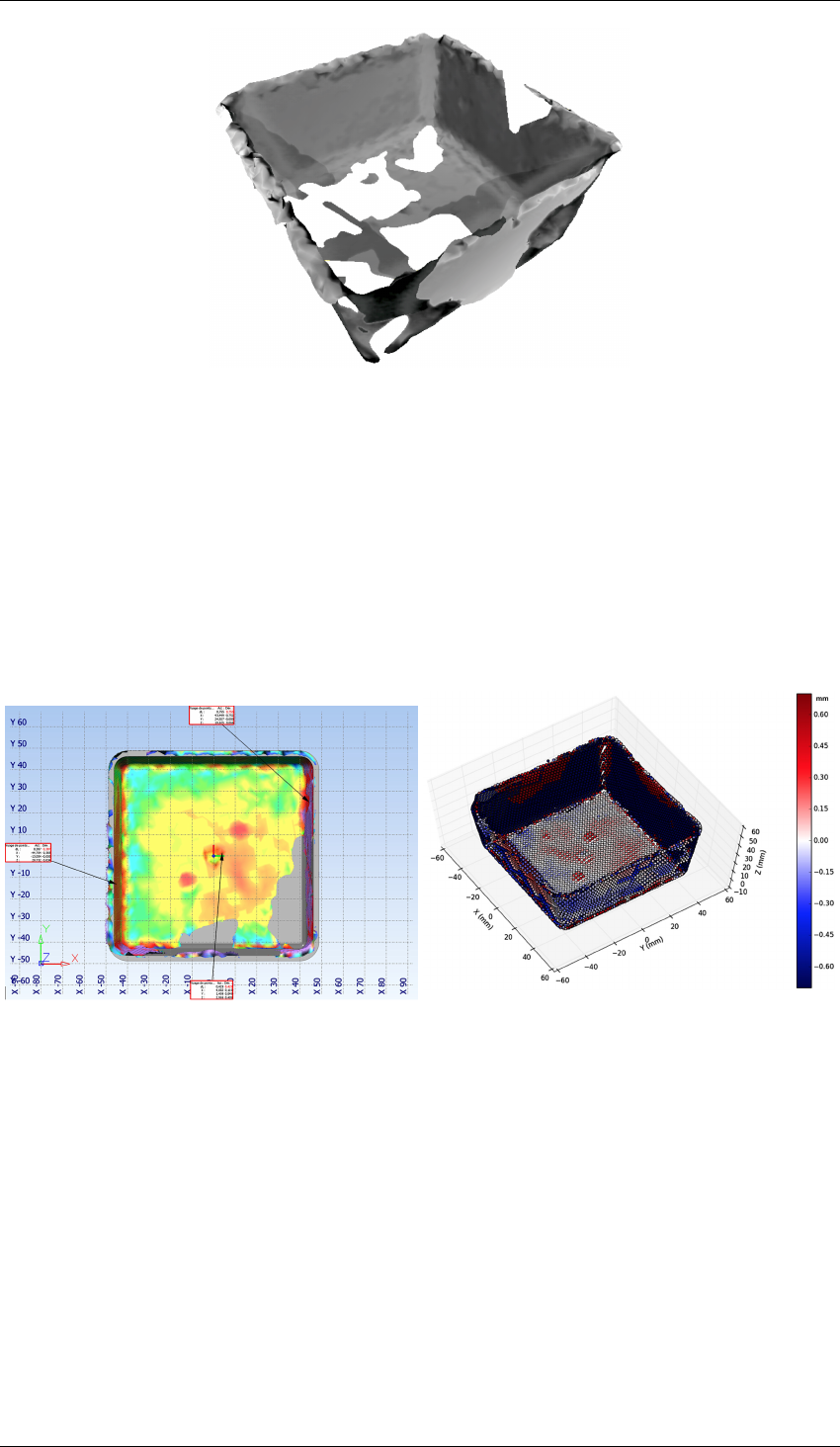

G Résultats de l’extraction de la géométrie d’une pièce à partir de son image thermique200

H Confidentiel - Essai "plaques" 201

H.1 Essai "plaques" confidentiel . . . . . . . . . . . . . . . . . . . . . . . . . . . . 201

vii

Introduction

Introduction

e travail de doctorat s’inscrit dans le projet de recherche collaborative FUI

2

SAPRISTI

3

du

21

ème

appel à projet FUI Régions.

4

. L’obtention d’une chaîne de fabrication compétitive passe par

l’optimisation du procédé de production. Le projet FUI SAPRISTI s’intéresse en particulier au

procédé d’injection-moulage des thermoplastiques dans le secteur automobile. C’est pourquoi il

est labellisé par trois pôles de compétitivité :

— Plastipolis,

— iDforCAR,

— Mont-Blanc Industries.

Le consortium FUI SAPRISTI est constitué de laboratoires académiques, d’industriels

transformateurs et du Centre Technique français de la plasturgie IPC. Ainsi, les partenaires du

consortium SAPRISTI sont :

— Acsystème, développeur et intégrateur de solutions en automatique et traitement de

l’information,

— Le Centre Technique IPC, acteur européen en développement et recherche pour le secteur

de la plasturgie,

— Le laboratoire LaMCoS de l’INSA de Lyon, expert de la modélisation du procédé

d’injection-moulage des thermoplastiques,

— Plastic Omnium, équipementier automobile mondial

— Renault, automobiliste concepteur et équipementier,

— SISE, acteur européen de la régulation des procédés en plasturgie, dont notamment le

contrôle de l’injection séquentiel,

— Le laboratoire SYMME

5

de l’Université Savoie Mont Blanc, expert en réglage automatique

et en optimisation de procédés industriels, dans le cadre de son axe de recherche sur la

Qualité industrielle.

L’injection-moulage des thermoplastiques est un procédé de production bas-coût et haut-

volume. C’est un procédé particulièrement intéressant car il permet d’obtenir avec un temps de

cycles courts des pièces de toutes dimensions aux géométries complexes; qui sont très proches du

produit final. Le marché de la plasturgie représente en France 3500 entreprises pour 30,2 Milliards

de Chiffre d’Affaires en 2018

6

. Dans ce contexte, l’enjeu du projet FUI SAPRISTI est triple :

— Déterminer des indicateurs pertinents à mettre sous contrôle.

2. FUI : Fond Unique Interministériel

3. SAPRISTI : Système Autocorrectif pour la PRoduction zéro défaut de pIèces pLaSTIques

4. Résultats du 21

ème

appel à projets FUI sur competitivite.gouv.fr : 60 projets bénéficieront d’une aide de l’État de

43 Millions d’Euros ainsi que d’une aide des collectivités territoriales et des fonds communautaires (FEDER) de 37,8

Millions d’Euros.

5. SYMME : SYstèmes et Matériaux pour la MÉcatronique

6. Synthèse 2018 du secteur réalisée par la Fédération Française de la Plasturgie.

1

Introduction

— Mieux comprendre les phénomènes physiques qui entrent en jeu dans le procédé, afin de

modéliser le procédé en prenant en compte les indicateurs sélectionnés.

— Optimiser le procédé à partir de la modélisation et des indicateurs, afin de produire une

qualité optimale.

Ce travail de doctorat s’inscrit dans ce projet. L’objectif à long terme du FUI SAPRISTI est de

mettre sous contrôle le procédé, afin de maximiser la qualité de la production.

Nous avons choisi de mettre en place un moyen de contrôle des caractéristiques des pièces en

ligne de production. D’autres approches réalisent des mesurages sur le procédé plutôt que sur le

produit. C’est pourquoi nous avons orienté nos travaux vers la conception d’un moyen de mesure

automatique de la qualité des produits, en ligne de production.

Dans le cas de l’injection-moulage des thermoplastiques, aucun système de mesure de la

qualité ne répond actuellement aux exigences des partenaires du FUI SAPRISTI ; en particulier

avec les contraintes techniques issues de l’intégration de la mesure de la qualité en ligne de

production. Des échanges avec les partenaires du FUI SAPRISTI nous ont permis de prendre

en compte les limites que posent le procédé industriel. Nous avons identifié trois verrous au

déploiement massif du contrôle qualité à cent pourcent dès la sortie de la machine :

— économique : pour être déployé sur chaque machine le coût du système doit être faible,

— technologique : respect de la durée du cycle, peu invasif pour le procédé de production et

capable d’extraire l’information sur la qualité des produits à partir des mesures,

— humain : capable de modéliser la perception qualité de l’expert humain.

Nous évaluerons et chercherons à résoudre chacun de ces verrous afin de proposer un moyen de

mesure industriellement viable.

Afin d’identifier les variables du procédé qui sont susceptibles de contenir une information sur

la qualité du produit, nous avons réalisé une étude de la littérature. De nombreuses variables ont été

étudiées depuis 1975. La pratique industrielle actuelle propose d’utiliser des mesurages intégrées

dans l’outillage. L’intégration des capteurs nécessaire à ces mesures est invasive, puisqu’il est

nécessaire de modifier les outillages. C’est à dire que le travail d’ingénierie nécessaire à la

conception de l’outillage en intégrant les capteurs est coûteux. De plus, l’instrumentation des

capteurs est fragile et leur maintenance nécessite un arrêt prolongé de la production, puisque c’est

l’outillage complet qui doit être expertisé. Afin de lever les verrous économiques et technologiques

qui limitent le déploiement du contrôle qualité, nous n’avons pas retenu la mesure invasive dans

nos travaux. Cela permet de limiter la complexité de la mise en place des dispositifs de mesure.

C’est pourquoi nous avons défini le périmètre de notre recherche au contrôle non-invasif pour le

procédé industriel, de la qualité des produits.

L’expérimentation occupe une part importante de nos travaux. Dans un premier temps, cela

nous a permis de comprendre le procédé et la pratique industrielle. Dans un second temps, nous

avons étudié l’utilisation de moyens de mesurages issus de l’imagerie non-conventionnelle :

scanner laser, thermographie, polarimétrie, ainsi que de mesures intégrées dans l’outillage que

nous n’avons pas retenu. L’imagerie non-conventionnelle permet d’acquérir des informations que

l’œil humain ne peut percevoir. Nous nous appuyons sur l’expérimentation et la mesure pour

construire nos modèles. Dans le cas où l’on dispose d’un grand nombre de cas d’étude, cette

démarche est particulièrement adaptée à l’utilisation de l’apprentissage statistique pour modéliser

les phénomènes.

À partir des résultats des mesures, il s’agit de concevoir un système capable de discerner les

pièces conformes, des pièces non-conformes. Nous orientons nos travaux dans l’utilisation de

méthode d’apprentissage statistique. L’expert qualité humain transmet son savoir au système de

mesure, qui réalise le contrôle de manière autonome.

2

Introduction

Ces travaux de doctorat ont fait l’objet de communications en congrès scientifiques

internationaux [NPP17b; NPP17a; Nag+17; Nag+18; Nag+19], ainsi que d’un colloque national

[NPP17b].

Ce manuscrit est constitué de quatre chapitres qui peuvent être indépendamment parcourus.

Le lecteur sera orienté au gré de sa lecture, vers les sections d’autres chapitres, lorsque des

informations complémentaires pourront lui être utiles.

Le premier chapitre présente de manière détaillée le contexte industriel du travail de doctorat

et les objectifs de recherche pour le déploiement du contrôle qualité dès la sortie de l’injection-

moulage. Le second chapitre a pour objectifs de présenter les différentes technologies de

métrologies existantes et de justifier notre choix d’utilisation de l’imagerie non-conventionnelle

thermographique et polarimétrique à partir d’un essai expérimental. Le troisième chapitre propose

d’étudier les méthodes de formalisation de la notion de qualité par apprentissage et de les évaluer

sur notre cas d’application industriel. Nous présenterons les méthodes d’apprentissage supervisé

et non-supervisé, ainsi que la démarche d’annotation d’un jeu de données d’apprentissage. Enfin,

le quatrième chapitre détaille la conception d’un nouveau dispositif de mesure et réalise son

évaluation sur deux cas d’applications industrielles.

En conclusion, un bilan concernant les travaux de ces trois années de doctorat sera dressé. Une

discussion sera proposée concernant les nombreuses perspectives de recherche que nous avons

identifiées.

3

1

Contexte industriel et problématique de recherche

Dans ce premier chapitre, nous présentons le contexte du procédé

d’injection-moulage des thermoplastiques dans lequel s’inscrit nos

travaux. Dans un premier temps, nous étudierons les problématiques

de recherche de la littérature en injection-moulage. Dans un second

temps, nous positionnerons notre travail sur la problématique du du

contrôle de la qualité géométrique et d’aspect en temps de cycle

industriel.

Sommaire

1.1 Le procédé d’injection-moulage des thermoplastiques . . . . . . . . . . . . 6

1.1.1 Paramètres réglables d’une presse à injecter . . . . . . . . . . . . . . . 8

1.2 La qualité d’un produit en injection-moulage des thermoplastiques . . . . 10

1.3 Revue de la recherche académique sur le procédé d’injection-moulage . . . 12

1.3.1 Cartographie bibliographique . . . . . . . . . . . . . . . . . . . . . . 12

1.3.2 Modélisation du procédé d’injection-moulage . . . . . . . . . . . . . . 13

1.3.3 Maîtrise du procédé d’injection-moulage des thermoplastiques . . . . . 17

1.4 Problématique industrielle : le contrôle qualité en ligne de production . . . 19

1.4.1 Viabilité économique du déploiement du mesurage de la qualité en

ligne de production . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

1.4.2 Mesurage des variables d’état du procédé : mesurage indirect des

caractéristiques du produit . . . . . . . . . . . . . . . . . . . . . . . . 20

1.4.3 Mesurage direct des caractéristiques du produit . . . . . . . . . . . . . 21

1.4.4 Cahier des charges pour le contrôle de la qualité en ligne de production 26

1.4.5 Proposition d’une définition du degré d’invasivité d’un système de

mesure pour un procédé . . . . . . . . . . . . . . . . . . . . . . . . . 28

1.4.6 Étude technico-économique du mesurage des caractéristiques du produit 29

1.4.7 Formalisation de la notion de qualité d’une pièce . . . . . . . . . . . . 30

1.5 Conclusion : la problématique du contrôle de la qualité en ligne de production 31

5

Chapitre 1. Contexte industriel et problématique de recherche

1.1 Le procédé d’injection-moulage des thermoplastiques

Figure 1.1 – Une presse à injecter. Photographie originale de Glenn McKechnie c by SA 2.5,

Wikimedia Commons.

La machine qui met en œuvre le procédé d’injection-moulage est la presse à injecter (voir la

Figure 1.1). Un polymère est fondue dans un tube chauffé, appelé le fourreau. Le fourreau contient

une vis pour malaxer la matière. Dans une presse à injecter, on distingue deux parties cinématiques

indépendantes : la vis de dosage et l’outillage amovible. La rotation et l’avance de la vis sont

régulées afin de définir les caractéristiques de la matière fondue qui sera injectée. En particulier,

il s’agit d’homogénéiser la matière fondue afin qu’elle ait une certaine viscosité. L’avancée de la

vis produit une pression sur la matière qui est également régulée : c’est la pression d’injection.

Le procédé d’injection-moulage des thermoplastiques consiste à injecter sous une pression élevée,

généralement supérieure à 100 MPa, le polymère fondu et visqueux dans un moule. La pression

est maintenue pendant le refroidissement de la matière; en particulier jusqu’à ce que le canal par

lequel la matière est entrée dans le moule soit solidifié.

Cette phase de maintien permet de densifier la matière afin de compenser le retrait consécutif

au refroidissement. Le passage de la phase d’injection à la phase de maintien est appelé la

commutation (on parle couramment de "point de commutation"). La phase de maintien se termine

avant le début de la phase d’injection. La phase de dosage, qui est réalisée pendant le moulage

d’une pièce, conditionne les caractéristiques de la matière fondue pour la pièce suivante; il y a un

cycle de décalage.

L’ensemble qui constitue le moule est appelé un "outillage"; ce dernier intègre un système

de régulation thermique à température constante afin de favoriser le refroidissement de la pièce.

L’outillage doit également supporter les contraintes mécaniques des pressions d’injection et l’on

cherche à éviter la déformation de sa géométrie pendant l’injection. C’est pourquoi les outillages

en injection-moulage sont volumineux et massifs en comparaison des dimensions des pièces

produites.

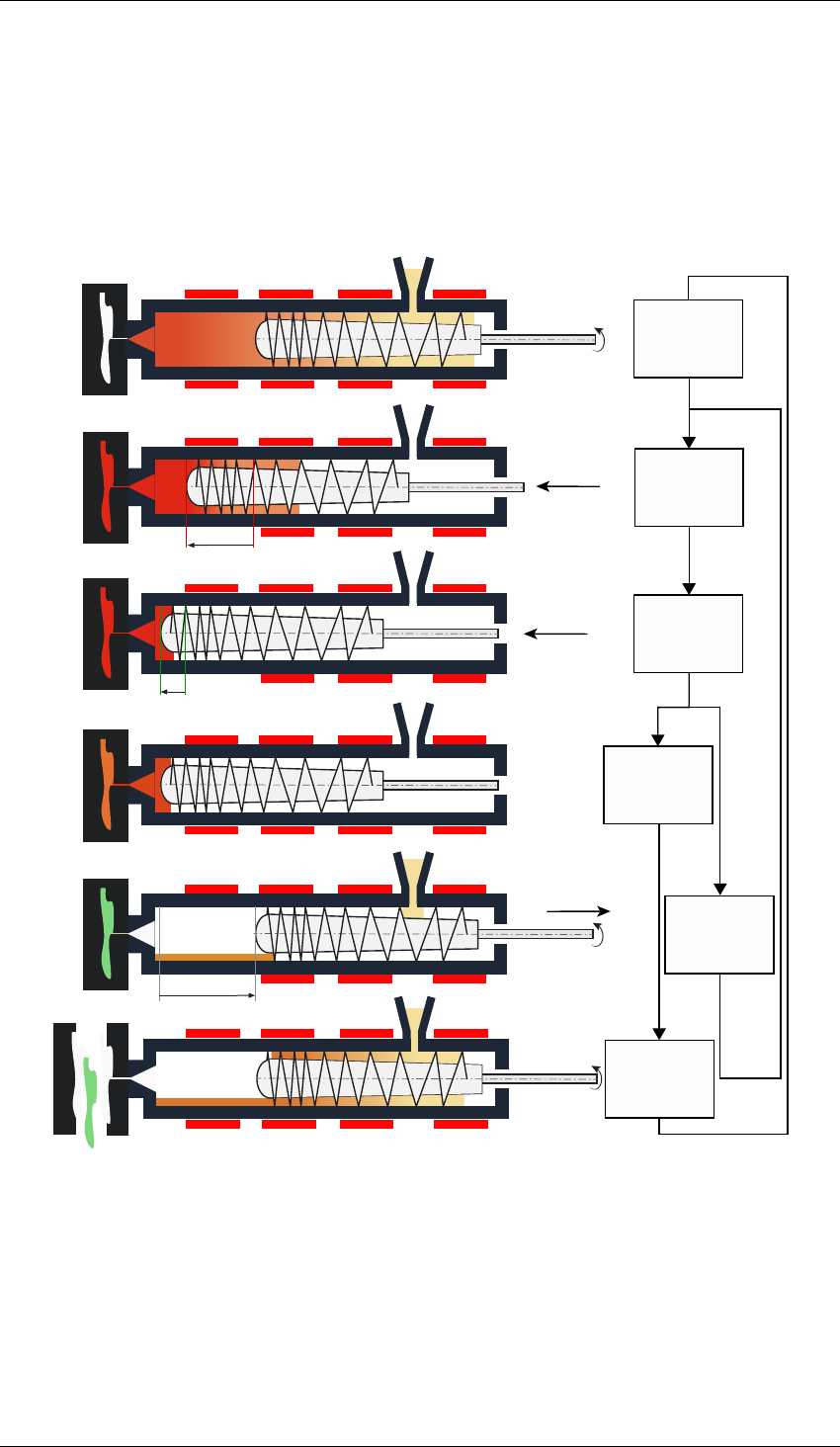

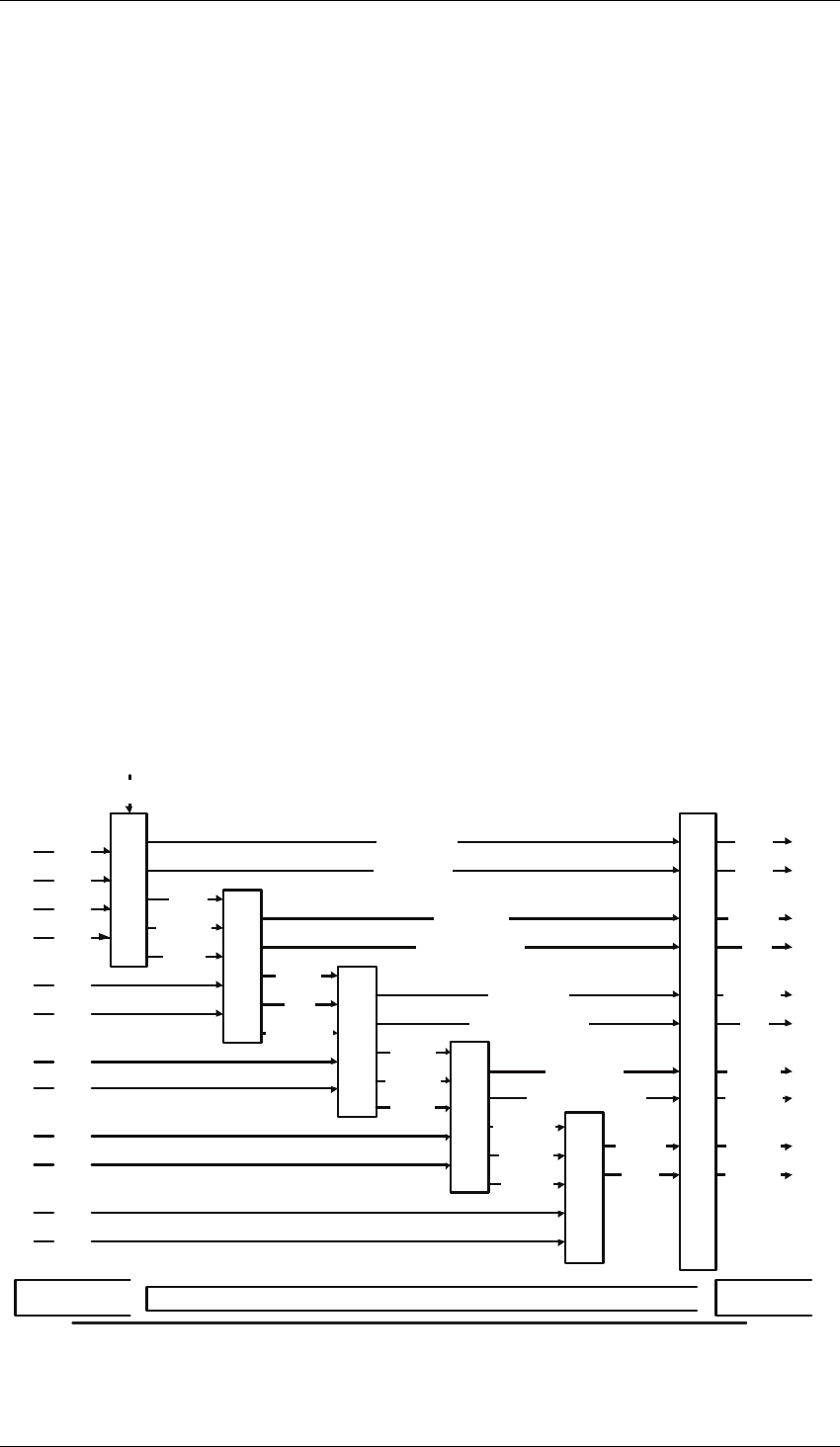

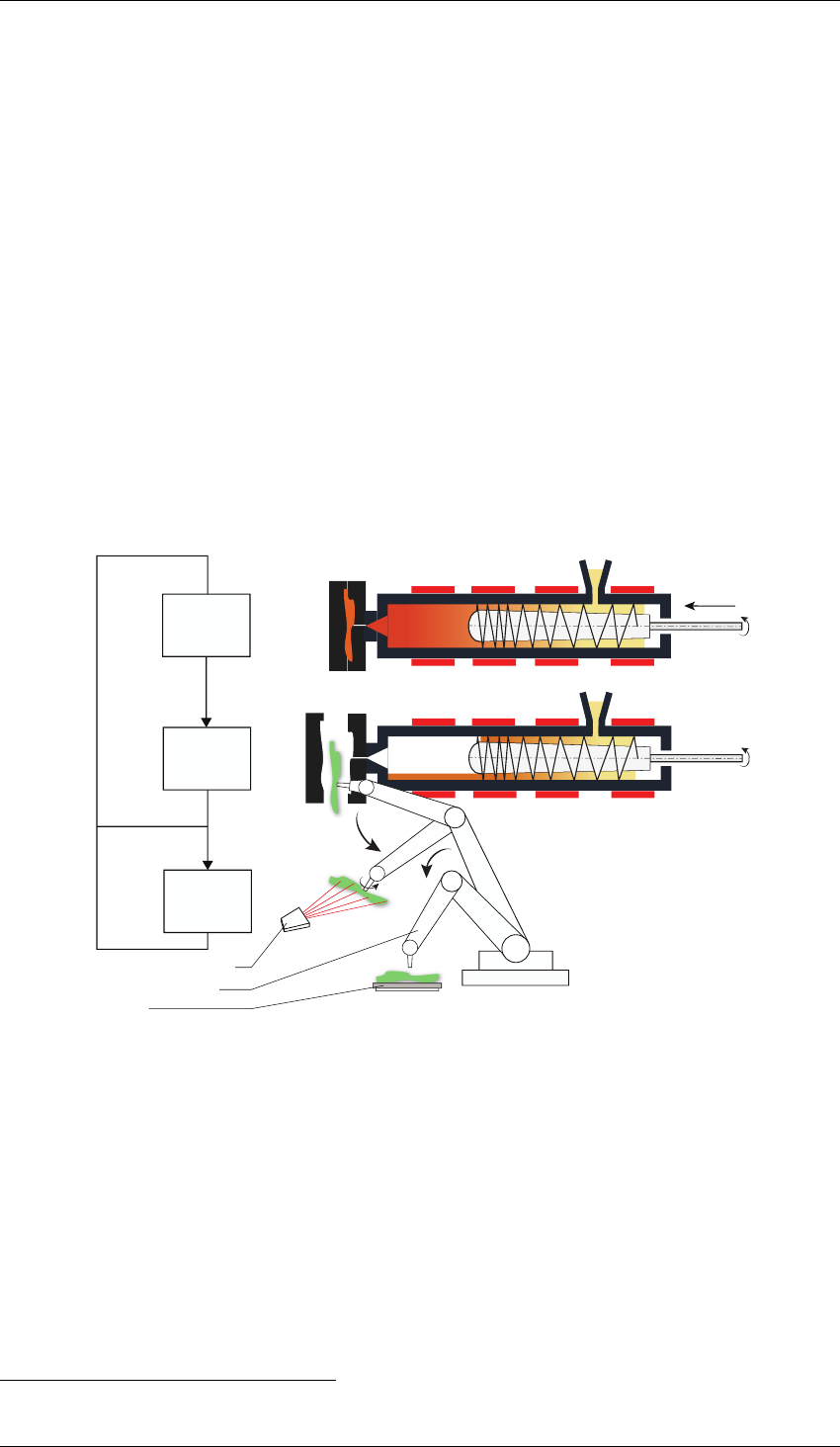

Le procédé d’injection-moulage des thermoplastiques est un procédé cyclique. Afin de mettre

en évidence la séquence d’un cycle du procédé, nous proposons un schéma bloc d’un cycle

d’injection en Figure 1.2. On remarque en particulier que l’étape de dosage est réalisé en parallèle

du refroidissement de la pièce et de son éjection. Le dosage est l’étape pendant laquelle la matière

première est fondue dans la vis d’injection. Lors du démarrage d’une presse à injecter, il est courant

de produire une vingtaine de pièce pour ajuster les réglages et stabiliser le cycle. Nous détaillons

dans la Section 1.1.1 suivante les paramètres qui peuvent être réglés sur une presse à injecter.

6

1.1. Le procédé d’injection-moulage des thermoplastiques

Course d’injection

Course de Maintien

Course dosage

Fermeture

outillage

Injection

Maintien

Pression de maintien

Refroidissement

Dosage

Ouverture

outillage

et sortie des

éjecteurs

Cycle d’injection

Vitesse d’avance

Figure 1.2 – Schéma-bloc du procédé d’injection-moulage.

7

Chapitre 1. Contexte industriel et problématique de recherche

Le procédé d’injection-moulage est également séquentiel : il est composé de phases

successives (voir Figure 1.2). Chaque phase possède des paramètres qui influent sur les phases

suivantes et, à terme, sur les caractéristiques du produit fini. Les multiples phases font que le

nombre de paramètres qui peuvent être ajustés sur le procédé est supérieur à vingt. Il est possible

d’ajuster précisément les températures, les courbes de pressions et les durées d’ouvertures et de

fermetures de multiples canaux d’injection. Enfin, le procédé d’injection-moulage possède une

certaine dynamique : c’est à dire que l’ajustement d’un des paramètres du procédé met une certaine

durée avant de se répercuter sur les produits. Cette dynamique est majoritairement due à l’inertie

thermique de l’outillage massif.

D’un point de vue industriel, l’injection-moulage des thermoplastiques est un procédé à haute

cadence, peu coûteux car répétable. Une fois la presse à injecter réglée, le procédé est généralement

stable dans le temps. Il peut produire de manière continue plusieurs milliers de pièces sans

intervention humaine. De plus, le coût de la matière première thermoplastique est faible.

La pratique industrielle de la production d’une pièce par moulage de thermoplastique suit les

étapes suivantes :

1. Apport de la matière première

2. Injection-moulage de la pièce

3. Stockage des pièces

4. Étapes de finition (traitements de surface, peintures)

5. Stockage des pièces

6. Contrôle de la qualité

7. Expédition

Le contrôle de la qualité des pièces n’est aujourd’hui pas réalisé dès la sortie du moule (après

l’étape 2.). Ainsi, si une pièce est non-conforme après l’étape d’injection-moulage, elle ne sera

pas écartée de la chaîne de production. Nous discuterons en particulier dans la Section 1.4 des

limites qui contraignent la réalisation du contrôle en ligne de production.

1.1.1 Paramètres réglables d’une presse à injecter

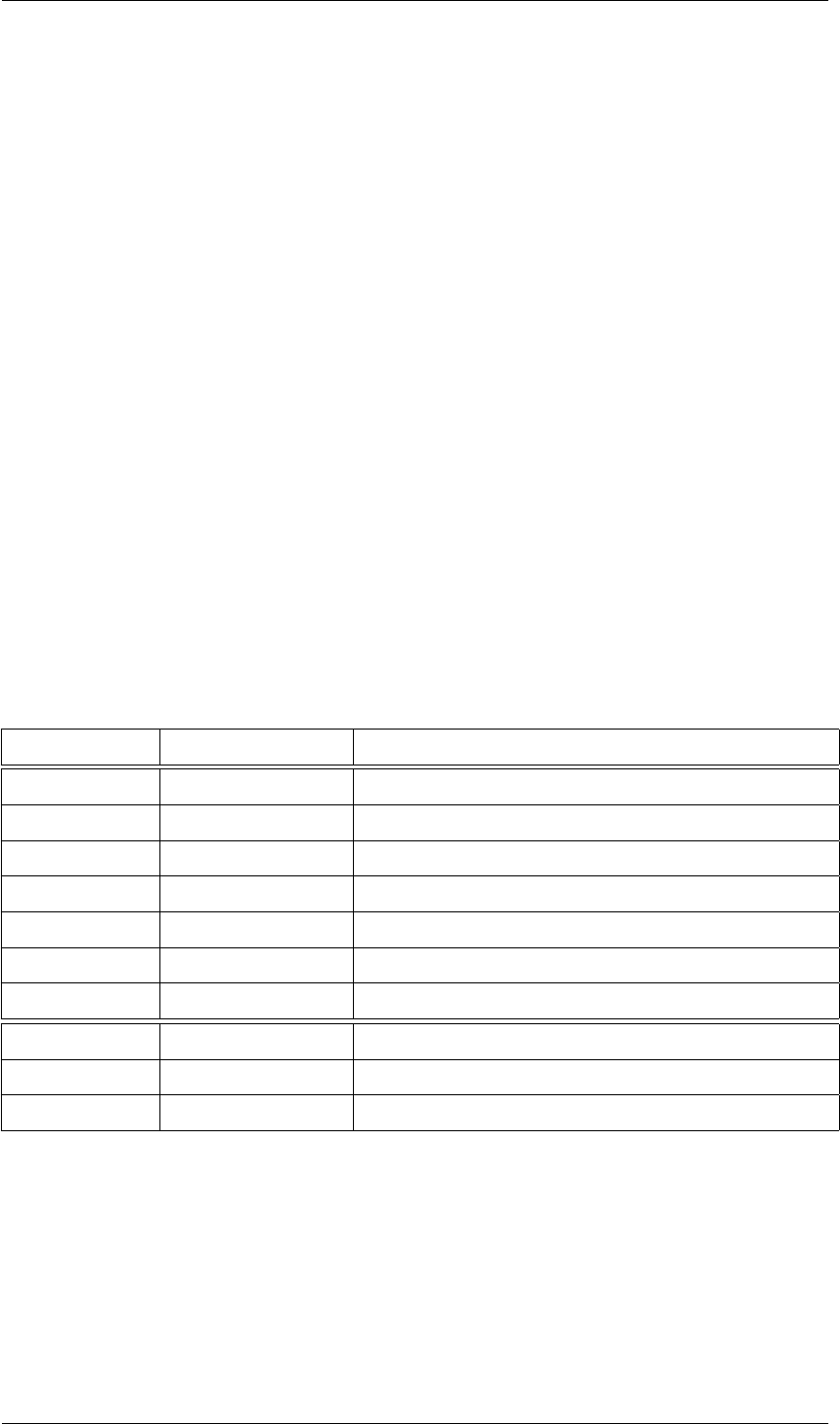

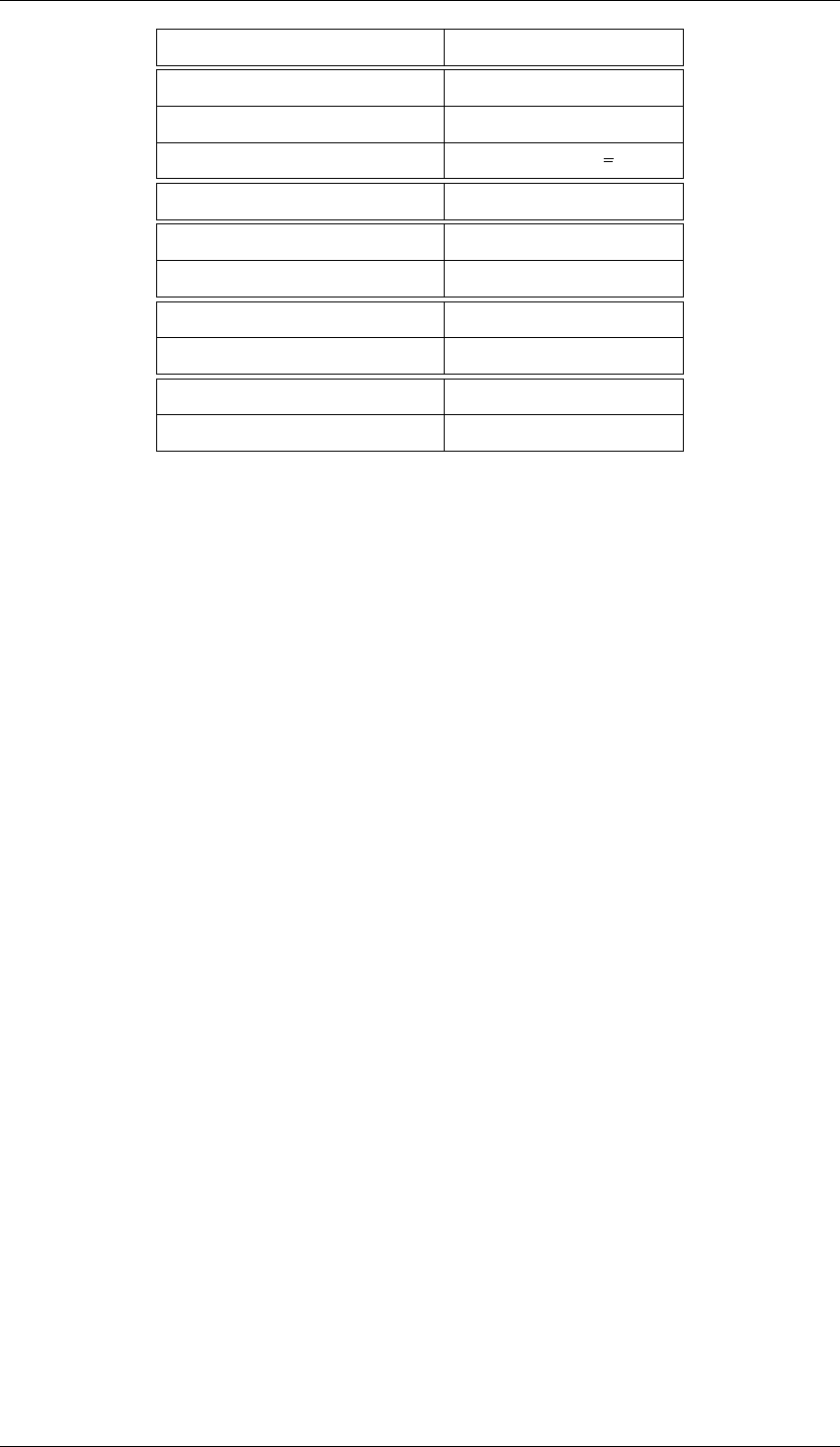

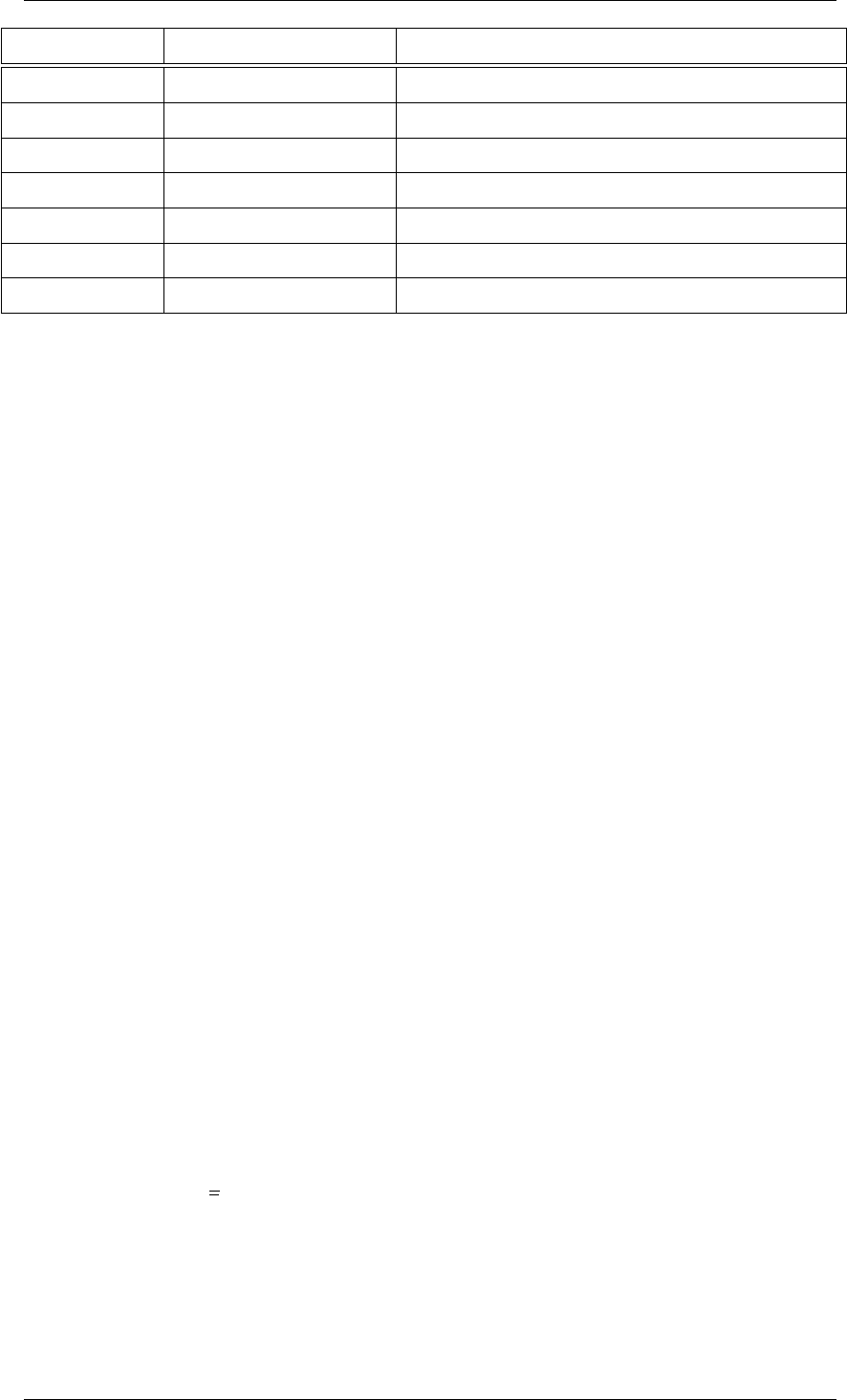

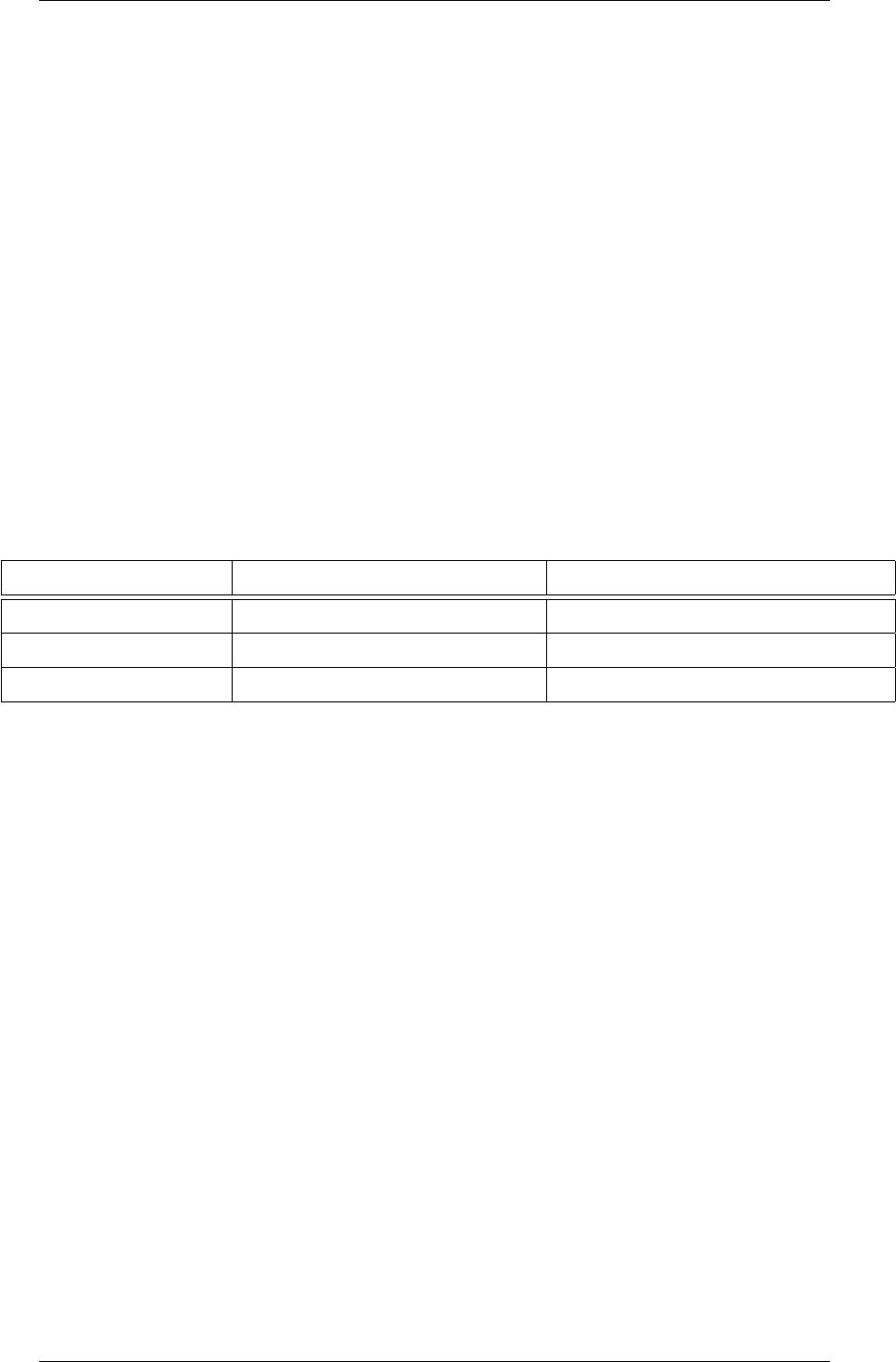

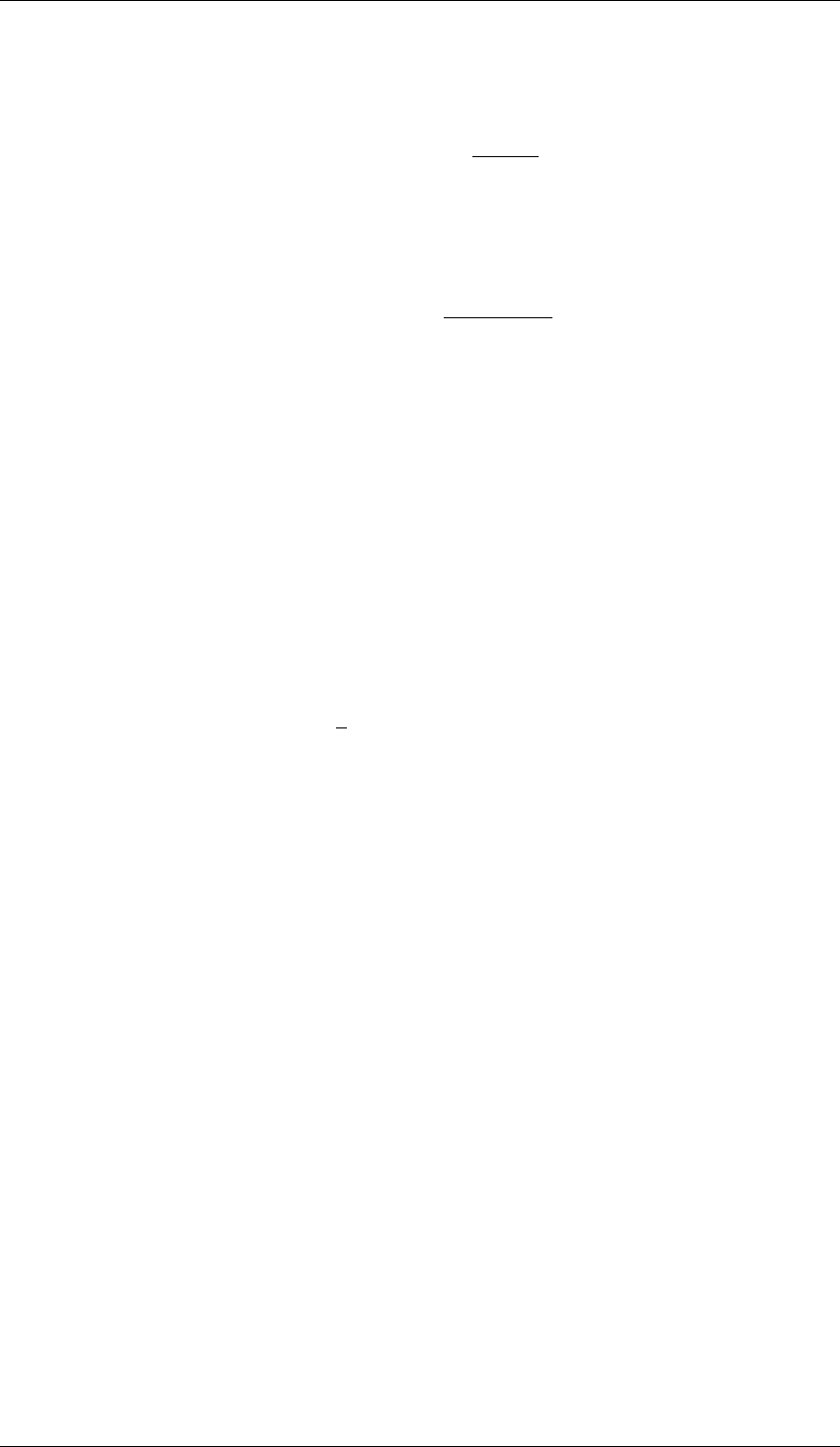

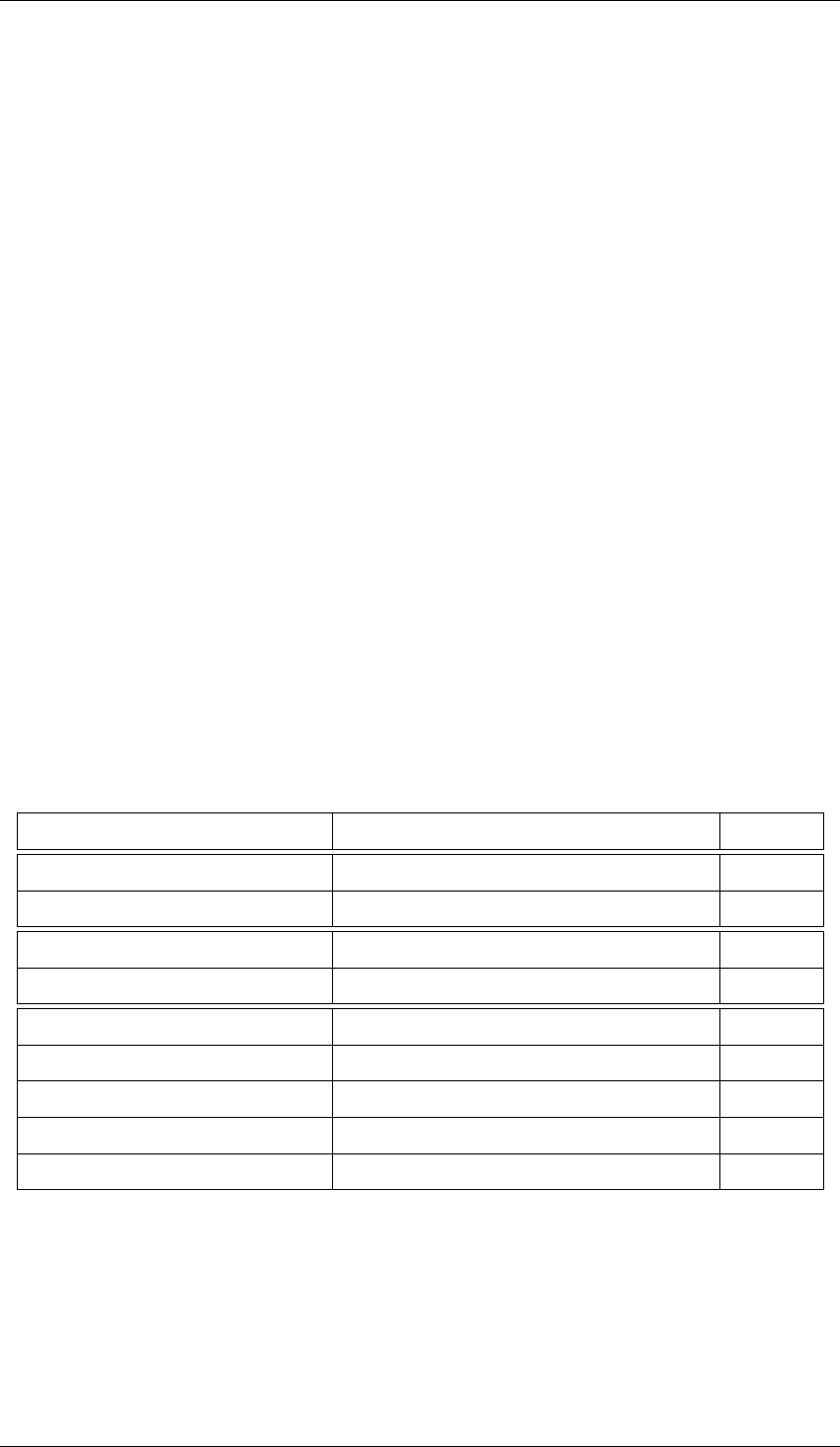

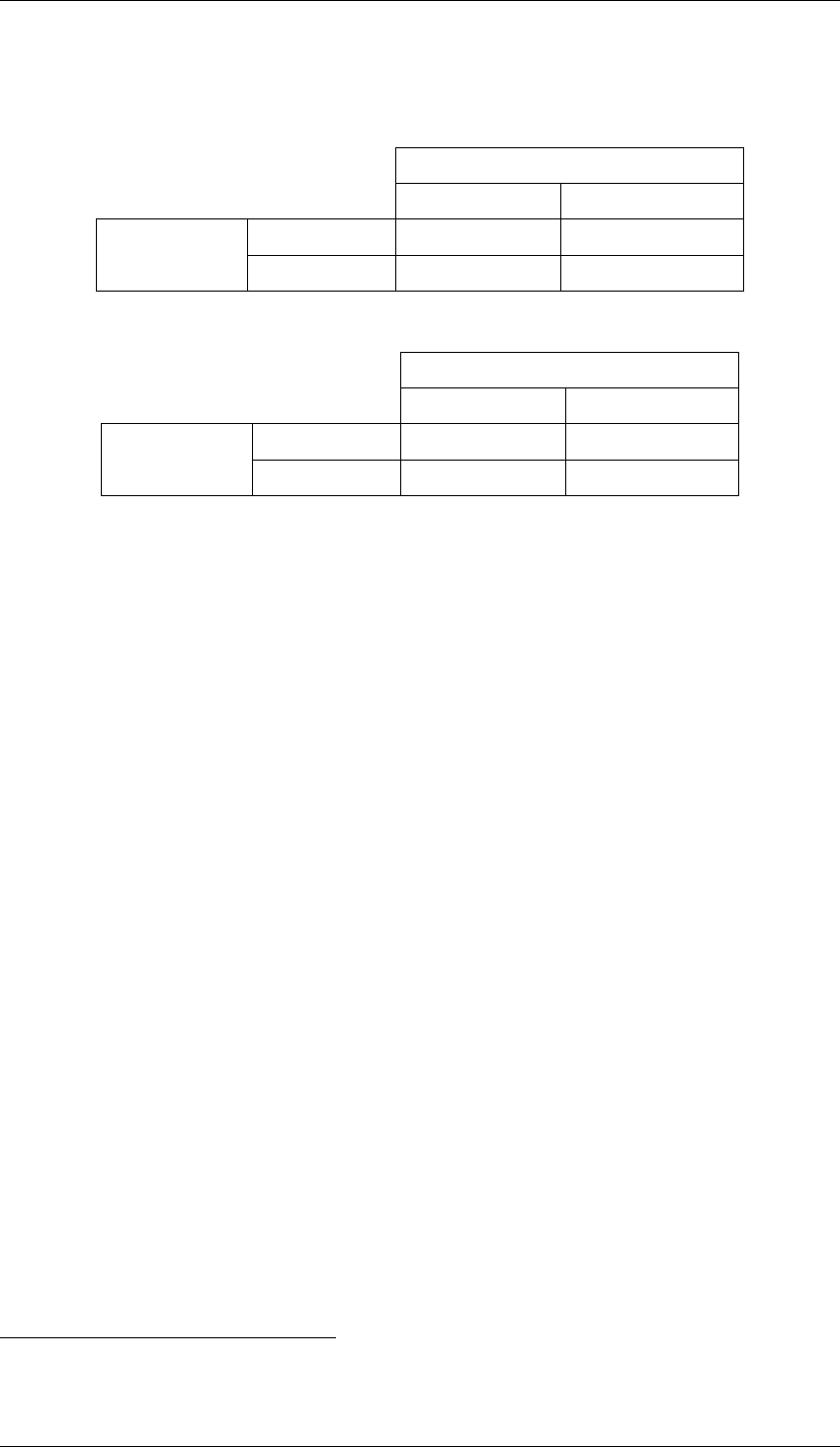

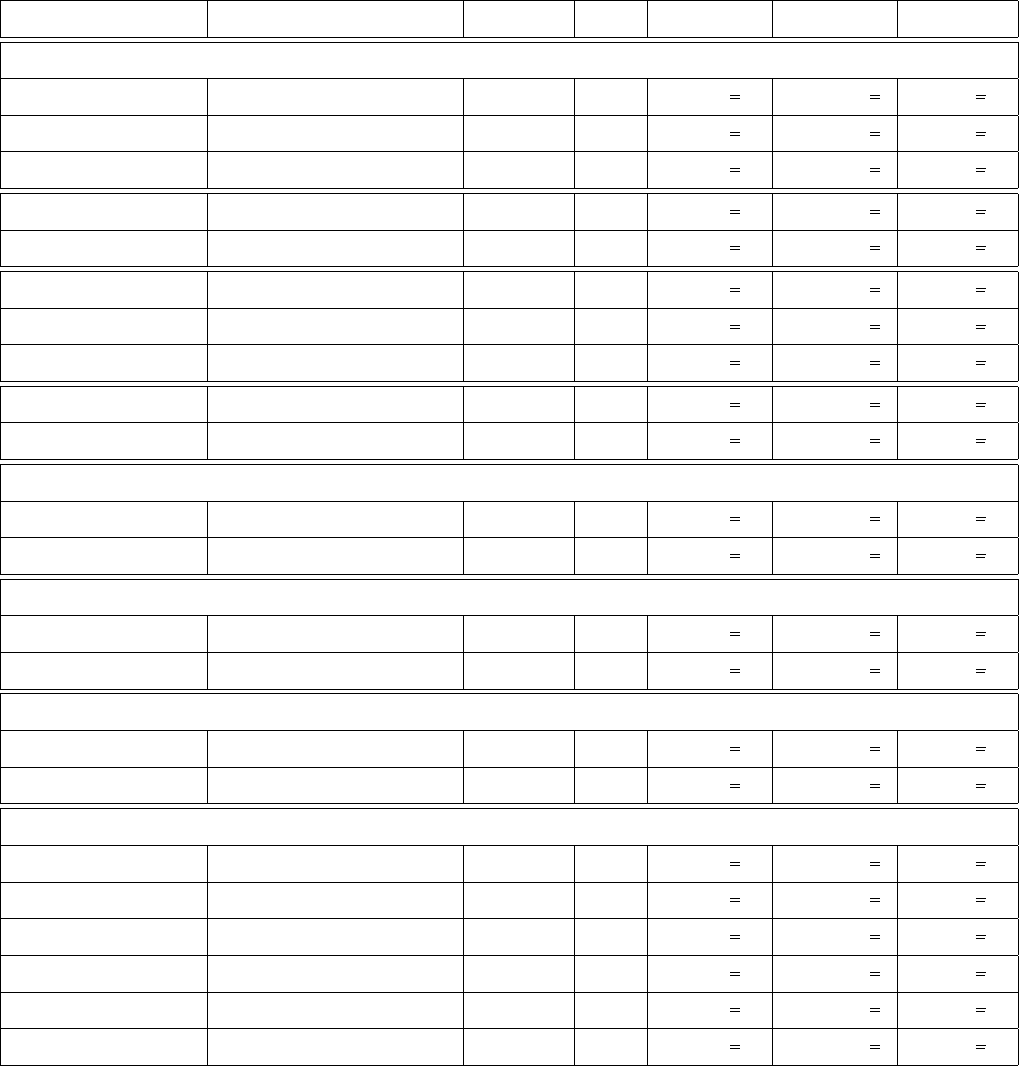

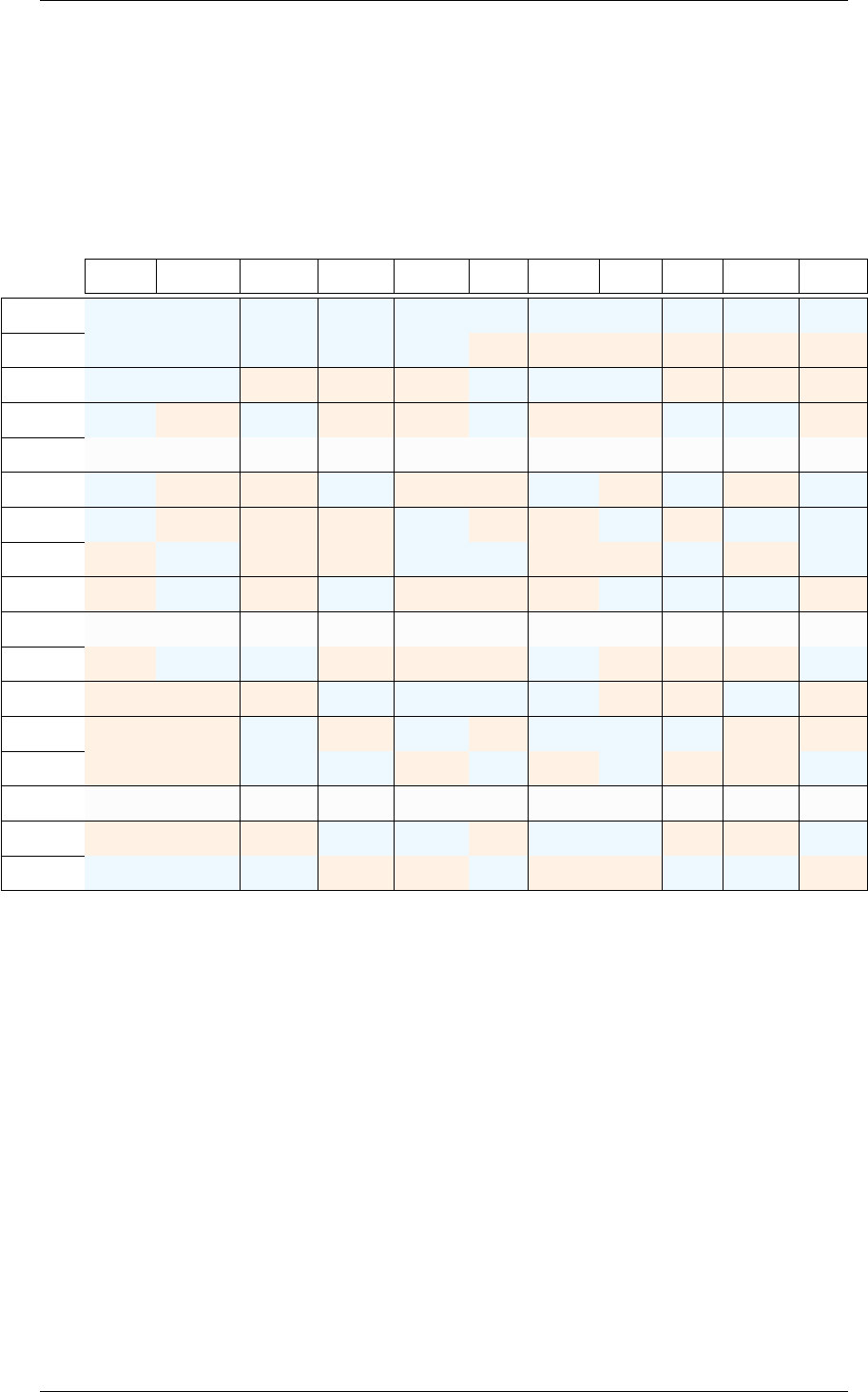

Le nombre de paramètres réglables d’une presse à injecter est grand. Dans le Tableau 1.1,

nous répertorions les 16 paramètres les plus courants qui peuvent être réglés sur un presse. Cette

liste n’est pas exhaustive. En particulier, les choix de la matière première, de la buse et les profils

d’évolution des pressions ajoutent de nombreuses possibilités de réglage. Nous remarquons que

de nombreux paramètres sont dépendants. Par exemple, la durée du cycle de production dépend de

la vitesse d’injection, qui dépend également de la pression d’injection que l’ont souhaite obtenir.

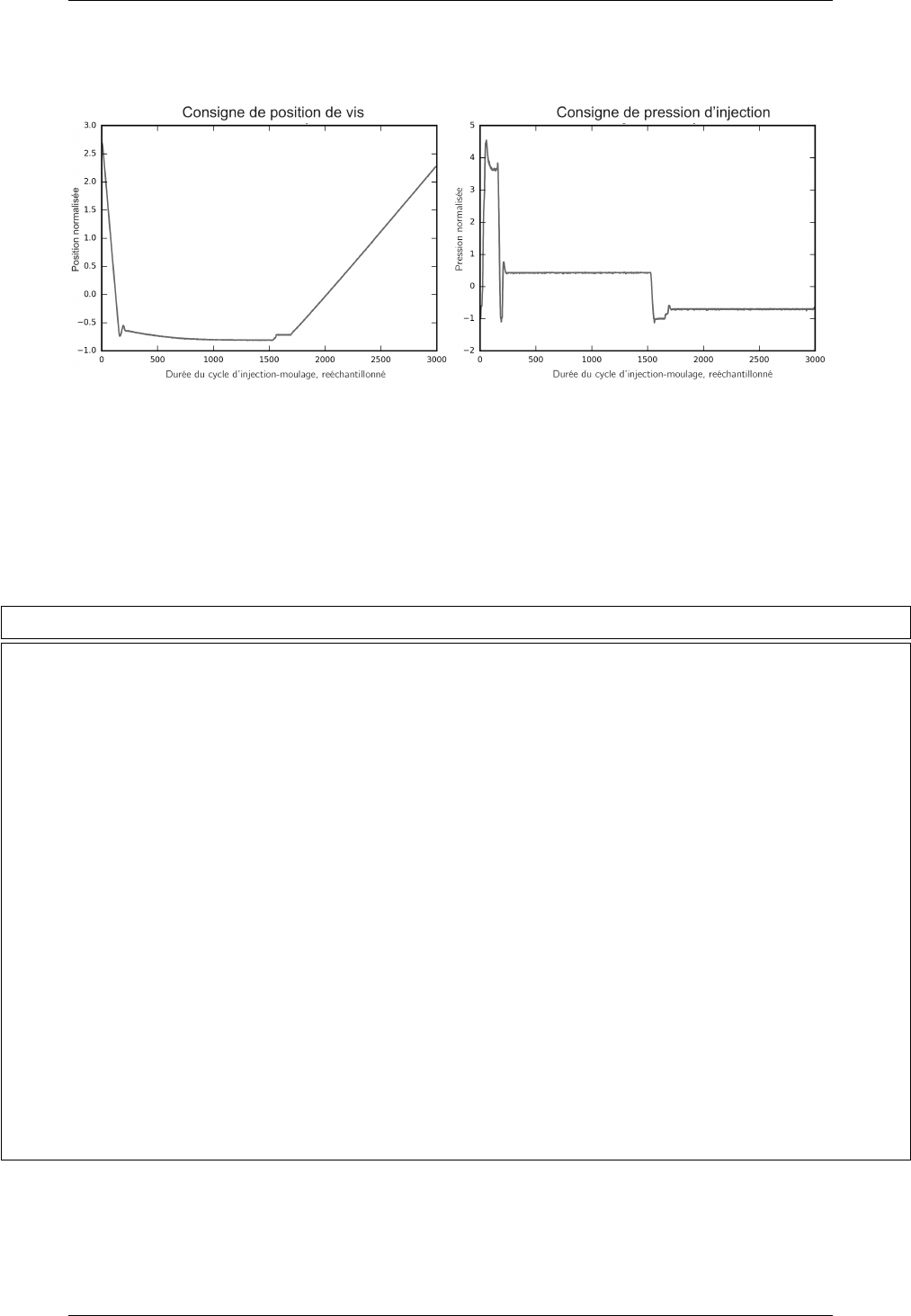

Des profils d’avance de la vis et de pression d’injection sont représentés dans la Figure 1.3.

On observe dans la première phase du cycke d’injection une avance rapide de la position de la

vis et une augmentation de la pression d’injection, afin de remplir l’empreinte de matière fondue.

Une seconde phase est le maintien de la pression dans l’empreinte pendant le refroidissement de

la matière. Puis le moule est ouvert et la vis est progressivement reculé à sa position initiale.

La pratique industrielle utilise le savoir-faire du technicien régleur. Le régleur a souvent accès

à la courbe de pression de l’injection. Sur des pièces compliquées, le réglage du procédé peut

prendre plusieurs heures.

8

1.1. Le procédé d’injection-moulage des thermoplastiques

Figure 1.3 – Profil de position de la vis et de pression d’injection pendant un cycle d’injection-

moulage.

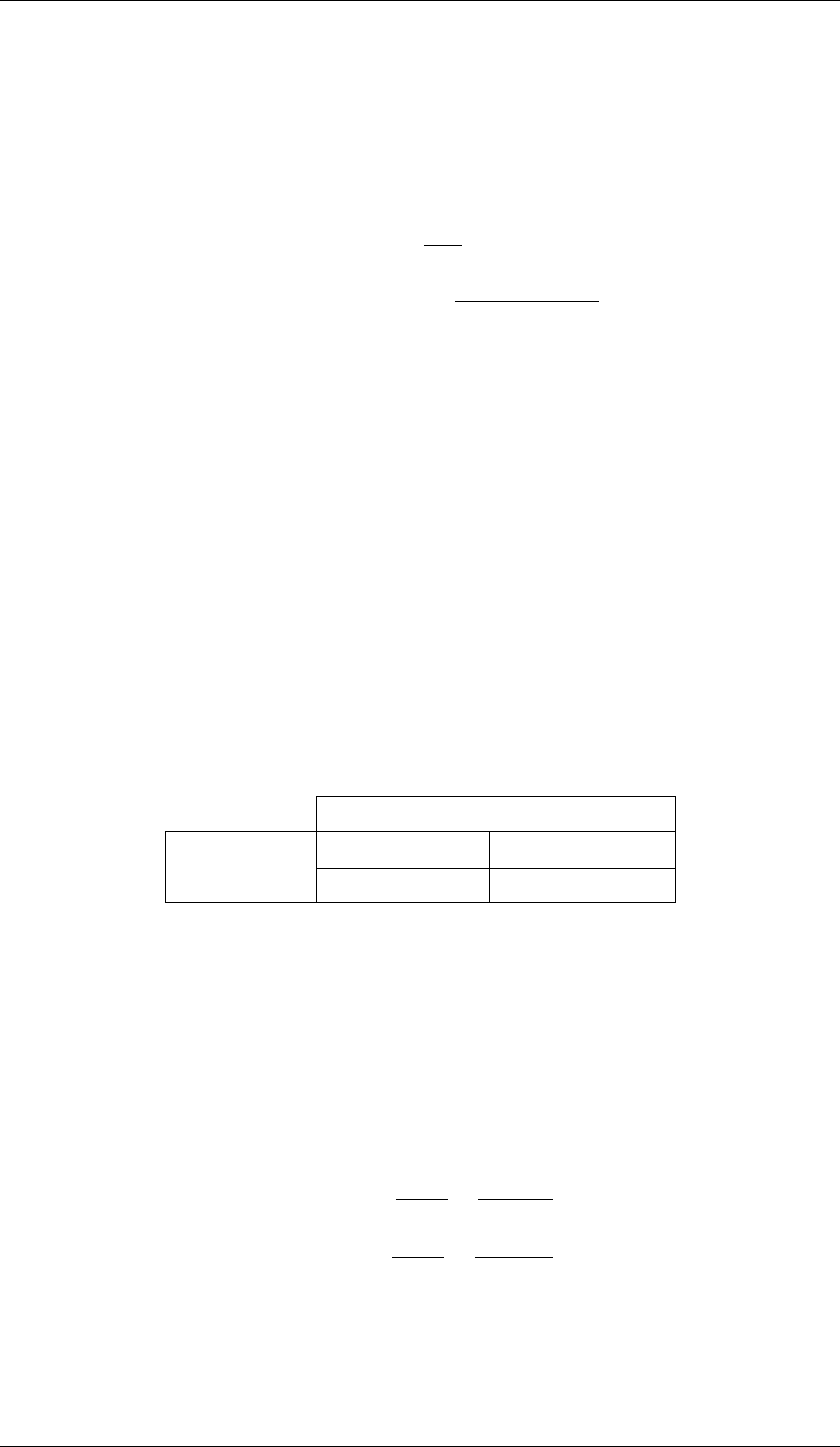

Phase du procédé Paramètres réglables Description Valeur classique

Dosage Course de dosage Distance de recul de la vis 50-100 cm

Dosage Température du fourreau Températures des colliers chauffants 200-300 °C

Dosage Vitesse de rotation de la vis Rotation de la vis qui malaxe la matière 1-20 tours/min

Injection Course d’injection Distance d’avance de la vis pendant l’injection 50-100 cm

Injection Pression d’injection Profil de pression exercée sur la vis et matière 10-200 MPa

Injection Pression de commutation Détermine le passage de l’injection au maintien 10-100 MPa

Injection Vitesse d’injection Vitesse d’avance de la vis 0,5 - 1 m/s

Maintien-refroid. Durée de maintien Durée de maintien de la pression 10-60 s

Maintien-refroid. Pression de maintien Profil de pression exercée sur la vis 10-100 MPa

Maintien-refroid. Débit thermorégulateur Débit de circulation du fluide 20-100 dm

3

/s

Maintien-refroid. Température thermorégulateur Régulation thermique du moule 10-40 °C

Ouverture-éjection Course d’ouverture Distance d’ouverture de l’outillage 10-100 cm

Ouverture-éjection Vitesse d’ouverture Vitesse d’ouverture de l’outillage 0,5 - 2 m/s

Ouverture-éjection Course des éjecteurs Distance de sortie des éjecteurs 1-20 cm

Ouverture-éjection Vitesse de rentrée des éjecteurs Vitesse de sortie des éjecteurs 0,5 - 2 m/s

Fermeture outillage Vitesse de fermeture Vitesse de fermeture de l’outillage 0,5 - 2 m/s

Tableau 1.1 – Paramètres réglables sur une presse à injecter classique.

9

Chapitre 1. Contexte industriel et problématique de recherche

1.2 La qualité d’un produit en injection-moulage des

thermoplastiques

La norme ISO9000 [ISO15] spécifie la notion de qualité comme l’aptitude d’un ensemble de

caractéristiques intrinsèques d’un objet à satisfaire des exigences. Dans notre cadre des produits

industriels, les exigences sont celles du client final ou du donneur d’ordre. Elles sont spécifiées

dans la documentation technique du produit, dont le dessin. Des caractéristiques sont mesurées sur

le produit. Puis les résultats sont comparées aux exigences, c’est à dire des limites d’acceptation

ou des intervalles de tolérances. Nous distinguons cinq grands types de caractéristique :

— géométriques

— mécaniques,

— sensoriels : visuelles, haptiques, olfactives,

— chimiques,

— économiques.

Dans le cadre de ce travail, nous nous intéressons en particulier aux caractéristiques

géométriques et d’aspect. La maîtrise de ces deux types de caractéristique est un enjeu important

pour le secteur de la plasturgie. Les tolérances dimensionnelles sont de plus en plus serrées.

À celles-ci s’ajoutent l’exigence de peu de non-conformité de l’aspect des pièces. Enfin,

l’amélioration de la qualité est un facteur important de rentabilité et de compétitivité des

entreprises. Dès 1950, DEMING [Dem82] décrit la réaction en chaîne que permet d’initier

l’amélioration de la qualité : réduction des coûts des rebuts, diminution du prix de revient, gain de

marchés et, à terme, création d’emplois.

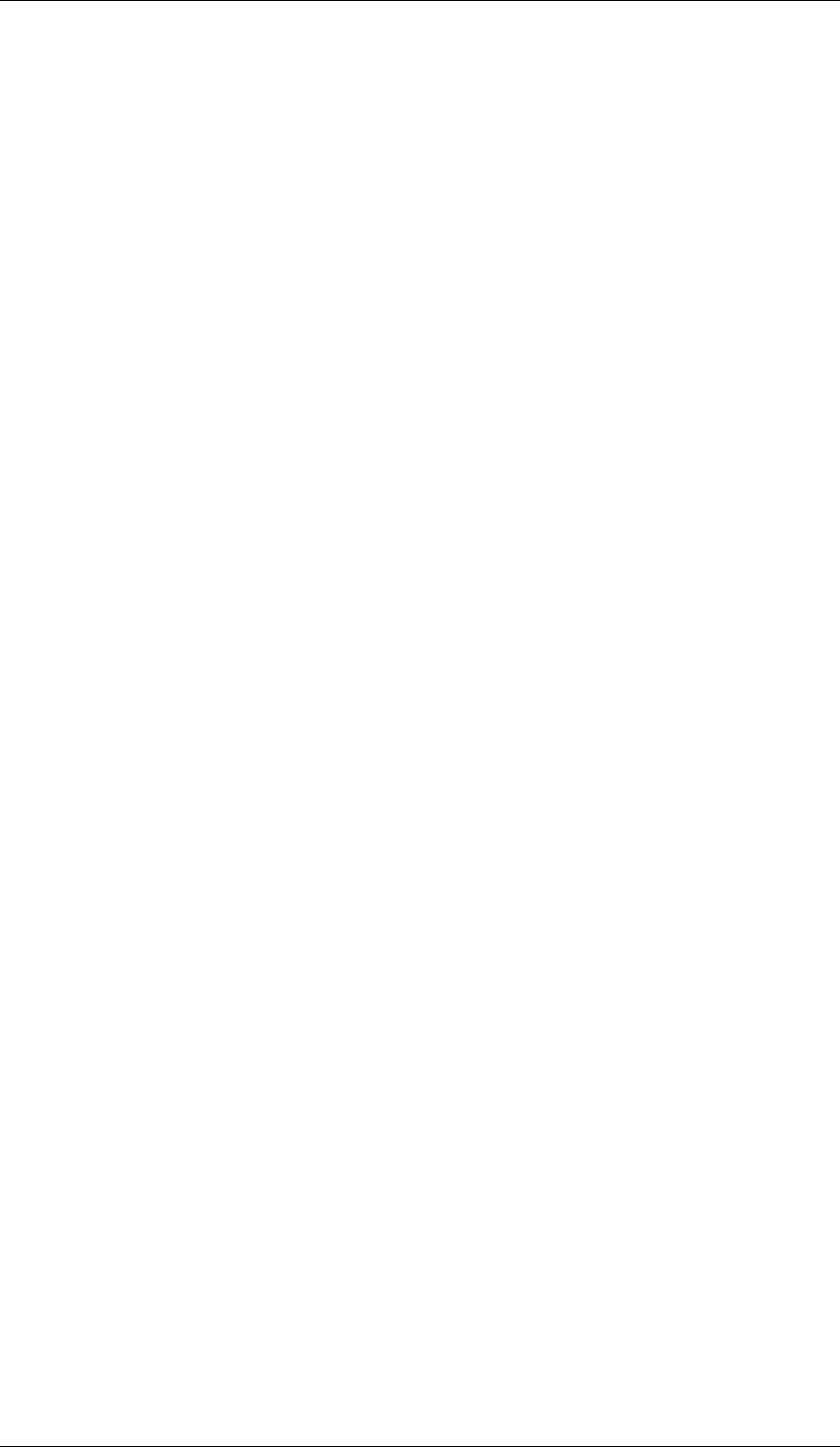

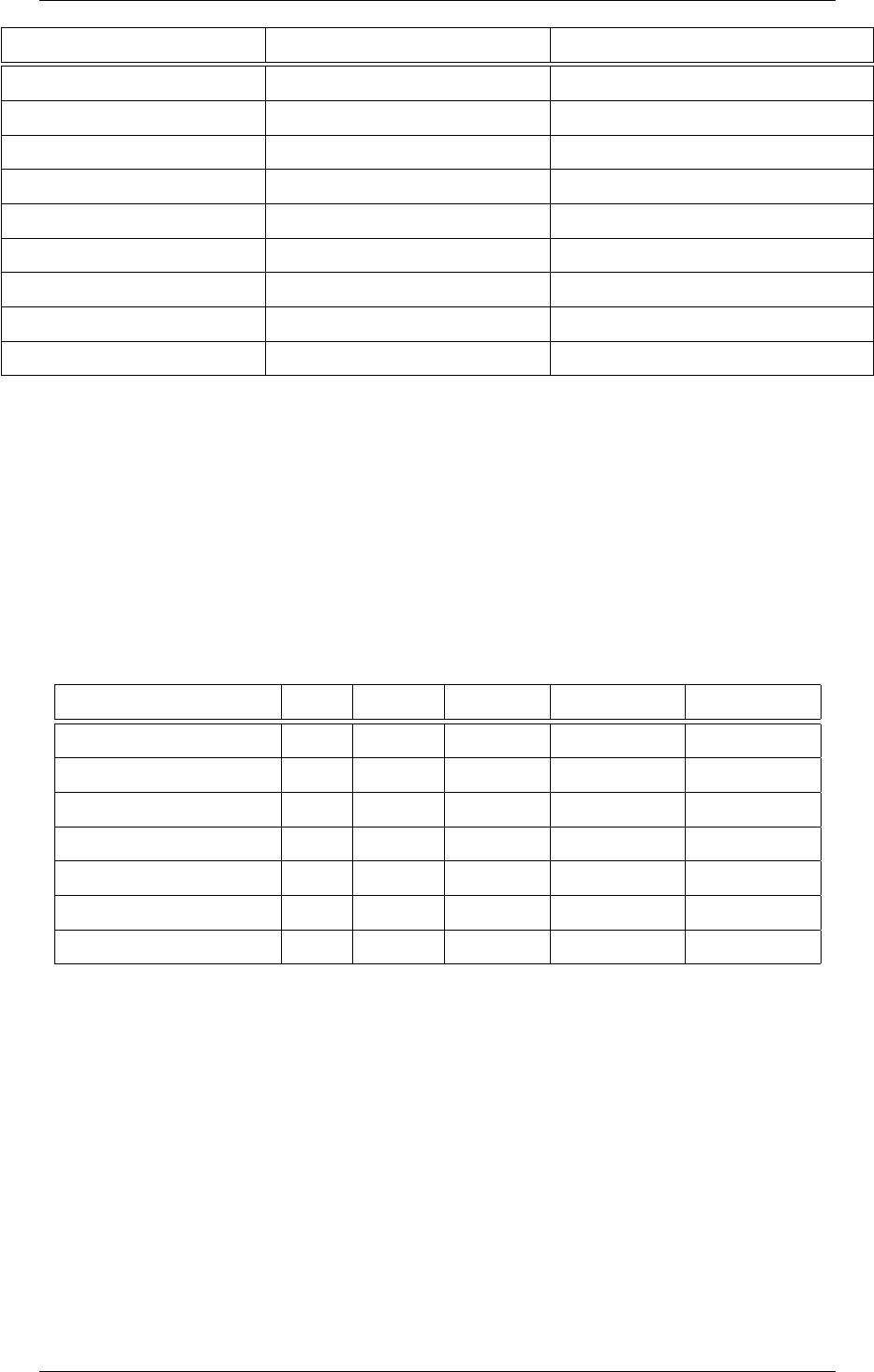

Le Tableau 1.2 présente les non-conformités d’aspect habituelles en injection-moulage des

thermoplastiques.

Non-conformité Description Causes probables

Homothétie dimension modifiée retrait de la matière

Gauchissement défaut de surface refroidissement non homogène

Retassure cavité dans la matière pression de maintien, vitesse d’injection

Incomplet trou dans la pièce quantité de matière injectée, clapet anti-retour défaillant

Ligne de soudure ligne décolorée pression d’injection, température matière

Jet libre trace décolorée viscosité matière, conception moule, pression d’injection

Éjection trace de l’éjecteur vitesse éjecteur, température matière, durée refroidissement

Combustion trace noire conception du moule, température de la matière

Givrage bulle ou trace blanche matière humide

Pollution trace colorée usure de l’outillage, pollution de la matière

Tableau 1.2 – Principaux défauts d’aspects en injection-moulage des thermoplastiques.

Un défaut de ligne de soudure entraine une fragilité. La majorité des non-conformités d’aspect

sont des défauts géométriques de surface. Seules la combustion, le givrage et la pollution sont

entrainées pas la modification des propriétés du polymère. Ces imperfections géométriques sont

souvent dues au mauvais maintien du polymère contre les parois de l’outillage, ou bien à la

solidification trop rapide de la matière. Les défauts d’incomplets sont les plus simples à détecter

par analyse d’image : un seuillage puis une détection de contours est suffisant. La détection des

autres non-conformité est plus compliquée. C’est notre objectif principal de recherche.

10

1.2. La qualité d’un produit en injection-moulage des thermoplastiques

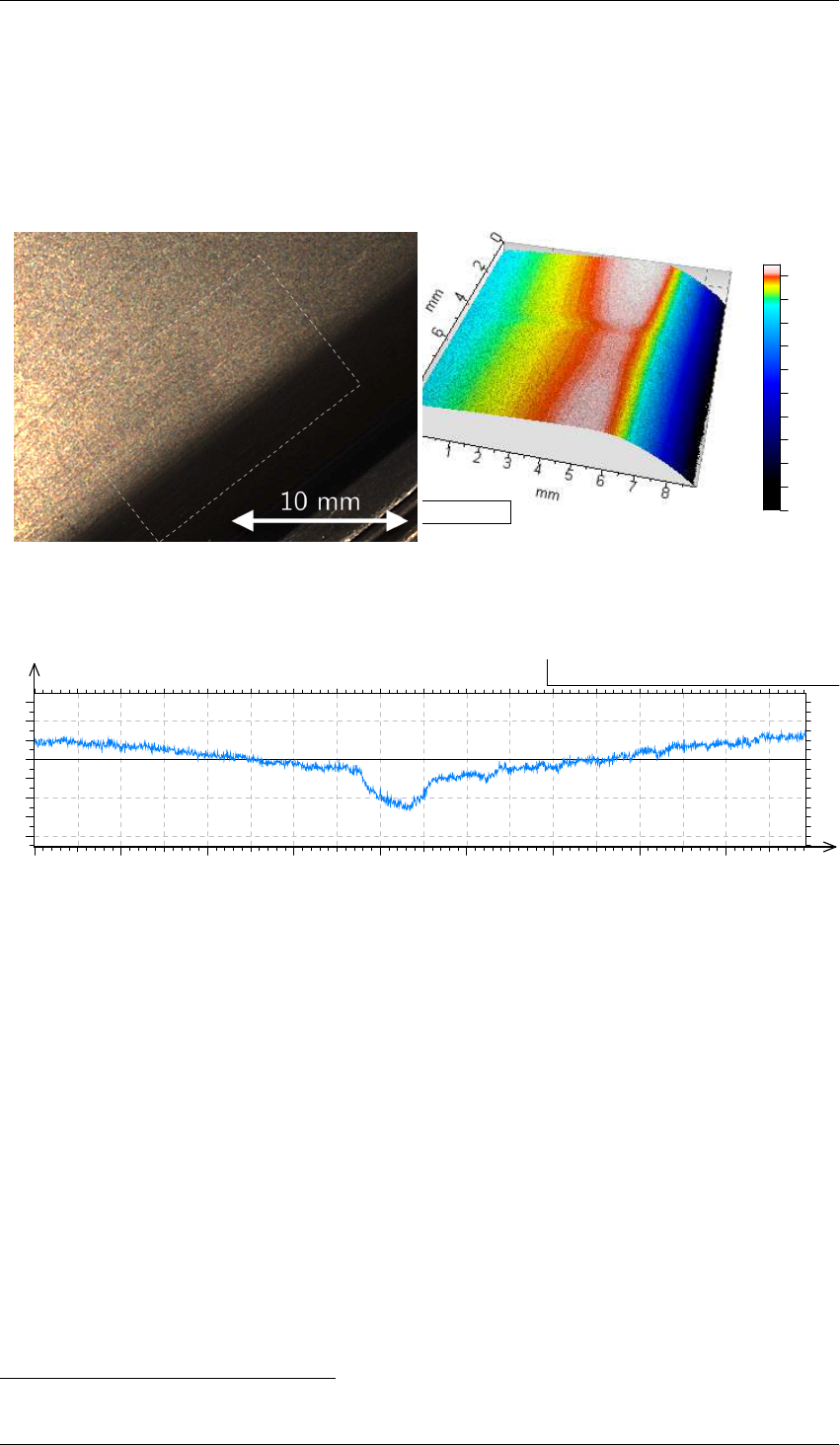

La Figure 1.4 présente une mesure par microscopie confocale d’un défaut de retassure

sur une pièce plastique automobile de deux mètres. Ce défaut est caractéristique des pièces

automobiles qui sont peintes afin de réfléchir la lumière de manière harmonieuse. La légère

inflexion de la surface entraine une "cassure" de la réflexion de la lumière, ce qui attire le regard

et amplifie l’impression de défaut. L’écart géométrique de l’inflexion est de l’ordre de la dizaine

de micromètres.

(a) Photographie du défaut.

AltiMap Premium 6.2.7487

0 2 4 6 8 mm

mm

0

1

2

3

4

5

6

7

8

mm

0

0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

1

NM

mm

0

0.2

0.4

0.6

0.8

1

0 2 4 6 mm

mm

0

1

µm

0

50

100

150

200

µm

0

Aire horizontale 3.05 mm²

Aire développée 3.14 mm²

Complexité 3.06 %

Profondeur 11.5 µm

Volume 0.0125 mm³

Périmètre 8.06 mm

0 2 4 6 mm

mm

0

1

µm

0

40

80

120

160

0 2 4 6 mm

mm

0

1

µm

0

2

4

6

8

10

Longueur = 1.52 mm Pt = 10.4 µm Echelle = 20.0 µm

0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 1.1 1.2 1.3 1.4 1.5 mm

µm

-10

-5

0

5

Longueur = 8.93 mm Pt = 21.2 µm Echelle = 40.0 µm

0 0.5 1 1.5 2 2.5 3 3.5 4 4.5 5 5.5 6 6.5 7 7.5 8 8.5 mm

µm

-20

-10

0

10

Vue e n 3D

Mesure d'une ride

Profil sans filtrage ondul/rugo

Ondulation (filtrage gaussien cut-off 0.25mm)

Rugosité (filtrage gaussien cut-off 0.25mm)

Carte de profondeurs (mesures brutes)

Recadrage (échelle de couleur optimisée)

Laboratoire SYMME - Projet SAPRISTI - 16/11/17 - Mesure géométrique AltiSurf AVEC défaut

(b) Mesure de surface par microscopie confocal.

AltiMap Premium 6.2.7487

0 2 4 6 8 mm

mm

0

1

2

3

4

5

6

7

8

mm

0

0.1

0.2

0.3

0.4

0.5

0.6

0.7

0.8

0.9

1

NM

mm

0

0.2

0.4

0.6

0.8

1

0 2 4 6 mm

mm

0

1

µm

0

50

100

150

200

µm

0

Aire horizontale 3.05 mm²

Aire développée 3.14 mm²

Complexité 3.06 %

Profondeur 11.5 µm

Volume 0.0125 mm³

Périmètre 8.06 mm

0 2 4 6 mm

mm

0

1

µm

0

40

80

120

160

0 2 4 6 mm

mm

0

1

µm

0

2

4

6

8

10

Longueur = 1.52 mm Pt = 10.4 µm Echelle = 20.0 µm

0 0.1 0.2 0.3 0.4 0.5 0.6 0.7 0.8 0.9 1 1.1 1.2 1.3 1.4 1.5 mm

µm

-10

-5

0

5

Longueur = 8.93 mm Pt = 21.2 µm Echelle = 40.0 µm

0 0.5 1 1.5 2 2.5 3 3.5 4 4.5 5 5.5 6 6.5 7 7.5 8 8.5 mm

µm

-20

-10

0

10

Vue en 3D

Mesure d'une ride

Profil sans filtrage ondul/rugo

Ondulation (filtrage gaussien cut-off 0.25mm)

Rugosité (filtrage gaussien cut-off 0.25mm)

Carte de profondeurs (mesures brutes)

Recadrage (échelle de couleur optimisée)

Laboratoire SYMME - Projet SAPRISTI - 16/11/17 - Mesure géométrique AltiSurf AVEC défaut

(c) Profil du défaut.

Figure 1.4 – Défaut de retassure mesurée par microscope confocal, AltiMet 520

0

.

La mesure de la géométrie à l’échelle micrométrique, pendant la durée du cycle du procédé, est

un véritable défi. Dans la suite de ce chapitre, nous présenterons les moyens de mesure existants;

puis nous orienterons notre étude sur les moyens de mesure sans contact; en particulier nous nous

intéresserons aux moyens de mesure compatibles avec le temps de cycle du procédé d’injection-

moulage.

0. Spécifications techniques de l’Altisurf 520 sur le site Internet de la société Altimet.

11

Chapitre 1. Contexte industriel et problématique de recherche

1.3 Revue de la recherche académique sur le procédé d’injection-

moulage

Le procédé d’injection est l’étape clé du processus de fabrication des pièces plastiques

moulées. Il répercute ses défauts sur l’aval de la chaîne de production, comme par exemple sur

les étapes d’assemblages et de finitions.

Dans cette section, nous identifierons trois axes de recherche principaux qui lui ont été

dévoués : la modélisation physique du procédé; la maîtrise du point de fonctionnement; et

l’optimisation des réglages. Nous réaliserons une cartographie bibliographique §1.3.1, puis nous

nous intéresserons aux travaux de modélisation du procédé d’injection-moulage §1.3.2. Enfin,

nous étudierons la recherche sur la maîtrise du procédé d’injection-moulage §1.3.3.

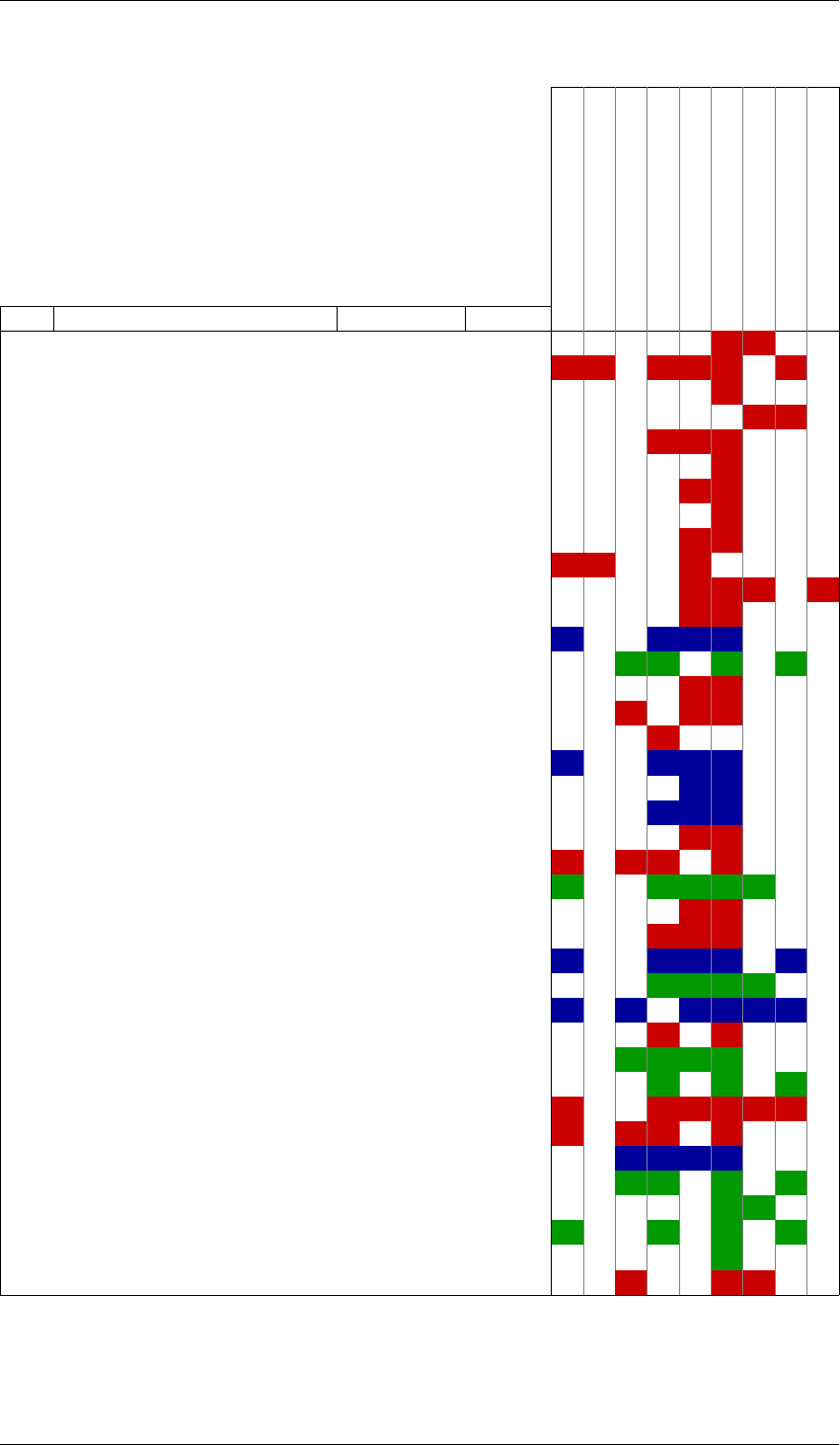

1.3.1 Cartographie bibliographique

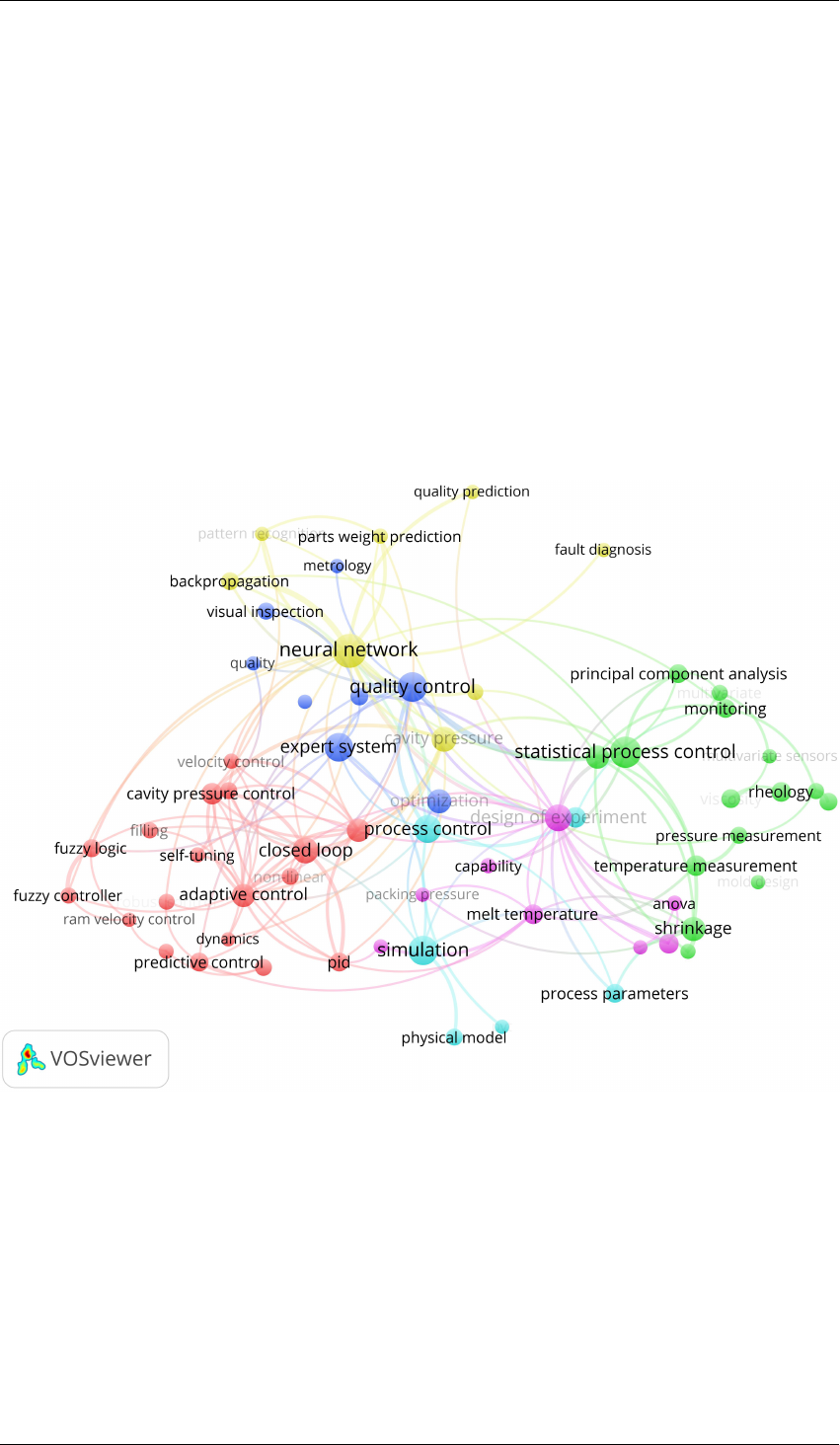

Afin d’identifier les thématiques de recherche qui sont associées au procédé d’injection-

moulage, nous avons réalisé une cartographie bibliographique dans la Figure 1.5.

Figure 1.5 – Cartographie bibliographique de la maîtrise du procédé d’injection-moulage.

Elle présente le graphe relationnel que nous avons construit à partir des mots-clés associés à

421 publications, de 1970 à 2015. Les mots-clés sont retenus s’ils apparaissent plus de quatre fois.

Ils sont regroupés par relations. Nous utilisons le formalisme VOS (Visualization Of Similarities)

proposé par VAN ECK et WALTMAN [vW06; van+10]. Sur ce graphique, nous identifions plusieurs

thématiques de recherche. Dans la suite de cette section, nous présenterons chacune d’elles.

— la modélisation mathématique et la simulation du procédé (couleur cyan) §1.3.2.2,

— la modélisation empirique par plan d’expériences (couleur magenta) §1.3.2.3,

— l’apport des systèmes à réseaux des neurones pour modéliser le procédé (en jaune) §1.3.2.3,

12

1.3. Revue de la recherche académique sur le procédé d’injection-moulage

— l’apport des systèmes experts pour régler le point de fonctionnement initial (en bleu) §1.3.3,

— la régulation du point de fonctionnement par l’automatique (couleur rouge, Engineering

Process Control) §1.3.3,

— l’analyse statistique afin de détecter les dérives (en vert, Statistical Process Control) §1.3.3.

L’ensemble de ces travaux de recherche a deux grands objectifs :

— améliorer la modélisation du procédé pour pouvoir optimiser ses paramètres,

— maîtriser les caractéristiques des produits fabriqués.

Ces deux objectifs sont souvent traités de manière complémentaire. Dans les sections suivantes,

nous présenterons chacune de ces thématiques de recherche.

1.3.2 Modélisation du procédé d’injection-moulage

Chacune des phases du procédé d’injection-moulage influe sur la suivante et, à terme,

conditionne les caractéristiques du produit. Nous étudierons les travaux de la littérature sur

la modélisation systémique du procédé, puis nous proposerons une nouvelle représentation

systémique. Nous présenterons ensuite les travaux sur les modèles théoriques du procédé

d’injection-moulage et les travaux d’identification de modèles à partir de résultats de mesure

expérimentaux.

1.3.2.1 Modélisation systémique

En 1999, KAZMER et HATCH proposent un découpage en cinq phases [KH99] (voir la Figure

1.6) qui est une évolution du découpage en trois phases qui avait été proposé par MA [Ma74].

Cette représentation systémique du procédé fait apparaître des variables d’état intermédiaires qui

sont associées à chacune des phases.

Température

Fourreau

1000

PLASTICATION

INJECTION

MAINTIEN

REFROIDISSEMENT

EJECTION

QUALITE PRODUIT/PROCEDE

Pression

du Fondu

Granulés

Thermoplastique

Pression Vis

0.02

RPM de la vis

0 . 5

Déformation

Dimensions

Clarté

Coût

économique

Contraintes

résiduelles

Intégrité

Pièce

ejectée

Relaxation

Solidification de couches

Résistance

Aspect

Durée de séjour

dans le moule

Volume

du Fondu

Température

du Fondu

Qualité du Fondu

Profil de Vitesse d’Injection

0.02

Pression d’Injection Maximal

0 . 1

Profil de Pression de Maintien

0 . 2

Durée de Maintien

0.01

Viscosité

du Fondu

Pression dans

la Buse

Débit

Temperature du liquide de refroidissement du moule

200

Durée de Refroidissement

0.01

Vitesse du Front

de Fondu

Pression

du Fondu

Densité

du Fondu

Température

du Fondu

Solidification de couches

Tonnage de bride

Solidification de couches

Temps de cycle

Température

de la Pièce

Contraintes

Internes

Effort dans

la Pièce

Course d’Ejection

0.02

Vitesse d’Ejection

0.01

Défaut

de Jet

Défaillance

du Moule

Quantité injectée

0.02

REGLAGES

MACHINES

CARACTERISTIQUES

QUALITE

VARIABLES D’ETAT

Figure 1.6 – Vue systémique du procédé d’injection-moulage, traduite de KAZMER et HATCH

[KH99].

13

Chapitre 1. Contexte industriel et problématique de recherche

Elle fait également apparaître les relations de dépendance entre les différentes phases. La

représentation met en évidence plusieurs variables intermédiaires, qui influent soit directement

sur les caractéristiques du produit, soit sur les caractéristiques d’autres phases. Ces variables

intermédiaires ne sont pas nécessairement observables. Il est par exemple très difficile de mesurer

la densité de la matière fondue, ou encore l’évolution des contraintes internes.

Cette figure permet de mettre en évidence dix caractéristiques du produit qui sont la cause de

12 variables de réglage. L’injection-moulage est un procédé multi-entrées, multi-sorties (MIMO).

On distingue également deux réglages de "profils". Un profil est une valeur de réglage qui évolue

dans le temps. Aussi, les possibilités de réglages d’un profil sont bien plus importantes que pour

une grandeur scalaire. Dans le cas où un profil serait représenté par 10 points; nous obtenons alors

20 variables de réglage pour deux profils.

Enfin, nous remarquons que cette représentation systémique ne fait pas apparaître la nature

cyclique du procédé. En effet, la phase de dosage est réalisée en temps masqué au cycle principal

de fabrication d’une pièce.

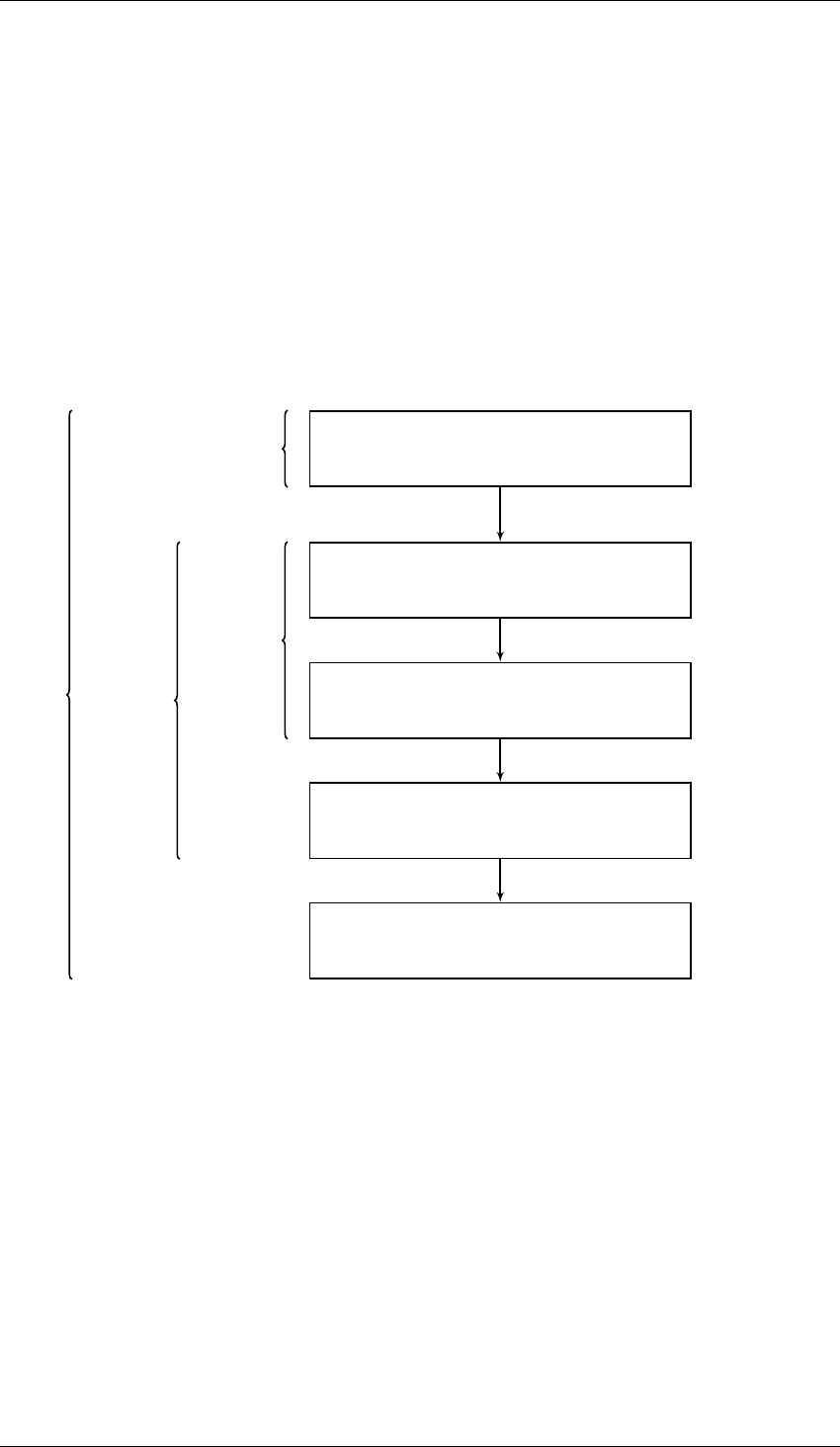

{PVs}

Caractéristiques

Paramètres

{DP}

Dosage

Injection

Refroidissement

Caractéristiques

matière

Caractéristiques

Pièce en

sortie machine

Caractéristiques

Pièce injectée

Conditions de

maintien et

refroidissement

Variables

d’injection

Caractéristiques

fondu

Variables de

plastification

Conditions de

stabilisation

Caractéristiques

Pièce stable

Stabilisation

{C0}

{C1}

{C2}

{C3}

{C4}

{P1}

{P2}

{P3}

{P4}

Variables de

finitions

Caractéristiques

Pièce finie

Finitions

{C} {P}

Figure 1.7 – Représentation Zig Zag du procédé d’injection-moulage des thermoplastiques.

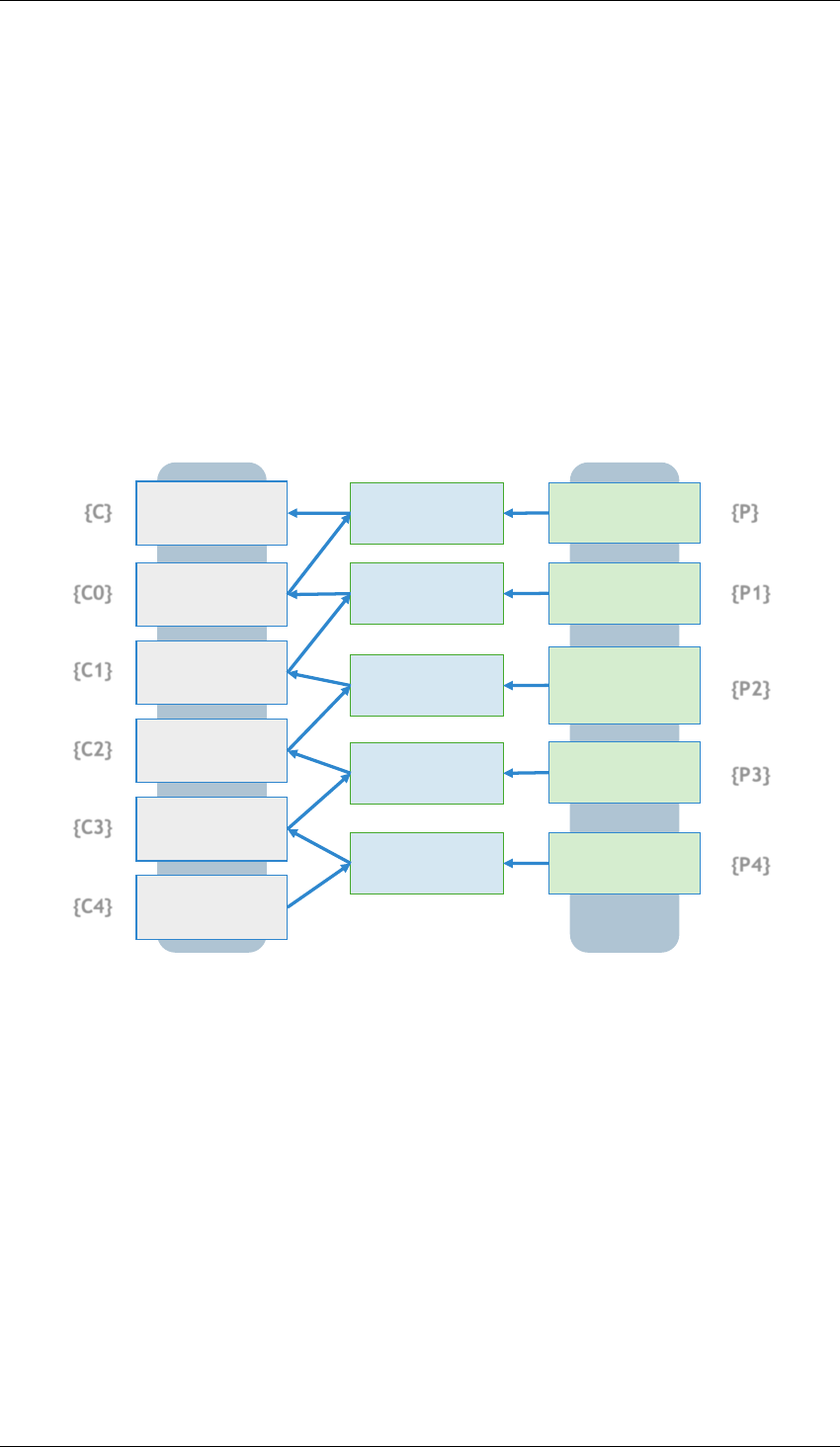

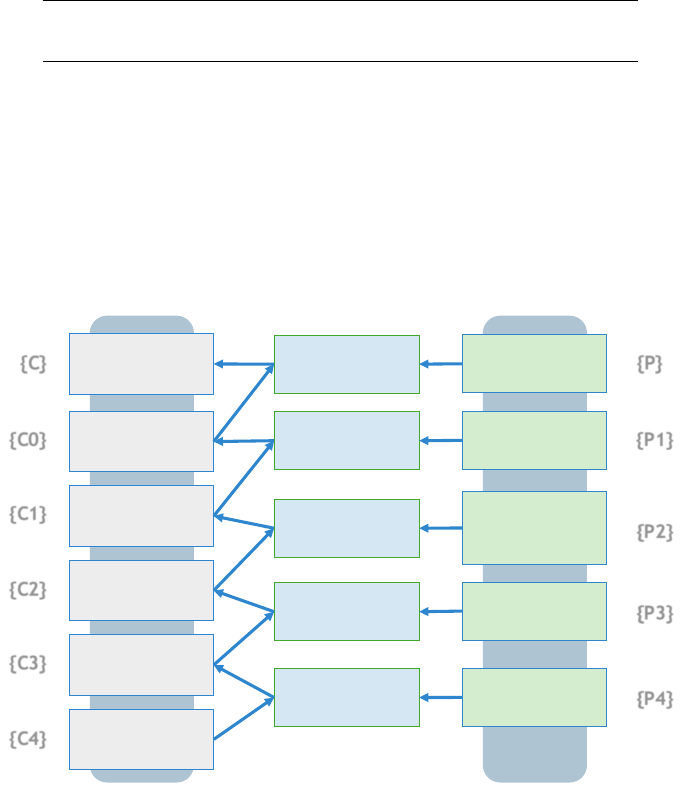

Nous nous appuyons sur la méthodologie Axiomatic Design pour représenter le procédé

[Suh90]. SUH propose la représentation Zig Zag, afin de mettre en évidence les liens entre

les paramètres d’un procédé (Process Variables) et les caractéristiques d’un produit (Design

Parameters). Dans la Figure 1.7, nous proposons une représentation Zig Zag du procédé

d’injection-moulage. La représentation Zig Zag fait apparaître les variables du procédé P

P

P

i

i

i

et les

caractéristiques du produit lors de chacune des phases C

C

C

i

i

i

. Les caractéristiques du produit fini C

C

C

sont fonction de l’ensemble des phases. De plus, chaque phase est fonction des phases précédentes,

ainsi que des variables du procédé. Si un réglage est modifié au niveau de l’une des phases i, les

caractéristiques du procédé pour toutes les phases suivantes C

C

C

j>i

pourront être modifiées.

Nous remarquons en particulier que les caractéristiques d’une pièce finie sont liées aux phases

de stabilisation et de finition. Or, la stabilisation de pièces prend du temps. Sur des pièces massives,

il faut attendre plusieurs heures que la pièce refroidisse et que les contraintes internes se stabilisent.

C’est pourquoi, les étapes de finition sont généralement réalisées plusieurs heures après l’injection-

moulage d’une pièce.

14

1.3. Revue de la recherche académique sur le procédé d’injection-moulage

Dans la suite de cette section, nous présenterons les publications les plus importantes

concernant la modélisation du procédé d’injection-moulage. Nous distinguons les modélisations

physiques, qui cherchent à proposer un modèle mathématique du procédé à partir de connaissances

théoriques, des modélisations empiriques qui utilisent les données d’expériences pour identifier un

modèle mathématique.

1.3.2.2 Modélisations physiques du procédé d’injection-moulage

La nature multivariée du procédé rend difficile la définition d’un modèle théorique. En 1987,

AGRAWAL, PANDELIDIS et PECHT estiment, en conclusion de leur revue de la régulation du

procédé d’injection-moulage, que les futurs travaux de recherche devront prendre en compte

l’ensemble des variables d’entrée, ainsi que leurs interactions [APP87]. Pourtant, d’après le

Tableau A.1 aucun des modèles proposés dans la littérature après 1987 ne prend en compte

l’ensemble des 12 variables de ce procédé, telles que présentées dans la Figure 1.6, voir l’Annexe

A Tableau A.1.

Un modèle théorique doit prendre en compte les nombreuses interactions multi-physiques

entre chaque phase du procédé. De plus, la connaissance de la physique des polymères reste un

champ de recherche ouvert. L’évolution de la cristallinité d’un polymère, lors de sa solidification,

peut par exemple être modélisée par l’équation de NAKAMURA et al. [Nak+72; NKA73]. Le

lecteur intéressé la modélisation micro-mécanique des polymères semi-cristallin pourra se référer

à la monographie de GALESKI et RÉGNIER [GR09]. Les auteurs discutent en particulier des

contraintes thermo-mécaniques qui s’exercent sur la matière pendant un cycle de production.

Ils analysent les conséquences de ces contraintes sur les propriétés cristallographiques et sur les

propriétés mécaniques macroscopiques des pièces.

À l’échelle macroscopique, plusieurs travaux propose de modéliser les phases de dosage,

injection, maintien et le refroidissement. En 1991, CHIU, SHIH et WEI proposent un modèle non-

linéaire des phases de dosage et d’injection, à partir des lois d’écoulement d’un fluide visqueux

et compressible [CSW91]. Huit variables d’état sont utilisées : délai avant le début du dosage,

pression d’arrivée de la matière pour le dosage, pression d’injection, position de la vis, pression

de la vis, volume du polymère dans l’empreinte et débit du polymère. Leur travail compare le

modèle avec des mesures de pression et de température dans l’outillage : les profils des résultats

de mesure et du modèle sont similaires. En 2004, BÉREAUX et al. proposent un modèle de l’étape

de dosage et de la plastification du polymère, à partir des lois d’écoulement non-newtoniennes des

polymères visqueux [Bér+04]. Les travaux de doctorat de LE GOFF propose une modélisation des

phases de maintien et de refroidissement, qui s’appuie sur les transferts thermiques au niveau des

parois [Le +05; Le 06]. En particulier, LE GOFF montre qu’il est nécessaire de prendre en compte

la transformation cristalline du polymère, car les propriétés thermiques de ce dernier évoluent

pendant le refroidissement.

Enfin, la méthode des éléments finis permet d’appliquer des modèles physiques élémentaires

sur des millions d’éléments discrets. Elle est particulièrement utilisée pour modéliser les phases

de dosage et d’injection du polymère fondu [MNB09]. À partir de la simulation de l’évolution

des variables du procédé, elle permet également d’optimiser la conception des outillages et de

dimensionner les structures [GTW08].

L’ensemble de ces travaux s’intéressent à des phases spécifiques du procédé. À notre

connaissance, aucun travail de la littérature ne prend en compte l’ensemble des phases et des

paramètres du procédé, telles que présentés dans la Figure 1.7. Dans la suite de nos travaux, nous

ne nous appuierons pas sur les connaissances de modèles physiques. En effet, notre problématique

de contrôle de la qualité nécessite de répondre à une grande variété de cas d’applications.

Cependant, les modèles théoriques de la littérature sont spécifiques à certains matériaux et à

certains cas d’applications. De plus, les modèles théoriques aujourd’hui établis ne permettent pas

de simuler l’ensemble des caractéristiques du produit que nous devons contrôler.

15

Chapitre 1. Contexte industriel et problématique de recherche

1.3.2.3 Modélisations empiriques du procédé d’injection-moulage

La littérature en injection-moulage est fournie d’études expérimentales. La démarche classique

est l’identification de modèles à partir de mesurages sur le procédé.

Dès 1974, MA propose de modéliser les phases du procédé à l’aide de fonctions polynomiales,

qui sont identifiées par des mesures expérimentales [Ma74]. Il discute de l’utilisation du support

informatique pour stocker les données, définir les fonctions et réaliser l’identification. La

modélisation du procédé complet est la composé des modèles fonctionnels des différentes phases

successives. Ce travail ne propose pas de validation expérimentale de la méthode présentée.

En 2000, DELAUNAY et al. montrent l’influence de la déformation du moule pendant le cycle

d’injection [Del+00b]. Ce travail étudie les limites des modèles existants à partir de mesures

expérimentales pendant les phases de maintien et de refroidissement. Ils montrent également la

nécessité de prendre en compte l’évolution du contact entre le polymère et les parois du moule

[Del+00a]. En effet, la matière fondue n’est pas en contact continu avec la paroi. Des poches d’airs

peuvent se former ; ce qui modifie sensiblement les variables de refroidissement et la cristallisation

du polymère. Les travaux antérieurs assumaient que le moule était indéformable et que le contact

entre le moule et le polymère était parfait. La démarche de ces travaux est l’identification des

paramètres d’un modèle polynomial, à partir de mesures de température et de pression dans

le moule. Les auteurs remarquent la nécessité de modéliser le couplage entre l’évolution de la

géométrie du moule et le refroidissement, pour simuler correctement les contraintes imposées à

la matière. Les modèles identifiés par les auteurs sont limités aux cas d’études spécifiques sur

lesquelles les mesures expérimentales ont été réalisées.

Nous remarquons, dans la littérature de l’injection-moulage, deux grandes démarches utilisées

pour identifier des modèles multivariés :

— l’exploration et la modélisation du procédé par les plans d’expériences §1.3.2.3 qui permet

d’identifier des modèles empiriques,

— l’identification de modèles par apprentissage, à l’aide de réseaux de neurones §1.3.2.3.

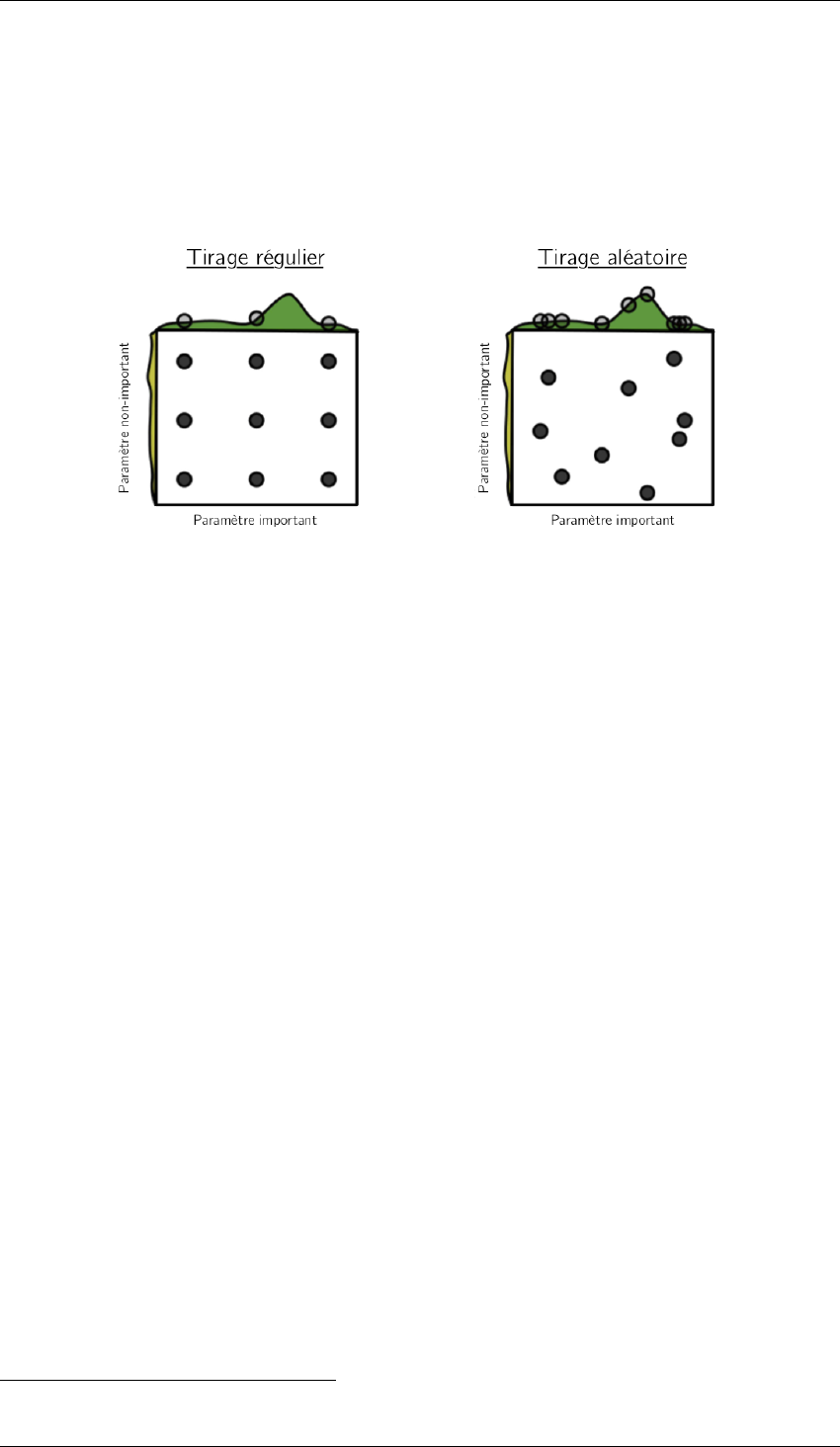

1.3.2.3.1 Plan d’expériences

Les plans d’expériences permettent de construire un modèle polynomiale d’un système à plusieurs

paramètres. De plus, ils permettent d’adapter la quantité d’essais expérimentaux à réaliser en

fonction de l’ordre du modèle que l’on cherche à obtenir. Les essais sont réalisés suivant une table

de variation des paramètres. Nous discutons des plans d’expériences dans le Chapitre 3.1 Section

2.1.1. Le modèle obtenu permet théoriquement d’optimiser une sortie en fonction des paramètres,

et ainsi, comme tout modèle de trouver un point de fonctionnement idéal.

En 1993, RÉGNIER et TROTIGNON sont les premiers à proposer l’utilisation des plans

d’expériences pour identifier un modèle polynomial d’ordre 2 avec interactions du phénomène

de retrait, à partir de 6 paramètres du procédé [RT93 ; RS94]. De nombreux travaux utiliseront

par la suite cette démarche expérimentale. En 2013, FEI, MEHAT et KAMARUDDIN réalisent une

étude rétrospective de 1999 à 2010, sur l’utilisation de la méthode des plans d’expériences en

injection-moulage [FMK13]. Ils distinguent deux utilisations faites dans la littérature :

— produire un jeu de données expérimentales pour identifier des modèles,

— limiter le coût de l’optimisation par simulations numériques en utilisant un modèle

intermédiaire construit par plans d’expériences.

L’étude de FEI, MEHAT et KAMARUDDIN remarque en particulier qu’un nombre important

de modèles est identifié par apprentissage, à l’aide de réseaux de neurones. La théorie des

plans d’expériences permet d’identifier des modèles polynomiaux. Or, les variables qui entrent

en jeu dans le procédé d’injection-moulage ont souvent des réponses non linéaires par rapport

aux paramètres de réglages et des interactions qui peuvent être difficilement modélisé par des

16

1.3. Revue de la recherche académique sur le procédé d’injection-moulage

polynômes. C’est pourquoi les modèles à réseaux de neurones ont été largement utilisés dans la

littérature.

Nous utiliserons dans nos travaux un plan d’expériences de criblage pour construire notre jeu

de données, dans le Chapitre 3.1. Cela permet de parcourir un espace représentatif de la plage de

fonctionnement du procédé en un minimum d’essais.

1.3.2.3.2 Modélisation par réseaux de neurones

L’utilisation des réseaux de neurones pour la modélisation dans les systèmes industriels est

proposée dès 1980. Un réseau de neurones est une composée de fonctions non-linéaires. Il est

adapté à l’identification de modèles aux multiples entrées. Il est intéressant de noter que le procédé

d’injection-moulage est également représenté par une composition de fonctions dans la littérature :

MA [Ma74] utilise une fonction polynômiale pour modéliser chaque phase du procédé.

En 2000, SCHNERR-HÄSELBARTH et MICHAELI proposent le système Intelligent Quality

Control [SM00]. Un algorithme à réseaux de neurones est utilisé pour prédire la caractéristique

de la masse des pièces produites, à partir des variables du procédé. Les données d’apprentissage

proviennent d’un plan d’expériences factoriel à trois niveaux, sur trois paramètres du procédé :

température du fondu, pression de maintien et vitesse d’injection. À intervalle temporels régulier,

150 points de mesure de la pression dans le moule sont enregistrés pendant les phases d’injection

et de maintien. La masse de la pièce est mesurée dès la sortie de la machine avec une résolution

au 1 milligramme; les expériences conduisent à une variation de masse de 1,4%. Le réseau est

alors capable de prédire la masse des pièces avec une exactitude de 86%, soit une moyenne de 5

milligrammes d’erreur sur une masse total de 35 milligrammes. Ces résultats mettent en valeur

l’intérêt des modèles qui utilisent des réseaux de neurones.

1.3.3 Maîtrise du procédé d’injection-moulage des thermoplastiques

Dans cette section, nous positionnerons notre travail de contrôle de la qualité en ligne de

production dans la thématique de recherche de la maîtrise du procédé d’injection-moulage.

L’objectif final est de maîtriser la qualité du produit : c’est à dire de limiter la dispersion des

caractéristiques des pièces produites. Nous résumons cette démarche en nous référant à notre

représentation Zig-Zag Figure 1.7 :

1. réglage initial d’un point de fonctionnement (paramètres P

P

P

2−4

)

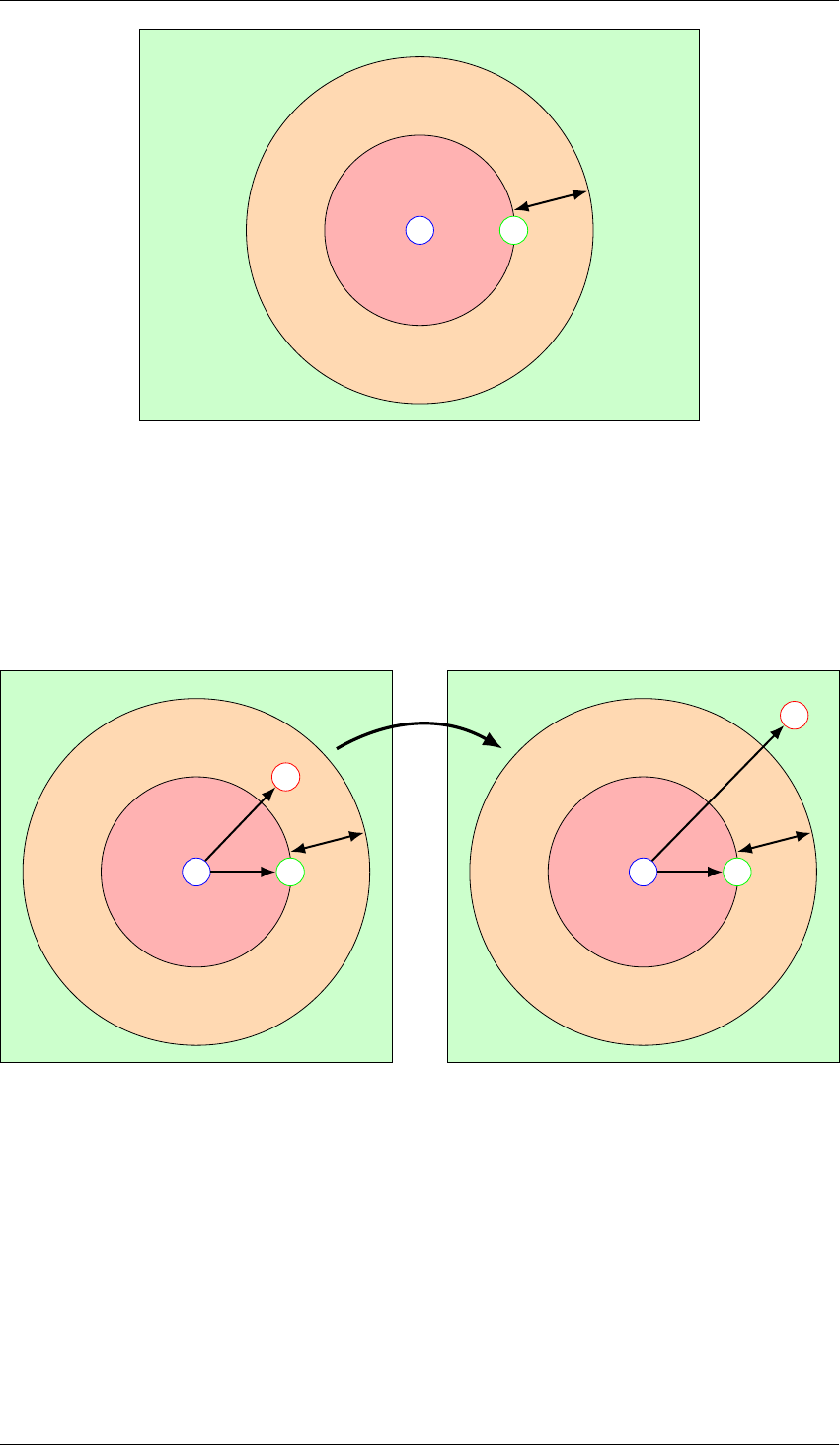

2. régulation du point de fonctionnement P

P

P

2−3

3. détection des dérives du procédé C

C

C

1−3

,

4. ajustement des paramètres P

P

P

2−4

afin de corriger les caractéristiques C

C

C

0−1

,

L’Annexe A propose une étude bibliographique des techniques proposées afin de maîtriser le

procédé d’injection-moulage. Le Tableau A.1 de l’Annexe A récapitule cette revue de la littérature.

On observe que les travaux de recherche initiaux utilisent l’automatique pour réguler le procédé.

Dernièrement, les travaux s’appuient principalement sur une démarche de Maîtrise Statistique des

Procédés.

À partir de l’étude de ces travaux et de notre connaissance de la pratique industrielle de la

plasturgie, nous identifions les trois difficultés du procédé d’injection-moulage :

— le réglage initial du point de fonctionnement (paramètres P

P

P

2−4

),

— la surveillance des dérives des caractéristiques du procédé C

C

C

1−4

et du produit C

C

C

0

.

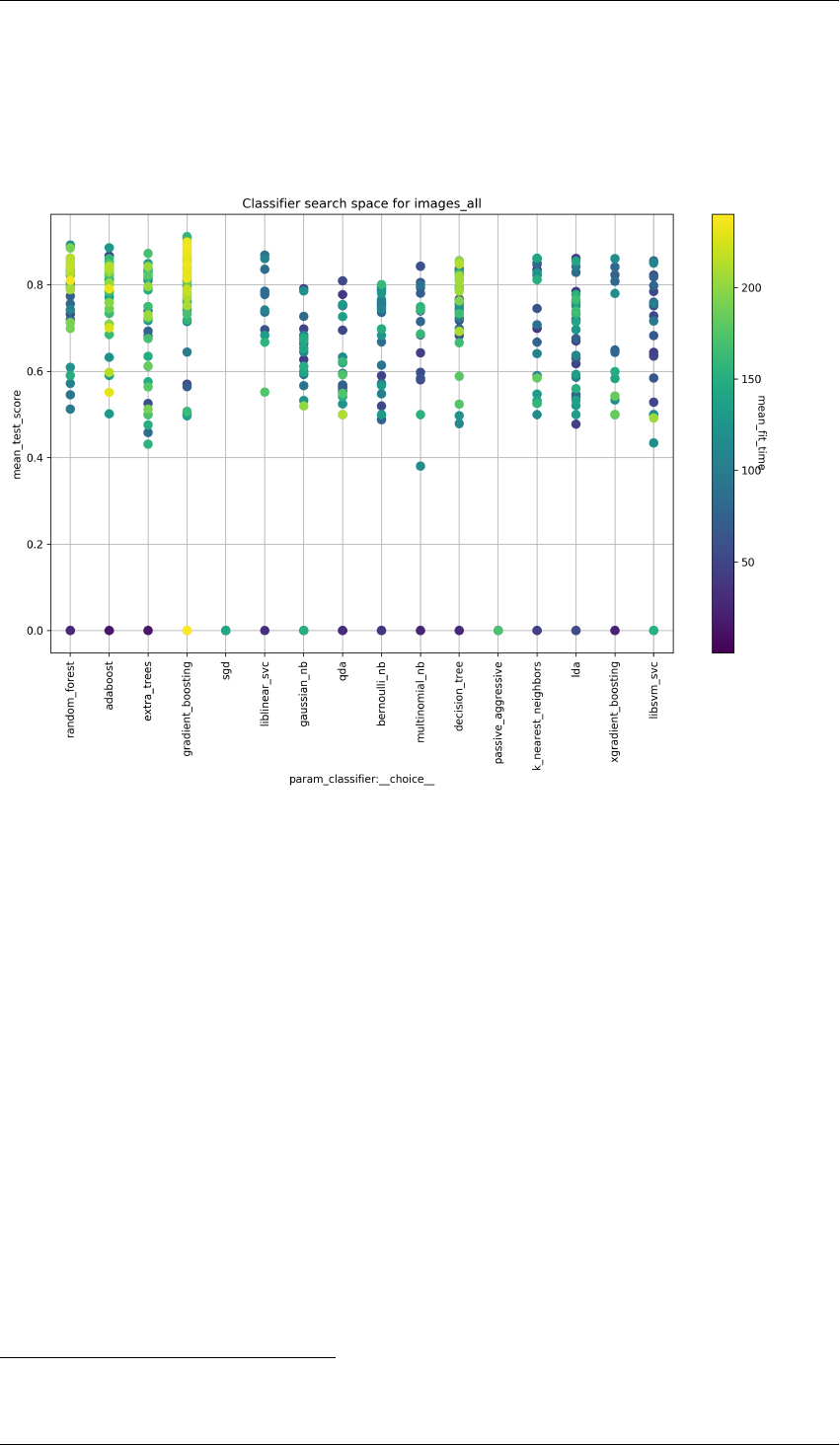

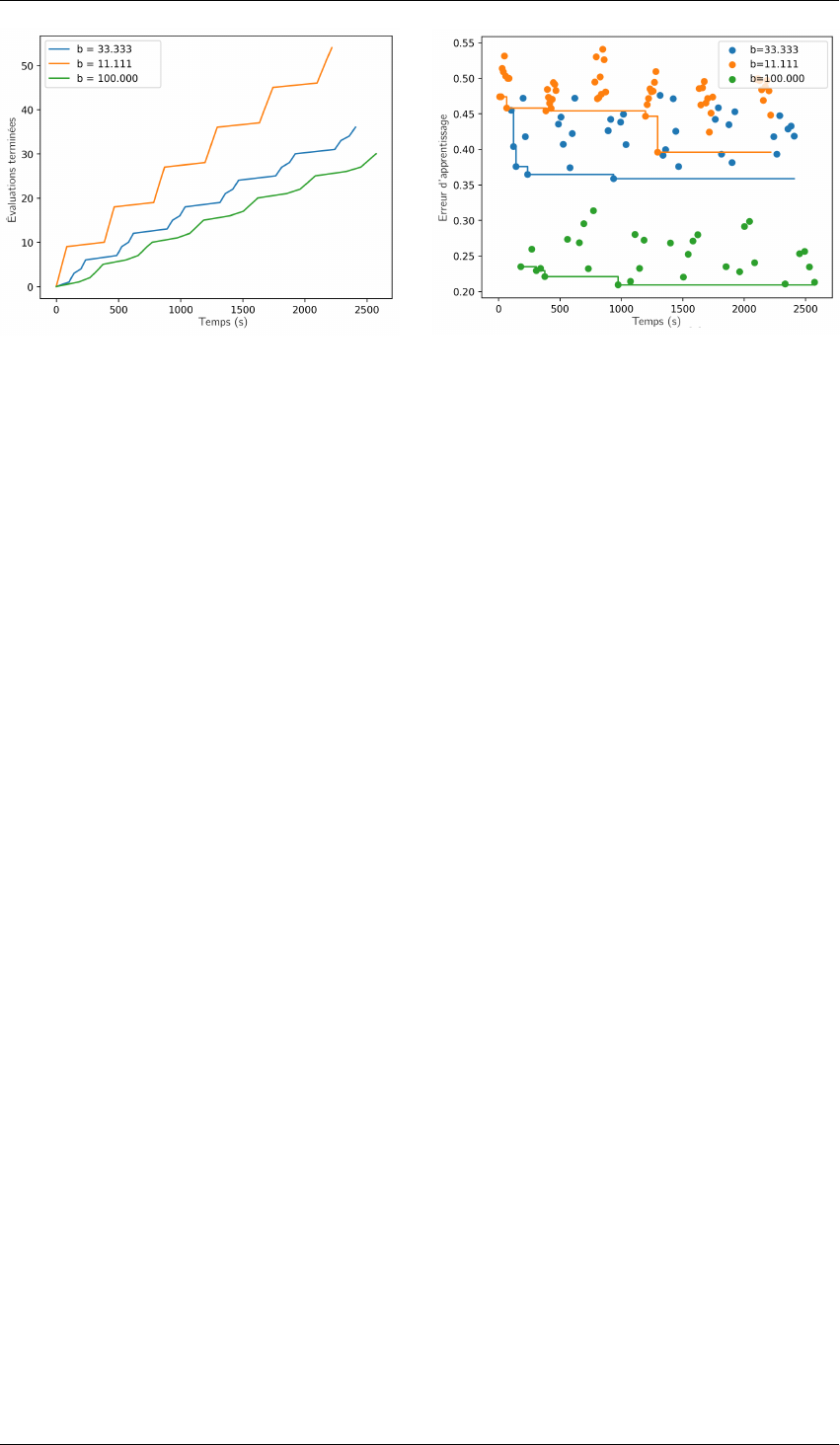

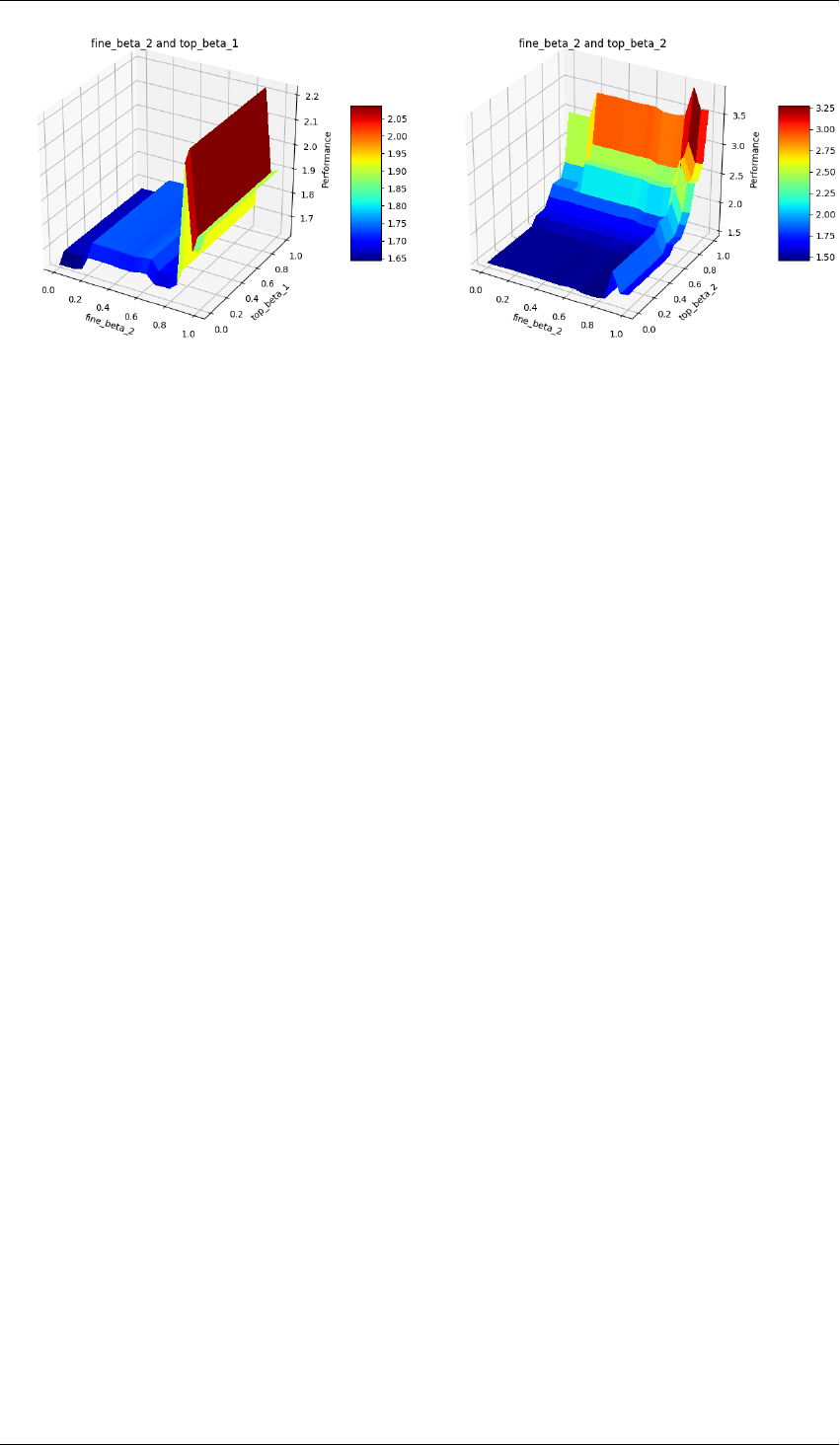

— l’ajustement des réglages P

P

P

2−4

pour corriger les caractéristiques du produit C

C

C

0

.

Aujourd’hui, l’industrie de la plasturgie repose sur l’expérience du technicien-régleur

pour définir le point de fonctionnement initial. Le bureau d’étude peut définir un point de

fonctionnement mais un ajustement précis devra être réalisé par le technicien-régleur. Il n’existe

pas de méthode de réglage automatique du point de fonctionnement, mais des systèmes

17

Chapitre 1. Contexte industriel et problématique de recherche

d’assistance au réglage ont été proposés §A.1.1. La multitude de paramètres qui peuvent être

ajustés sur le procédé rend difficile la découverte automatique d’un point de fonctionnement

permettant de produire une pièce conforme. Le technicien-régleur réalise cette tâche grâce à sa

connaissance empirique du procédé. Aussi, le réglage initial de la presse à injecter est long. La

pratique industrielle est l’ajustement de chacun des paramètres P

P

P

2−4

du procédé, pour que les

variables intermédiaires C

C

C

1−4

soient satisfaisantes, ainsi que les caractéristiques C

C

C

0

du produit.

De plus, il est impossible pour un technicien régleur d’avoir une vue d’ensemble de la valeur des

variables intermédiaires car elles ne sont pas toujours mesurées; voir parfois non mesurables. Dans

la pratique, le réglage initial du point de fonctionnement est une opération itérative et empirique.

De la même manière, si l’on souhaite corriger une caractéristique C

C

C

0

du produit, il est difficile

de déterminer comment modifier les réglages P

P

P

2−4

. Cela est rendu d’autant plus compliqué par le

fait que les caractéristiques de la pièce stable C

C

C

0

ne sont connues que plusieurs heures après sa

production.

La régulation du procédé d’injection-moulage est le sujet de nombreux travaux. Les outillages

modernes possèdent des capteurs qui permettent de connaître précisément les caractéristiques de

la matière, ou même la pression ou la température dans le moule. La méthode qui est certainement

la plus avancée a été proposée en 2009. MICHAELI et SCHREIBER réalise la régulation des

paramètres de l’ensemble des phases d’injection, de maintien et de refroidissement [MS09]. Cela

permet de suivre le diagramme Pression, Volume, Température (PVT) de transformation de la

matière idéal pendant l’ensemble du cycle (voir Annexe §A.2). La difficulté de la régulation de

toutes les variables C

C

C

2−3

est due à la complexité de la modélisation du procédé, en particulier des

interactions entre les variables. Les auteurs de cette étude utilisent un modèle à réseau de neurones

qui est identifié à partir des mesures de pression et de températures dans le moule pendant le cycle.

L’optimisation des paramètres à partir du modèle permet de trouver les ajustements qui permettent

de suivre le diagramme PVT. Les auteurs étudient l’effet de cette régulation du procédé sur la

dispersion de la masse des pièces, lorsque la température du fourreau est modifié pour introduire

une perturbation : la masse est stabilisée.

En 2003, PILLET, MAIRE et BRONET proposent des principes pour adapter la Maîtrise

Statistique des Procédés à l’injection-moulage [PMB03]. Le choix des variables à contrôler

peut se faire sur les paramètres du procédé et sur les caractéristiques du produit. Les auteurs

recommandent de choisir peu de variables. Celles-ci doivent être les plus représentatives possibles

des défauts à surveiller. Enfin, il est recommandé de choisir des variables faciles à mesurer. Le

procédé d’injection-moulage est capable de produire une pièce toutes les dizaines de secondes.

Le risque de contrôler une pièce conforme comme une pièce non-conforme est appelé le risque

de faux positif. Ce risque est généralement défini à plus ou moins trois fois l’écart-type de

la distribution de la valeur surveillée. Dans le cas d’un temps de cycle de 30 secondes, cela

correspondrait à une fausse alarme toutes les 2,5 heures, soit 0,27% de pièces hors-contrôles.

Cette fréquence est trop élevée, c’est pourquoi les auteurs recommandent d’ajuster le risque à 4,5

fois l’écart-type, soit 0, 00068% de pièces hors-contrôles, soit une pièce toutes les 992 heures de

production.

Une démarche complémentaire à la détection des dérives serait de réaliser un ajustement des

paramètres du procédé pour compenser la dérive, c’est la régulation du procédé.

18

1.4. Problématique industrielle : le contrôle qualité en ligne de production

1.4 Problématique industrielle : le contrôle qualité en ligne de

production

Dans le cadre de productions industrielles par injection-moulage des thermoplastiques, les

contrôles qualité sont traditionnellement effectués sur les produits finis, juste avant l’expédition

des pièces. Il s’agit de s’assurer que les pièces sont conformes aux exigences spécifiées par le

cahier des charges. Les pièces non-conformes sont mises au rebut. Le contrôle qualité final est

réalisé à l’issue des étapes de finition, telles que la peinture et la décoration. Pour des productions

de pièces à faible valeur ajoutée, le contrôle est souvent réalisé par prélèvements aléatoires de

pièces. Il est effectué par un opérateur humain, ce qui est coûteux. Le contrôle peut nécessiter

la mesure de dimensions géométriques ou de propriétés mécaniques de la pièce. La mesure

géométrique peut être réalisée à l’aide d’un pied à coulisse.

D’après le Tableau A.1, le mesurage des caractéristiques qualité des produits, dès leurs sorties

de l’outillage est peu étudiée. La caractéristique la plus étudiée dans la littérature est la masse de

la pièce [SM00; Fou+06; MS09]. Cela s’explique, par la rapidité de cette mesure et par la facilité

de la réalisation de la pesée, dès la sortie de la machine, ainsi que par la bonne précision des

balances. Dans l’industrie, la masse est souvent considérée comme une caractéristique qui valide

la qualité de la pièce. Si les pièces ont des manques, la masse sera nécessairement plus faible. De

plus, la densité de matière injectée fait varier la masse et fait également varier les caractéristiques

mécaniques. Surveiller la masse des pièces permet de détecter les manques matières et les défauts

les plus importants.

Nous remarquons que de nombreuses études annoncent réaliser le contrôle de la qualité

du produit, alors qu’elles s’intéressent uniquement à la masse ou à une unique dimension

géométrique. En revanche, les caractéristiques d’aspects des pièces sont rarement mesurées en

ligne de production. Les cahiers des charges posent pourtant des contraintes en termes d’aspect :

pas de trace, pas de tâche, une couleur uniforme, une texture définie.

De plus, les caractéristiques d’aspect contiennent des informations importantes pour l’analyse

des causes de la variabilité des caractéristiques d’une pièce. Le technicien-régleur utilise

prioritairement l’aspect des pièces pour régler la machine.

Une perspective à long terme de nos travaux pourra être le pilotage automatique du procédé

d’injection-moulage. Pourtant, aucun système de pilotage automatique n’a aujourd’hui pris en

compte les caractéristiques visuelles des pièces.

Dans nos travaux, nous chercherons à proposer un dispositif de contrôle adapté aux contraintes

industrielles. Nous avons identifié trois verrous au déploiement massif du contrôle qualité à cent

pour-cent sur les lignes de production :

Économique : c’est le coût du dispositif de mesure,

Technologique : le respect des contraintes industrielles et l’extraction de l’information sur la

qualité à partir des mesures,

Humain : la modélisation de la notion de qualité à partir de l’expertise humaine.

Dans les sections suivantes, nous détaillerons chacun de ces verrous. L’objectif de notre travail est

de proposer une solution technique pour les dépasser.

1.4.1 Viabilité économique du déploiement du mesurage de la qualité en ligne de

production

L’automatisation du contrôle des produits est principalement déployée pour des productions

à gros volumes. Les productions industrielles ont pour caractéristiques une cadence élevée, c’est

à dire un temps de cycle court. En Annexe, le Tableau C.1 présente la répartition économique

industrielle française par secteurs d’activité. Elle indique une marge moyenne de 27% pour

le secteur de la plasturgie française, en 2016 [Dir19]. C’est une marge relativement élevée

19

Chapitre 1. Contexte industriel et problématique de recherche

en comparaison des autres secteurs d’activé. Le nombre d’entreprise du secteur est également

important. En posant l’hypothèse que 1% de la marge du secteur de la plasturgie devrait être

dépensé pour automatiser le contrôle de la qualité (pour un chiffre d’affaires moyen de 1,3

millions d’euros par entreprise), on obtient un budget de 13 000C par entreprise pour le contrôle

qualité. Cette estimation permet de rendre compte du budget limité de l’automatisation du contrôle.

Contrairement à la transformation de la matière première, le contrôle de la qualité n’apporte pas de

valeur au produit final; c’est une sécurité pour respecter le cahier des charges et palier aux dérives

du procédé.

Pour un produit qui nécessite un niveau de qualité très élevé, il est nécessaire de réaliser

un contrôle qualité final de chaque pièce (contrôle à cent pour-cent). Dans le cas de l’injection-

moulage de pièces plastiques, le contrôle qualité final est souvent effectué plusieurs heures après

l’étape de moulage. Parfois, le contrôle final est réalisé après l’ajout de valeur des étapes de

finitions. Si la pièce est non-conforme juste après le moulage, alors de la valeur a été ajoutée à une

pièce non-conforme. De plus, la valeur ajoutée par les étapes de finitions, telles que la peinture ou

la galvanoplastie, est bien plus important que la valeur ajouté par l’injection-moulage. Si le temps

de cycle du procédé permet de produire une pièce toutes les 30 secondes, cela correspond à une

production de milles pièces par journée de 8 heures. Si le contrôle de la qualité est réalisé un jour

après la production, cela correspondrait ici à 1000 pièces d’encours. Ainsi, si un défaut est détecté

suite à ce contrôle qualité, l’ensemble des 1000 pièces de l’encours sont des pièces rebuts qui ont

été finies inutilement.

L’objectif du contrôle qualité en ligne est de détecter les défauts erratiques, ainsi que les dérives

de la qualité le plus tôt possible, afin d’écarter les pièces de la chaîne d’ajout de valeur.

Le moulage d’une pièce non-conforme a un coût négligeable en comparaison du coût des

étapes de peinture et de finitions de cette pièce non-conforme. Détecter les pièces non-conformes

dès la sortie de la presse d’injection, afin de les écarter de la chaîne de production, permet de

diminuer les rebuts finaux et de supprimer ainsi les coûts associés à leurs finitions.

1.4.2 Mesurage des variables d’état du procédé : mesurage indirect des

caractéristiques du produit

La littérature sur l’injection-moulage étudie peu le mesurage directe des caractéristiques du

produit. La majorité des travaux proposent de mesurer des variables physiques sur le procédé, à

partir de capteurs positionnés à l’intérieur de l’outillage et de la presse. En général, un modèle

est construit afin de prédire une caractéristique du produit, qui est souvent la masse de la pièce, à

partir des mesures dans le moule, qui sont souvent la pression et la température. L’argumentaire

de ces travaux est que les variables au plus proches de la matière fondue permettent de prédire au

mieux les caractéristiques finales de la pièce.

Une analyse multi-variée permet ensuite de détecter les dérives du procédé. Les capteurs les

plus répandus sont les sondes de température et les sondes de pression [Kur+09]. Le coût de cette

instrumentation invasive des moules est élevé. Intégrer les conduits, nécessaires au passage des fils

et connecteurs, est compliqué sachant que les moules ont également des canaux de refroidissement

indispensables au procédé. De plus, les capteurs subissent de fortes contraintes ce qui réduit

leur durée de vie. La défaillance d’un capteur nécessite l’arrêt de la production si l’on souhaite

conserver la surveillance.

Dans “Quality Prediction in Injection Molding”, nous proposons de construire un modèle qui

détermine la valeur d’une cote dimensionnelle de la pièce produite, à partir de mesures sur le

procédé [Nag+17]. Un capteur de pression et un capteur de température sont positionnées au

contact de la matière, dans le moule. La position des capteurs que nous utilisons est optimisée

selon la méthode de AGAZZI et al. [Aga+13]. À partir des signaux de capteurs de pression et de

température mesurés pendant le cycle du procédé, une valeur géométrique continue est prédite à

l’aide d’un modèle identifié par apprentissage statistique.

20

1.4. Problématique industrielle : le contrôle qualité en ligne de production

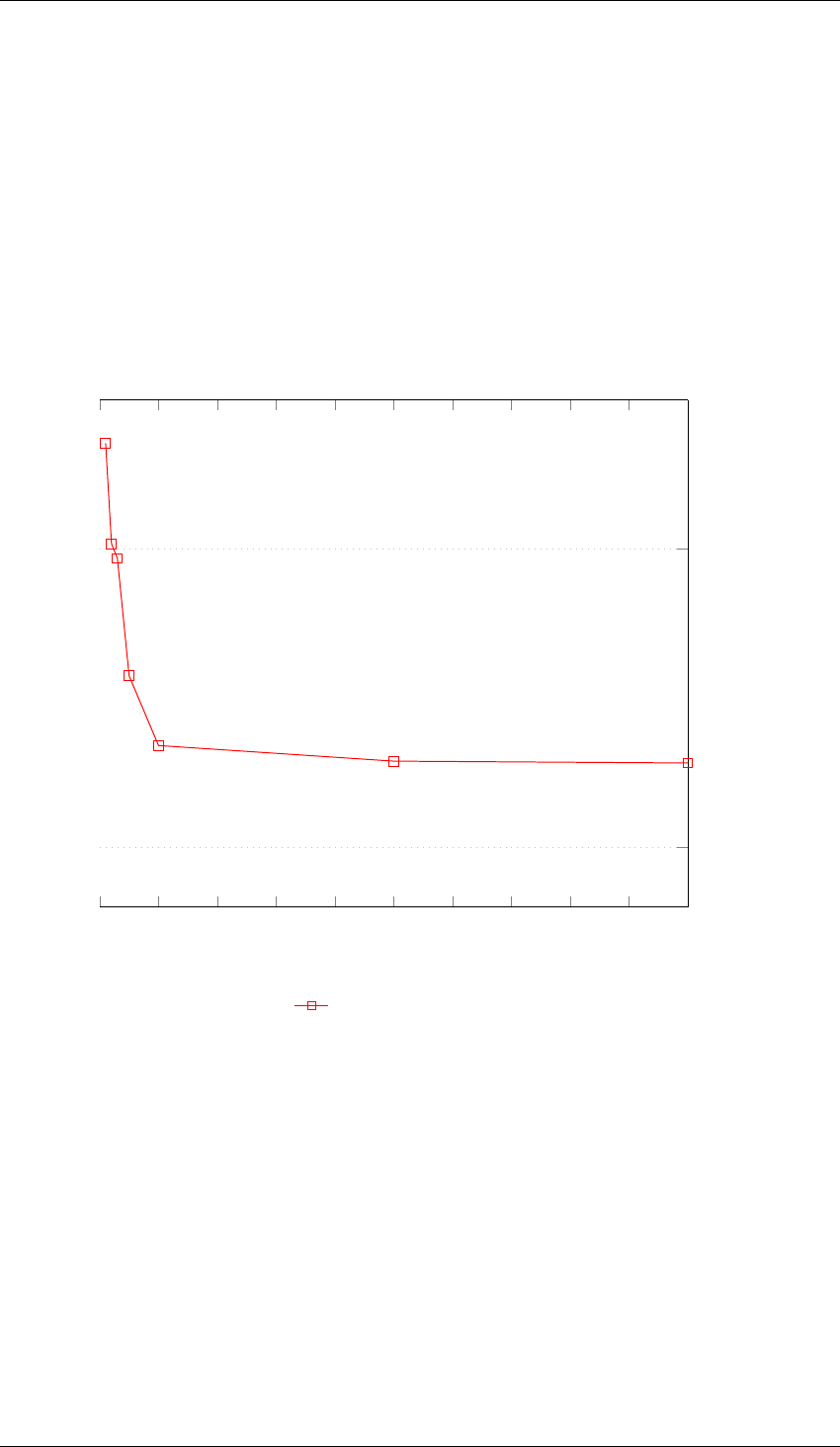

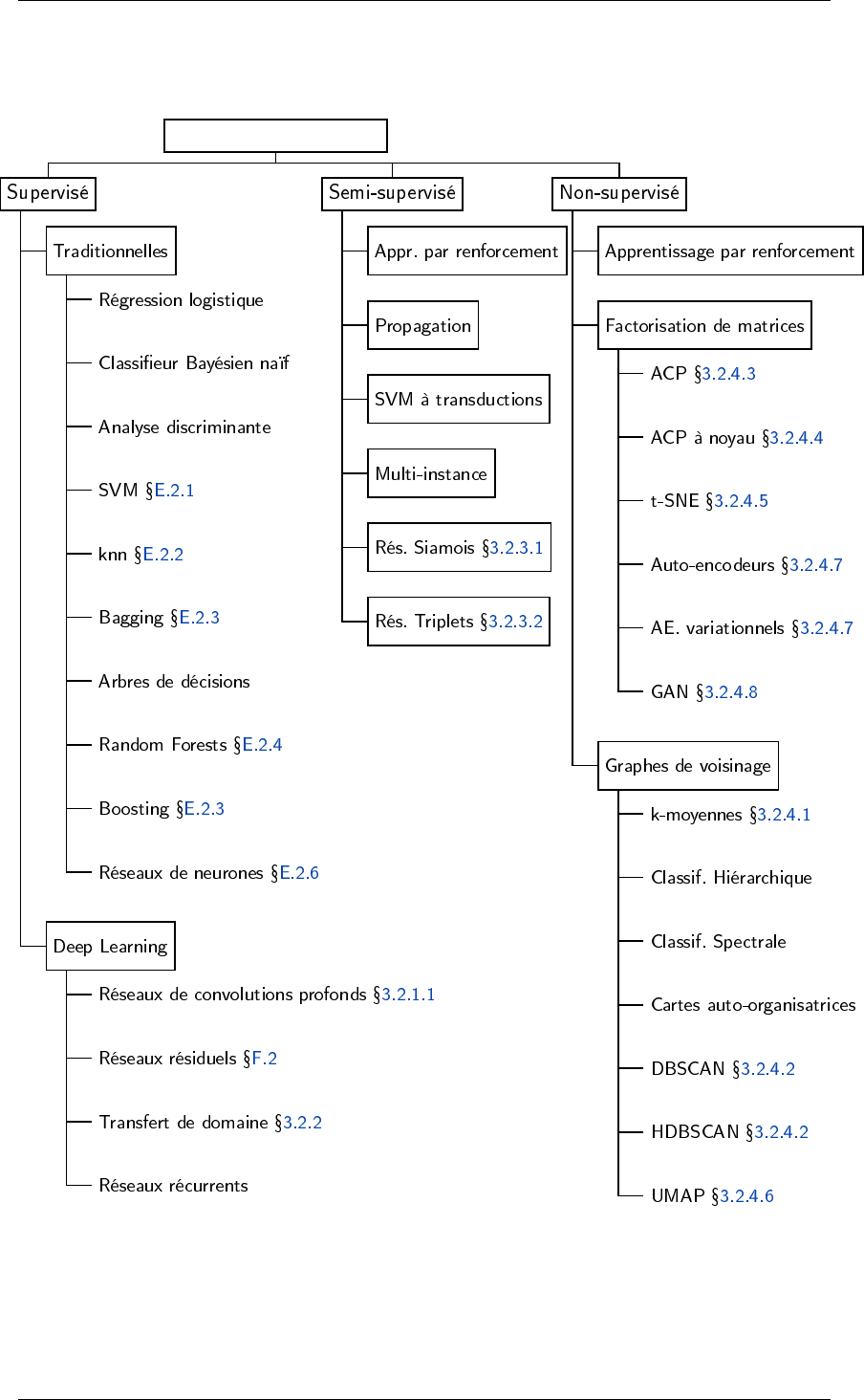

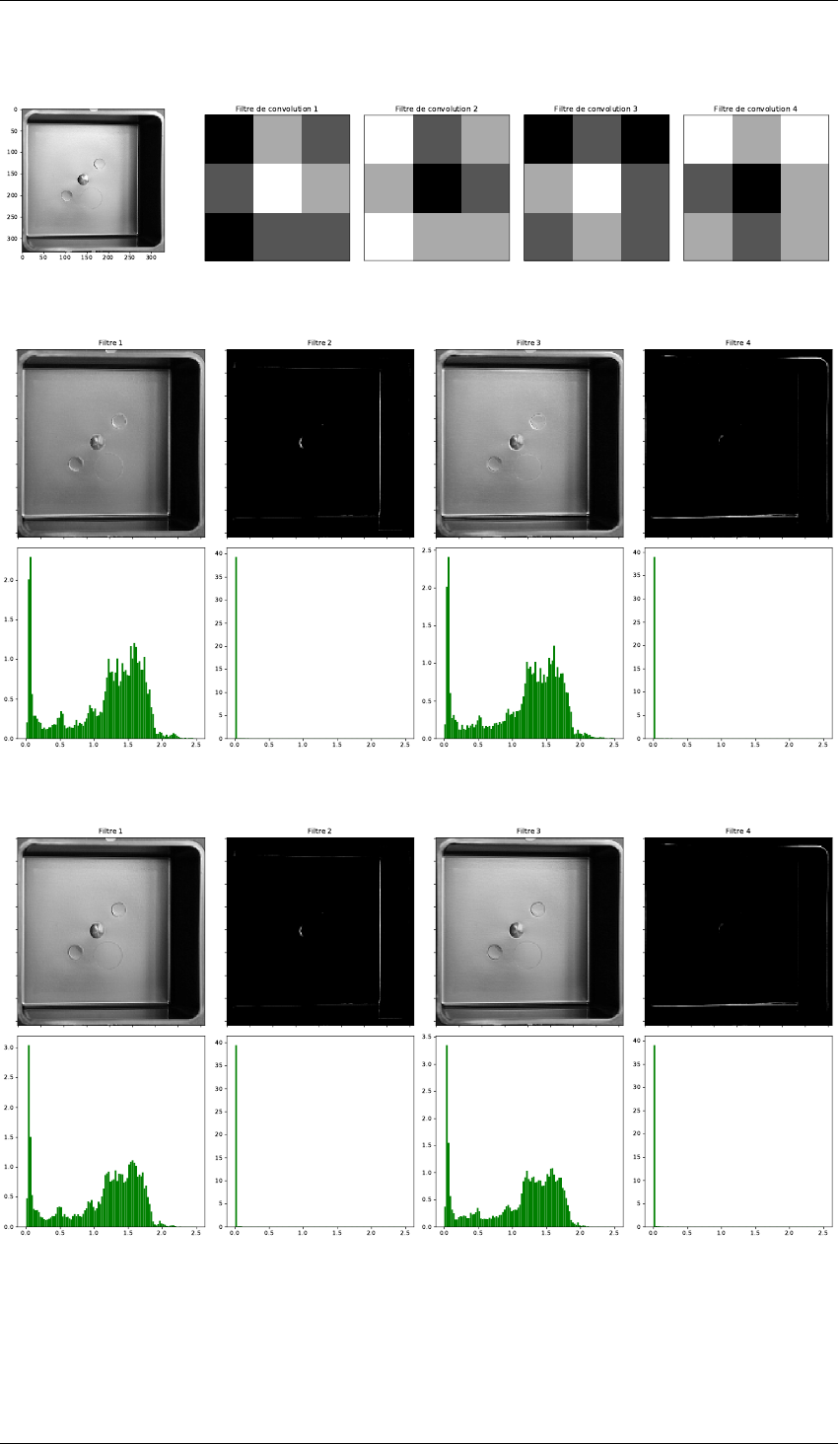

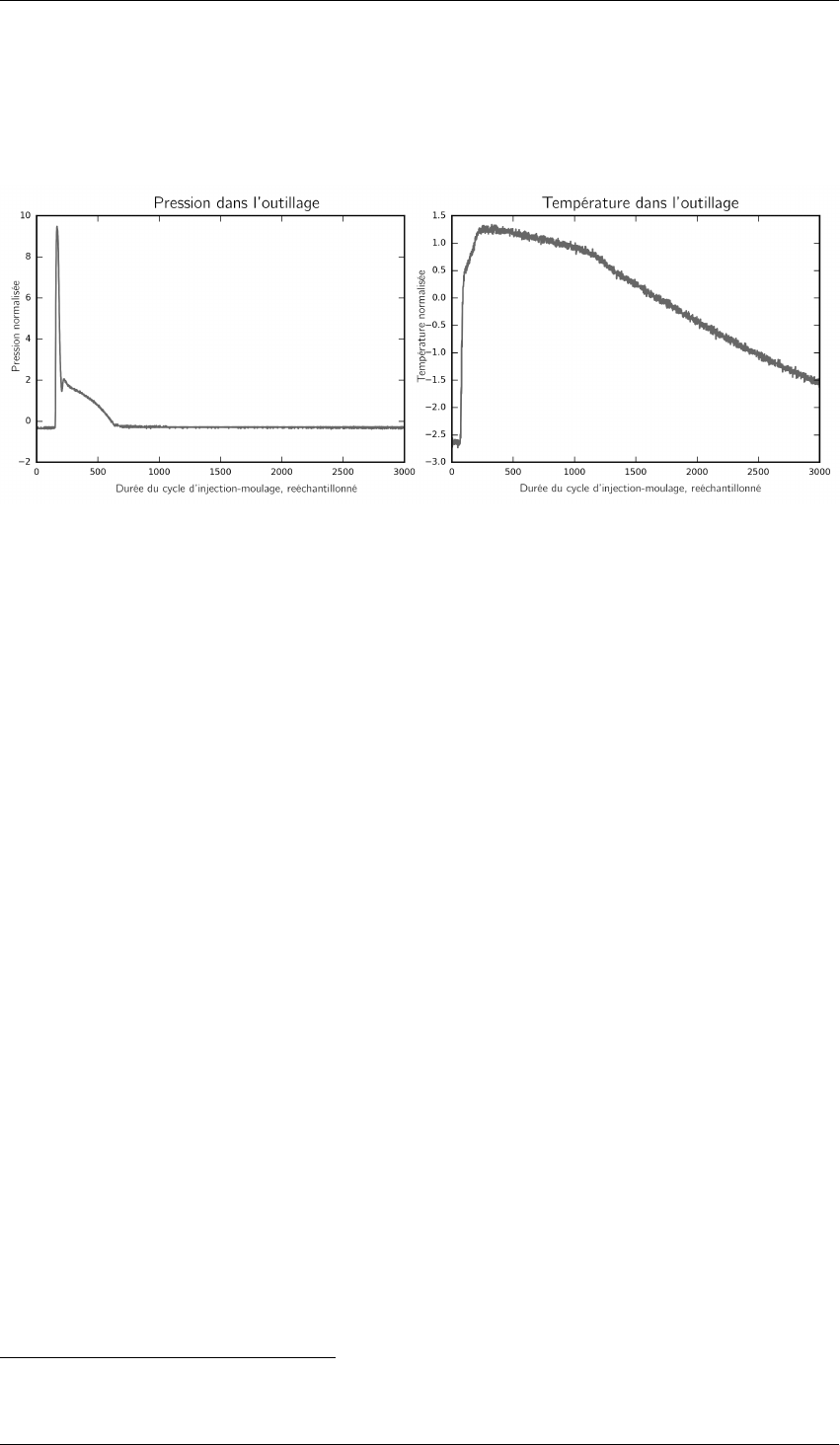

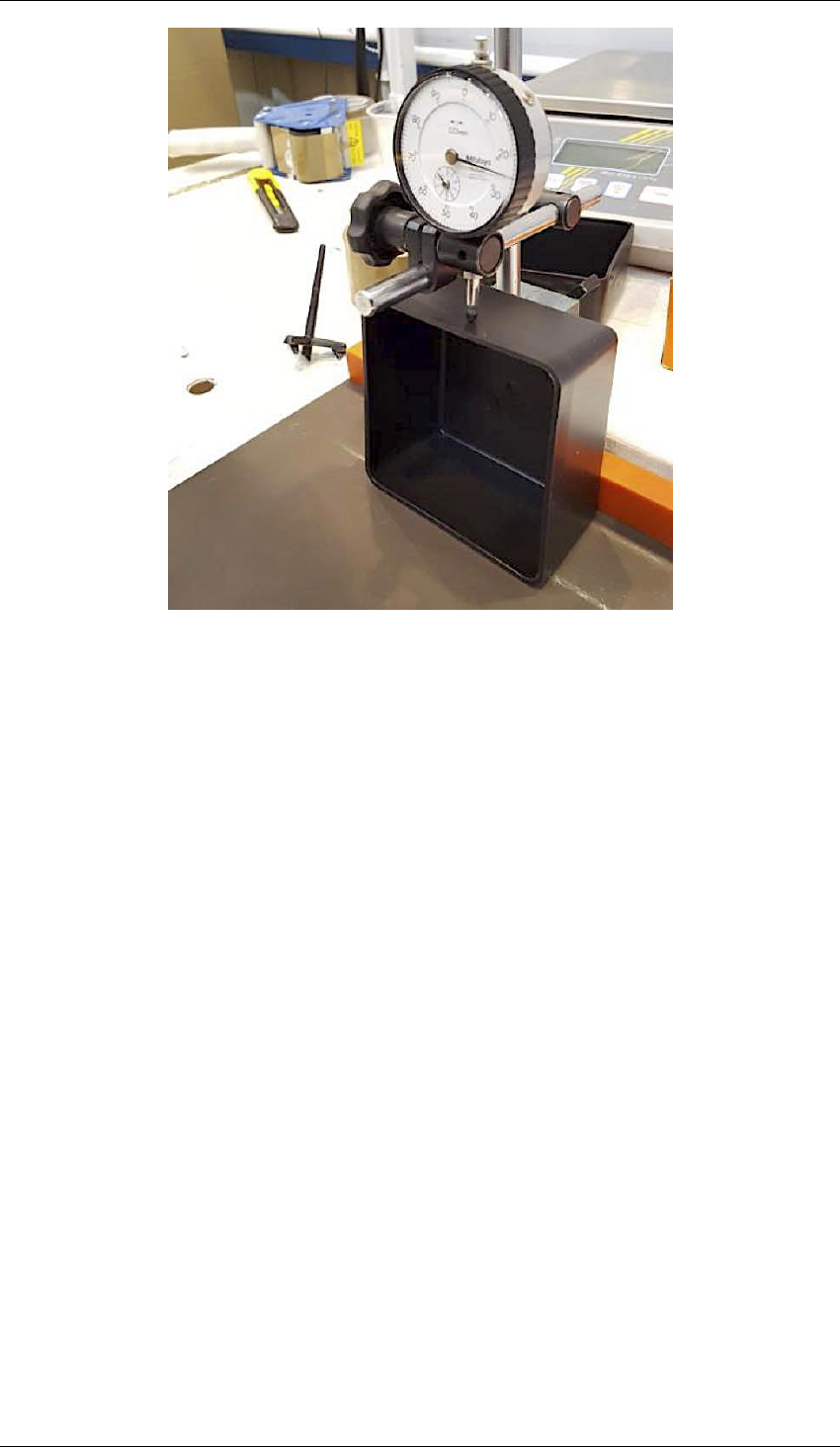

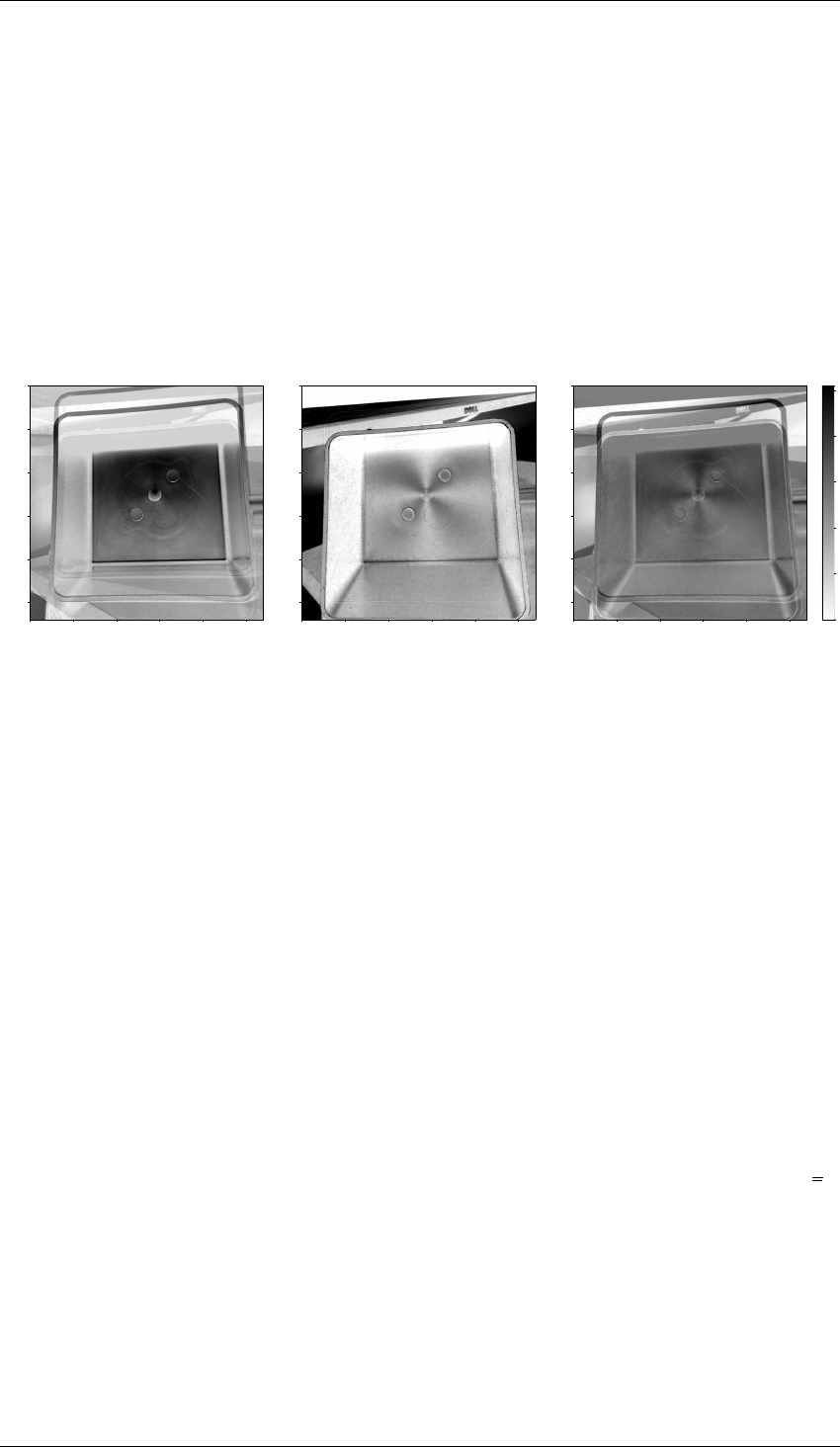

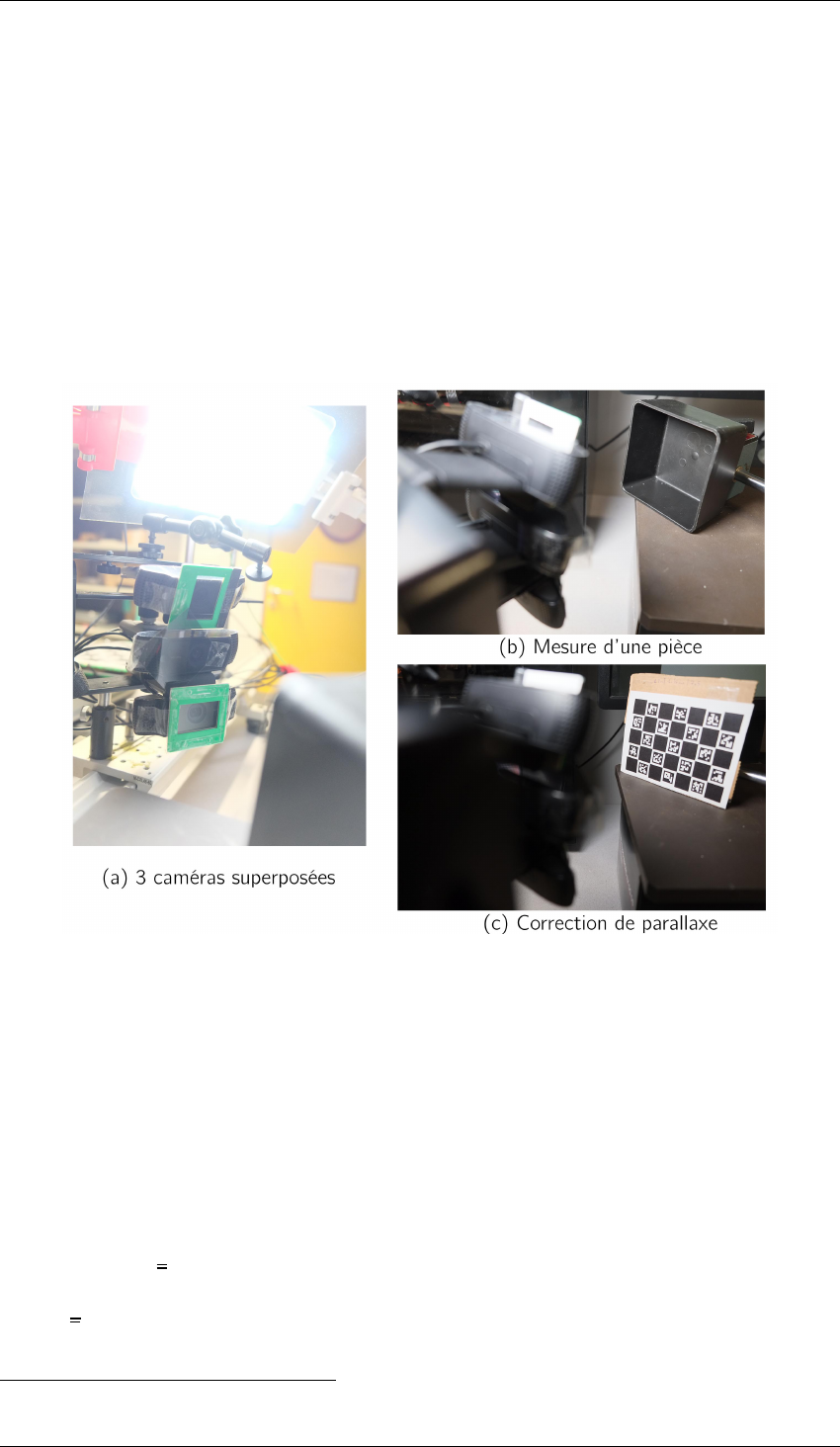

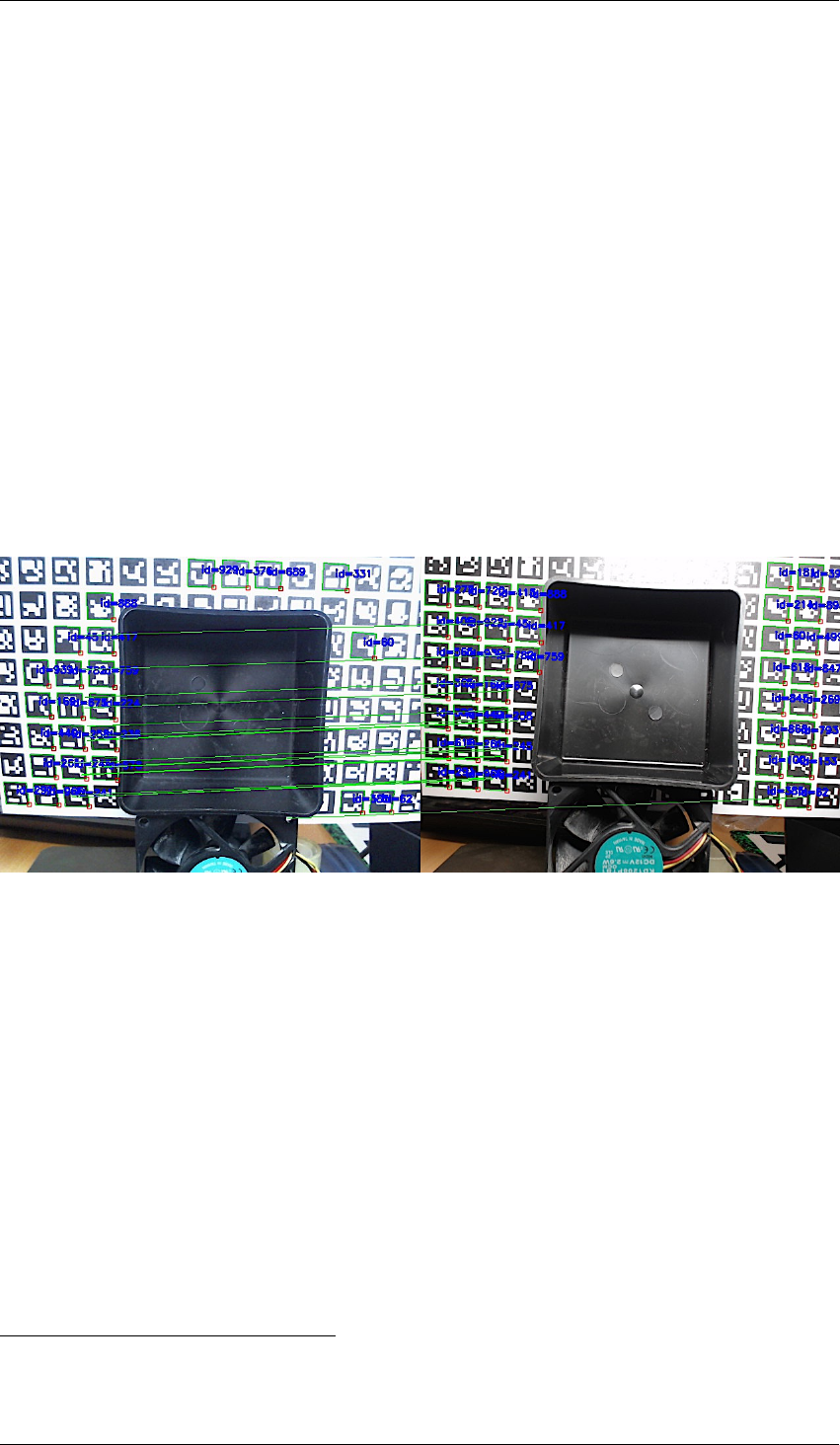

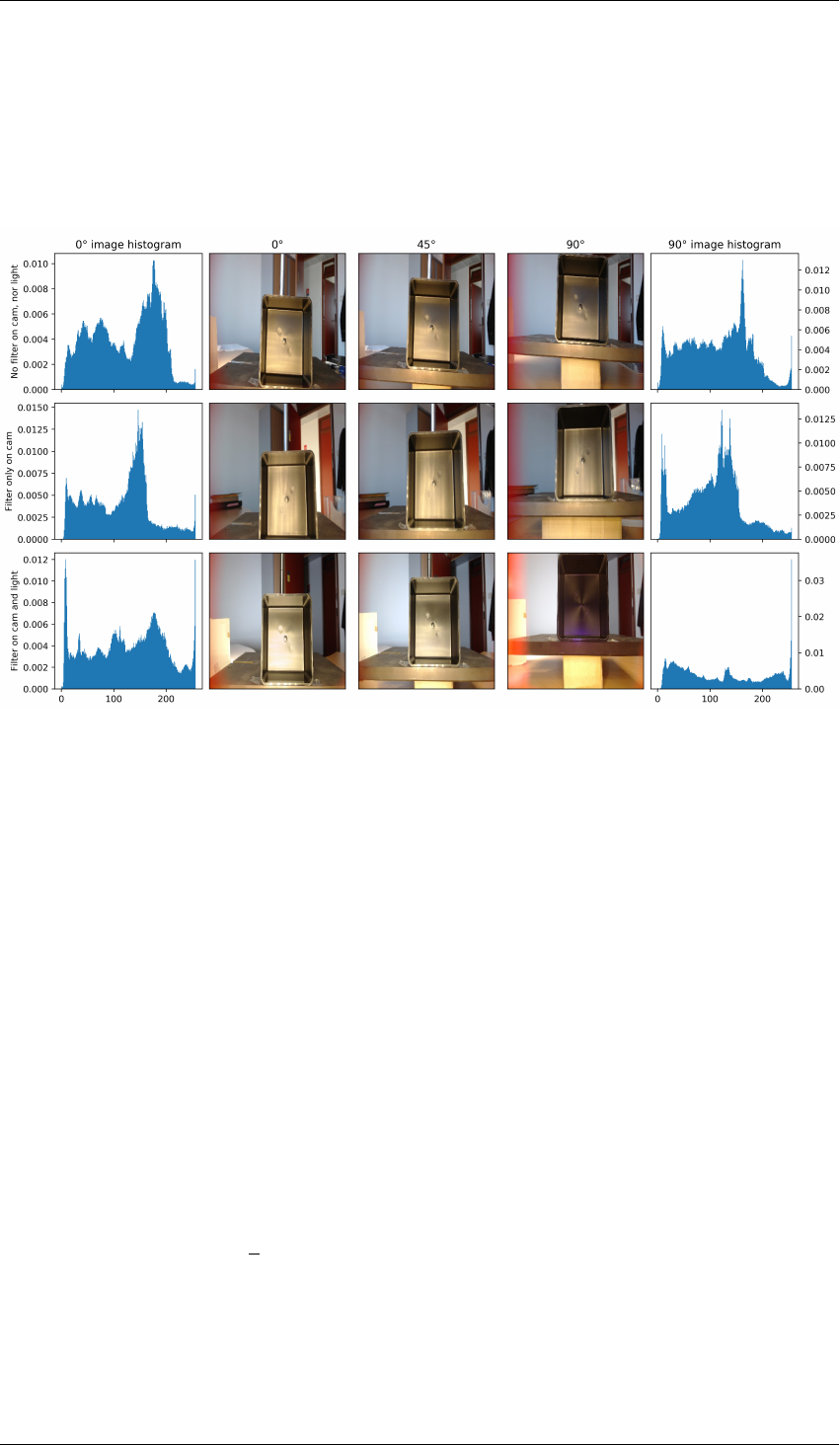

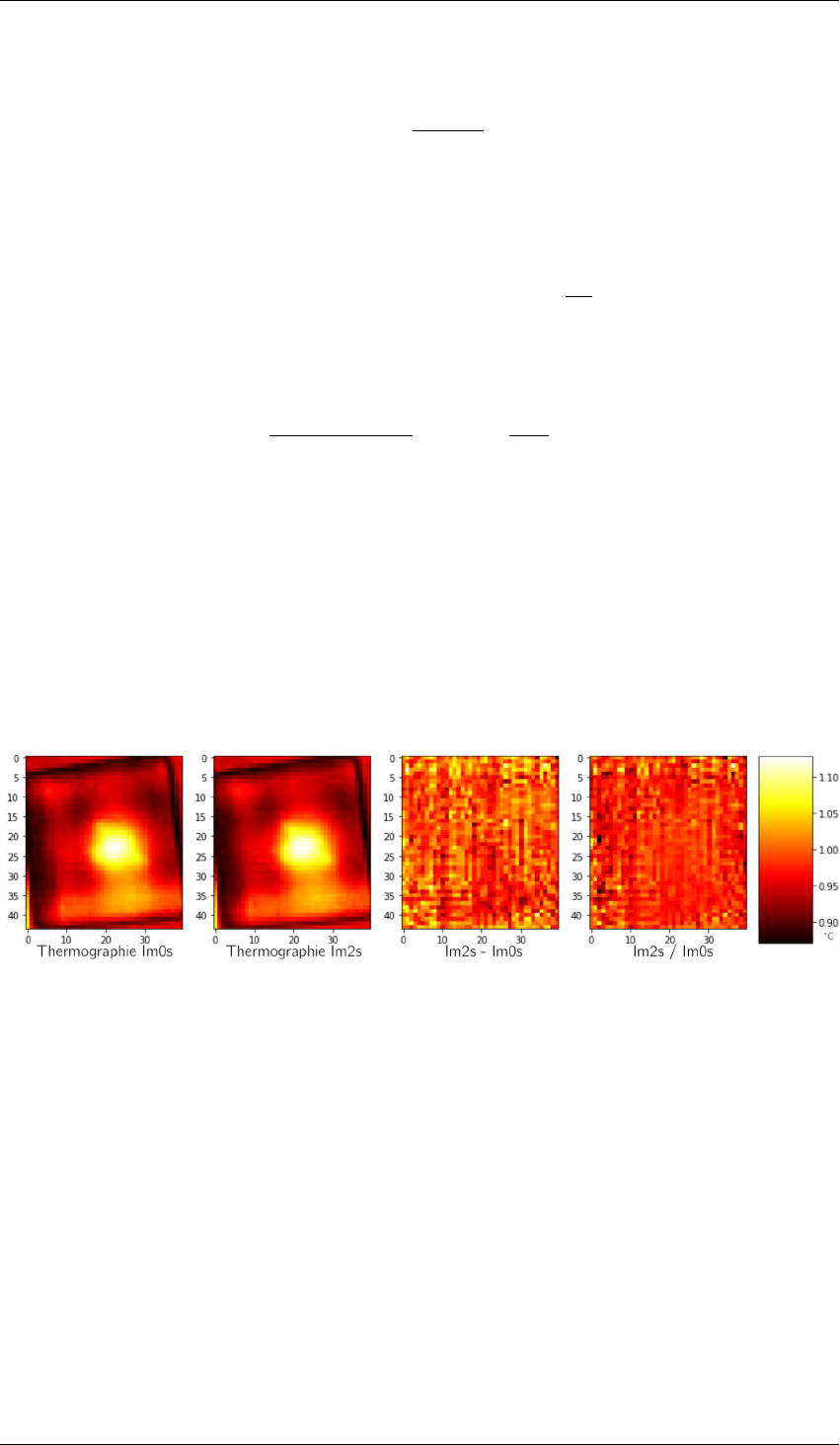

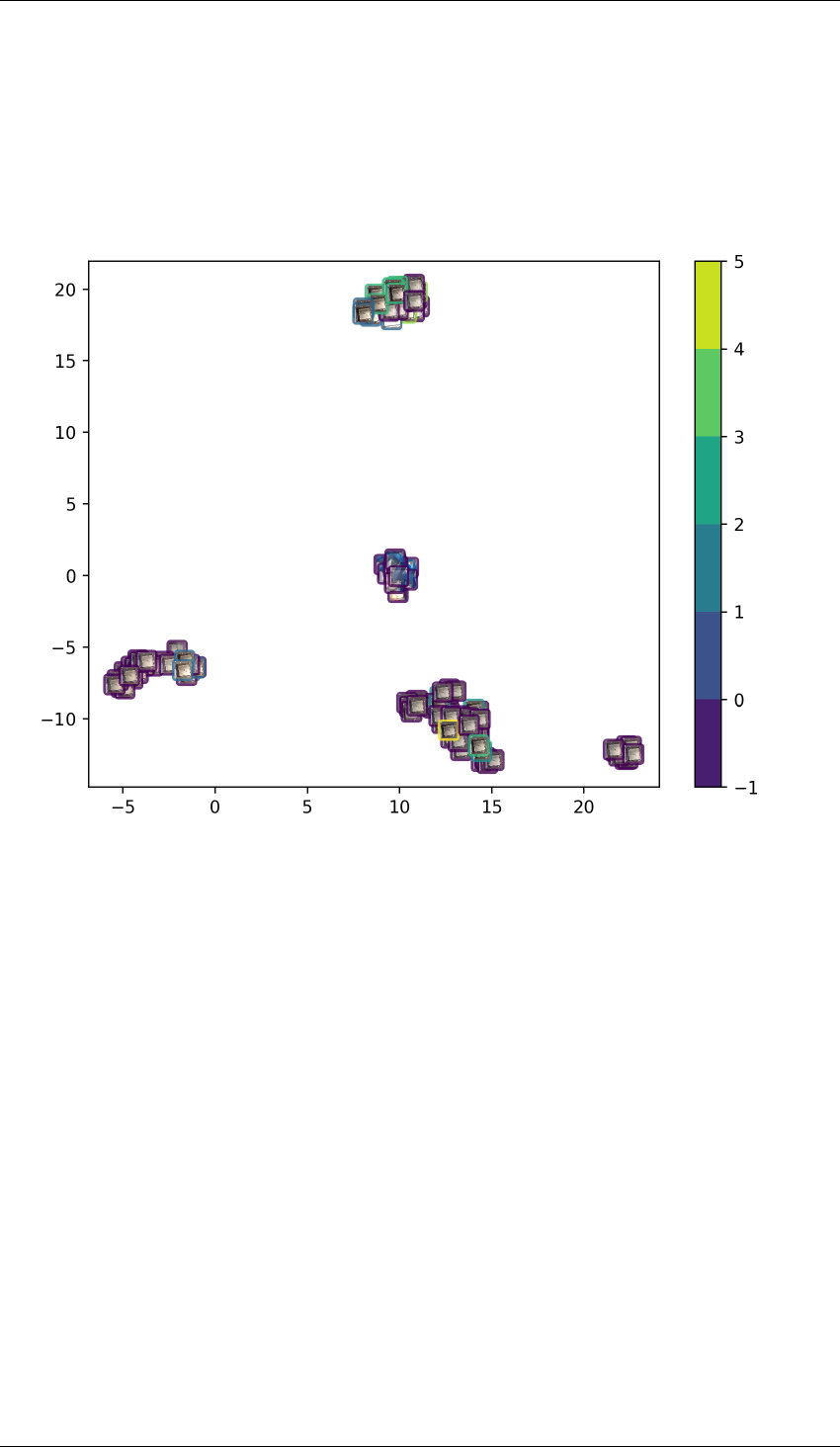

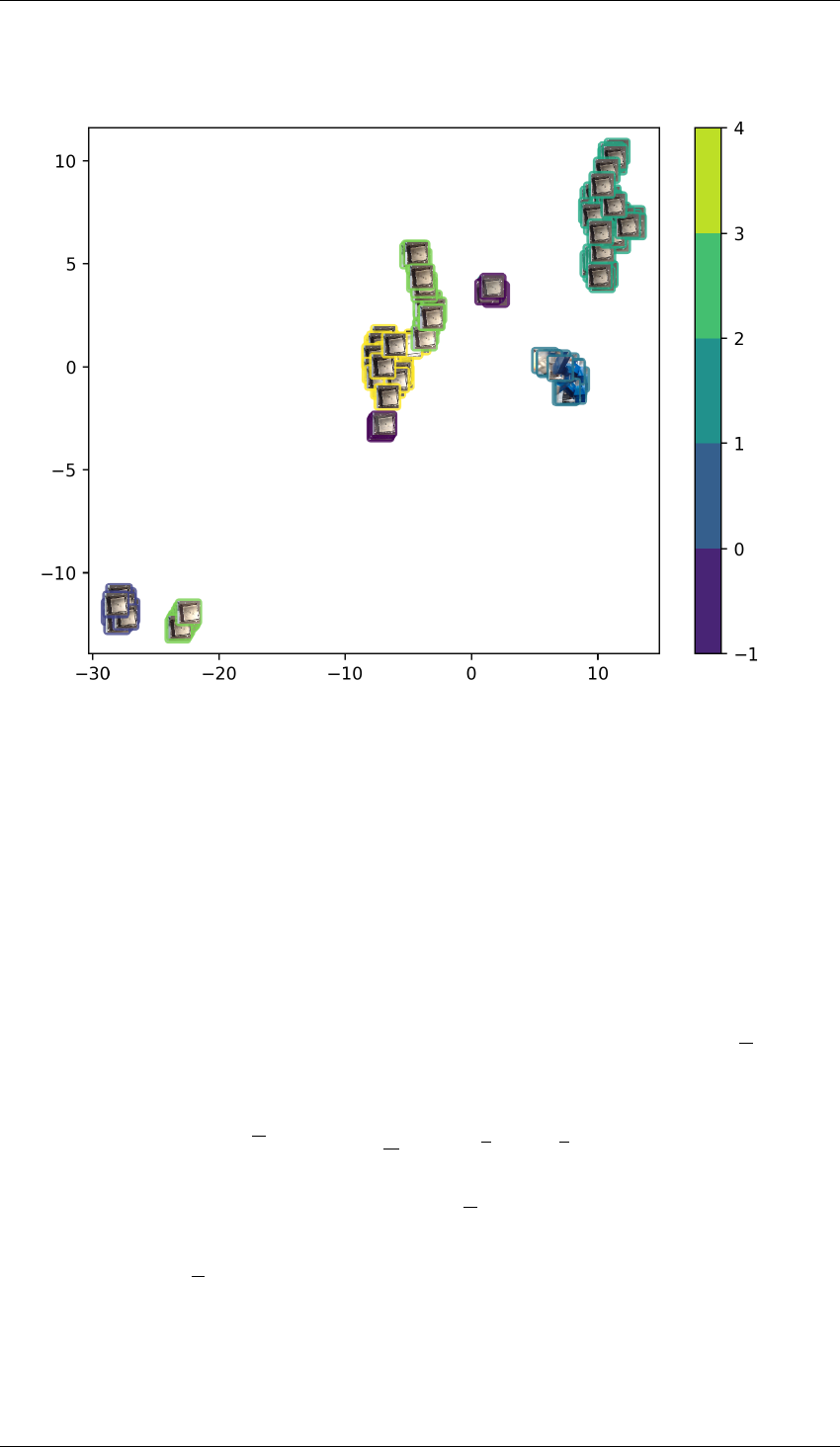

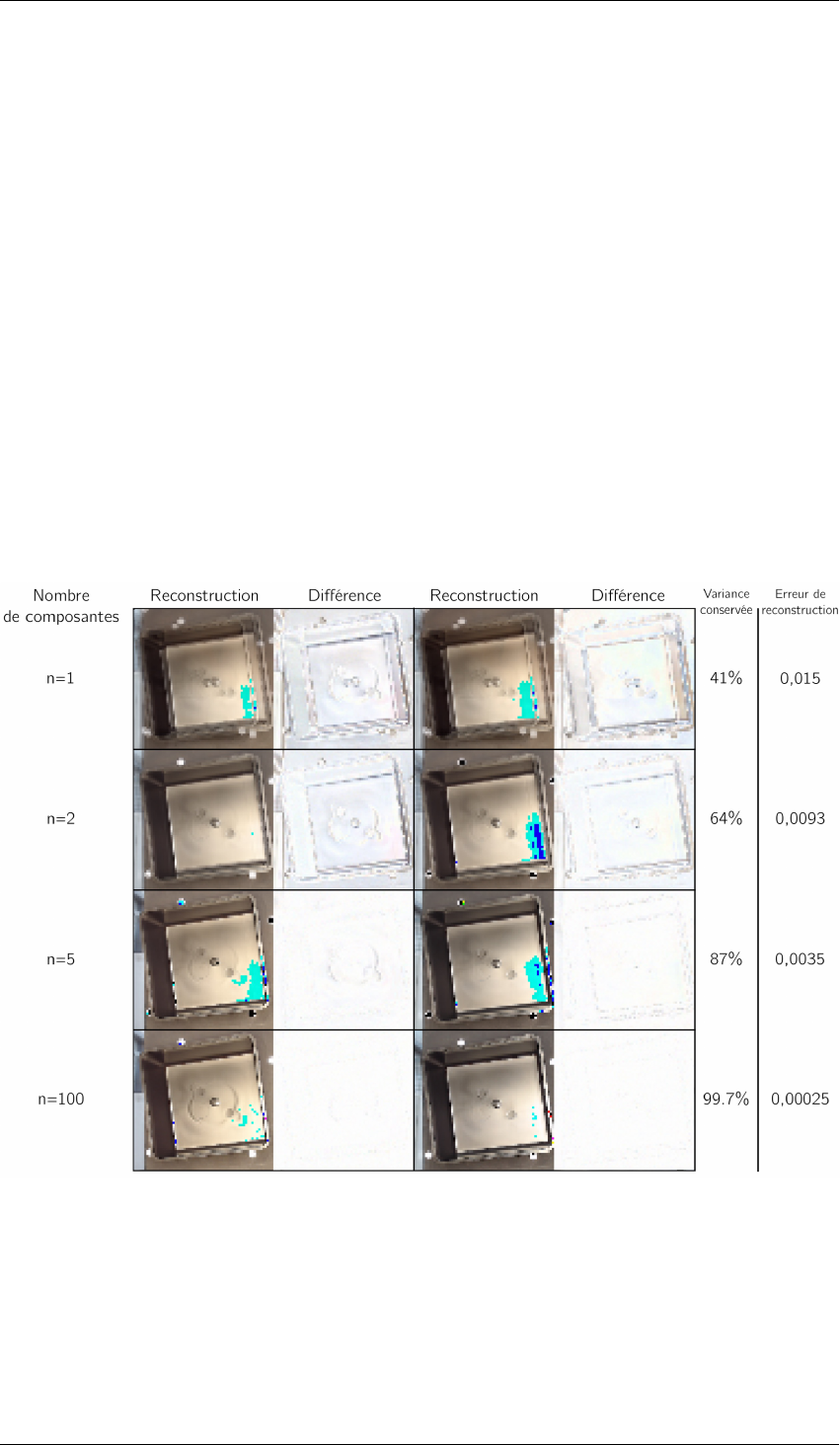

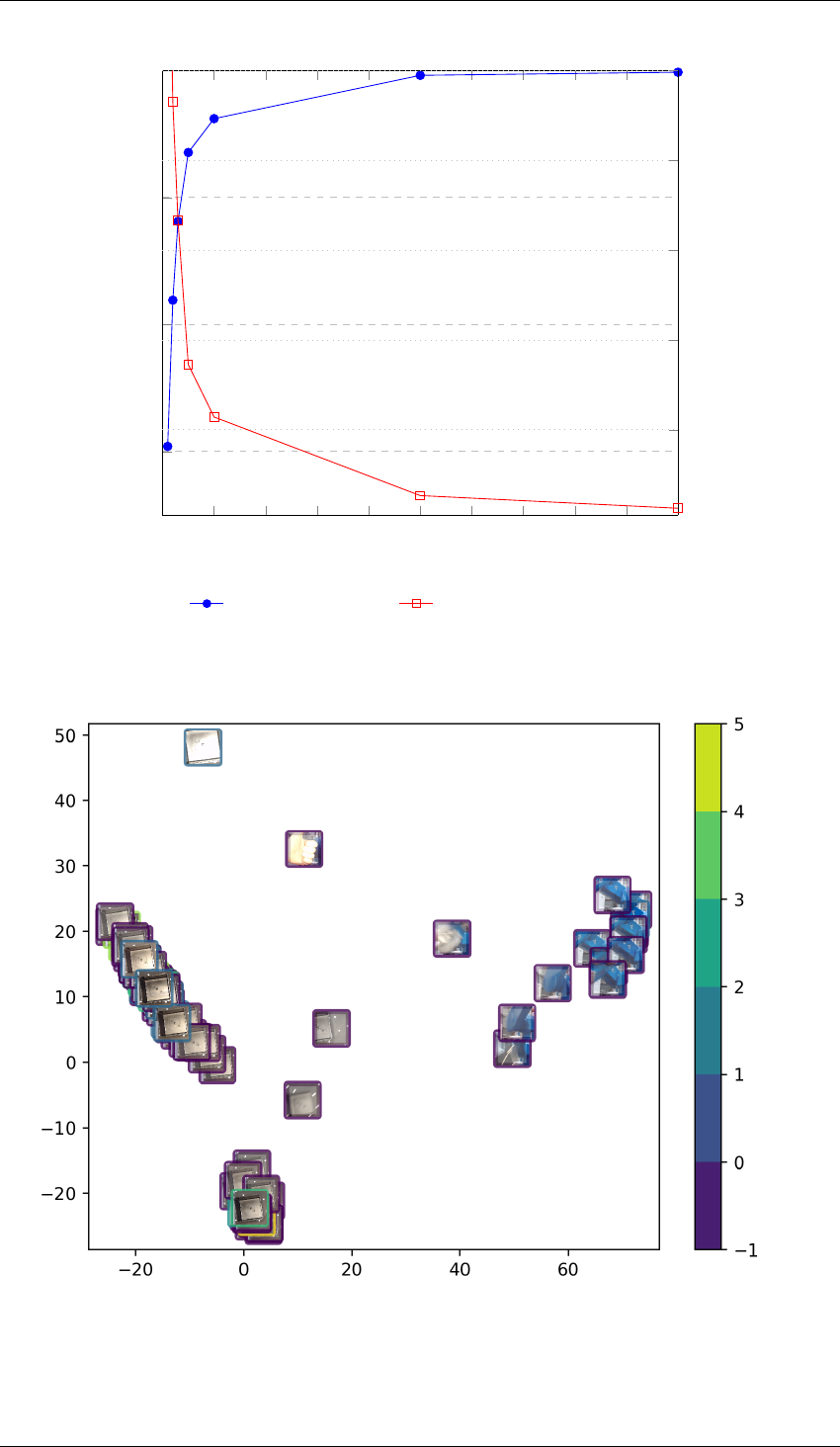

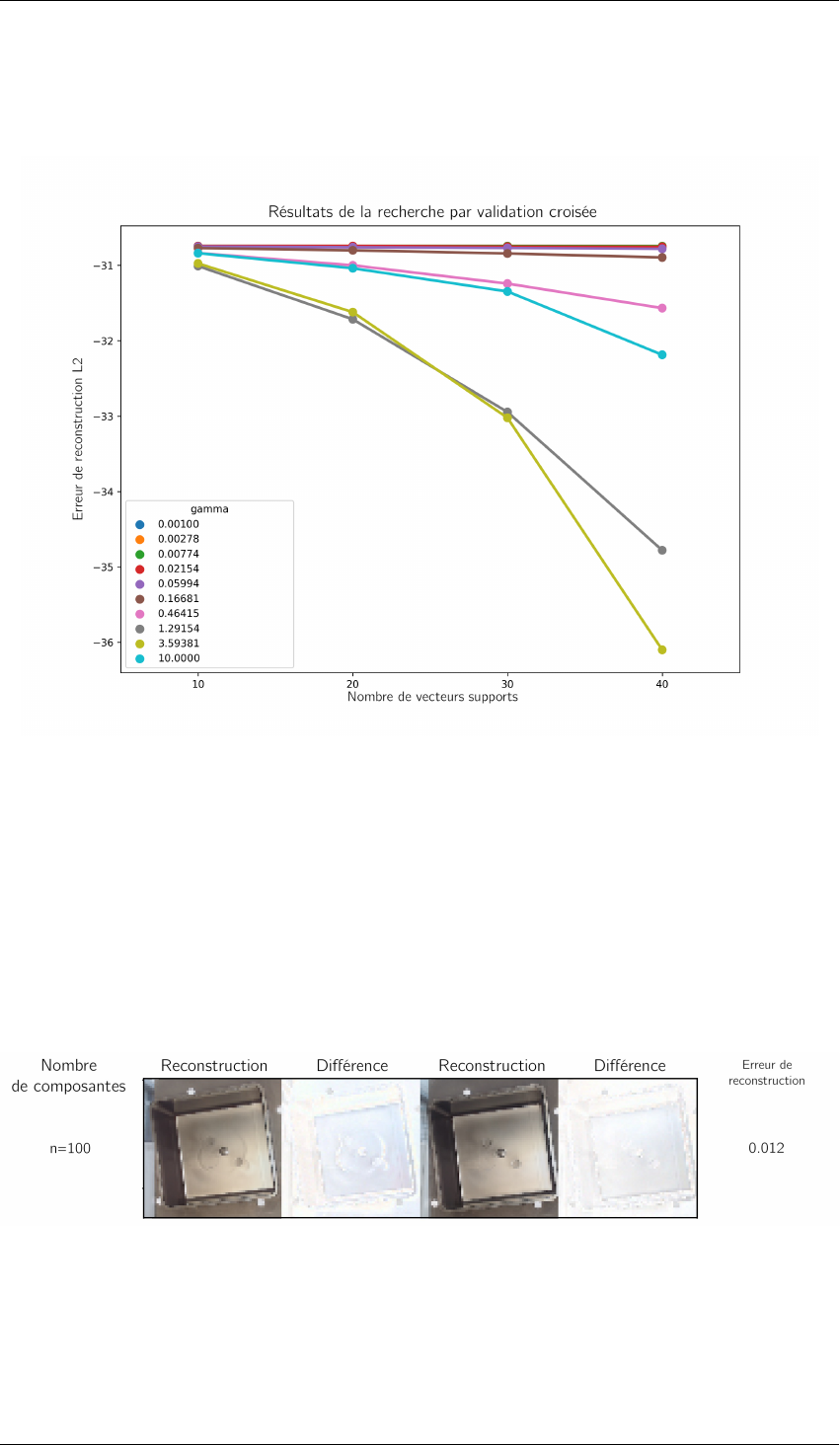

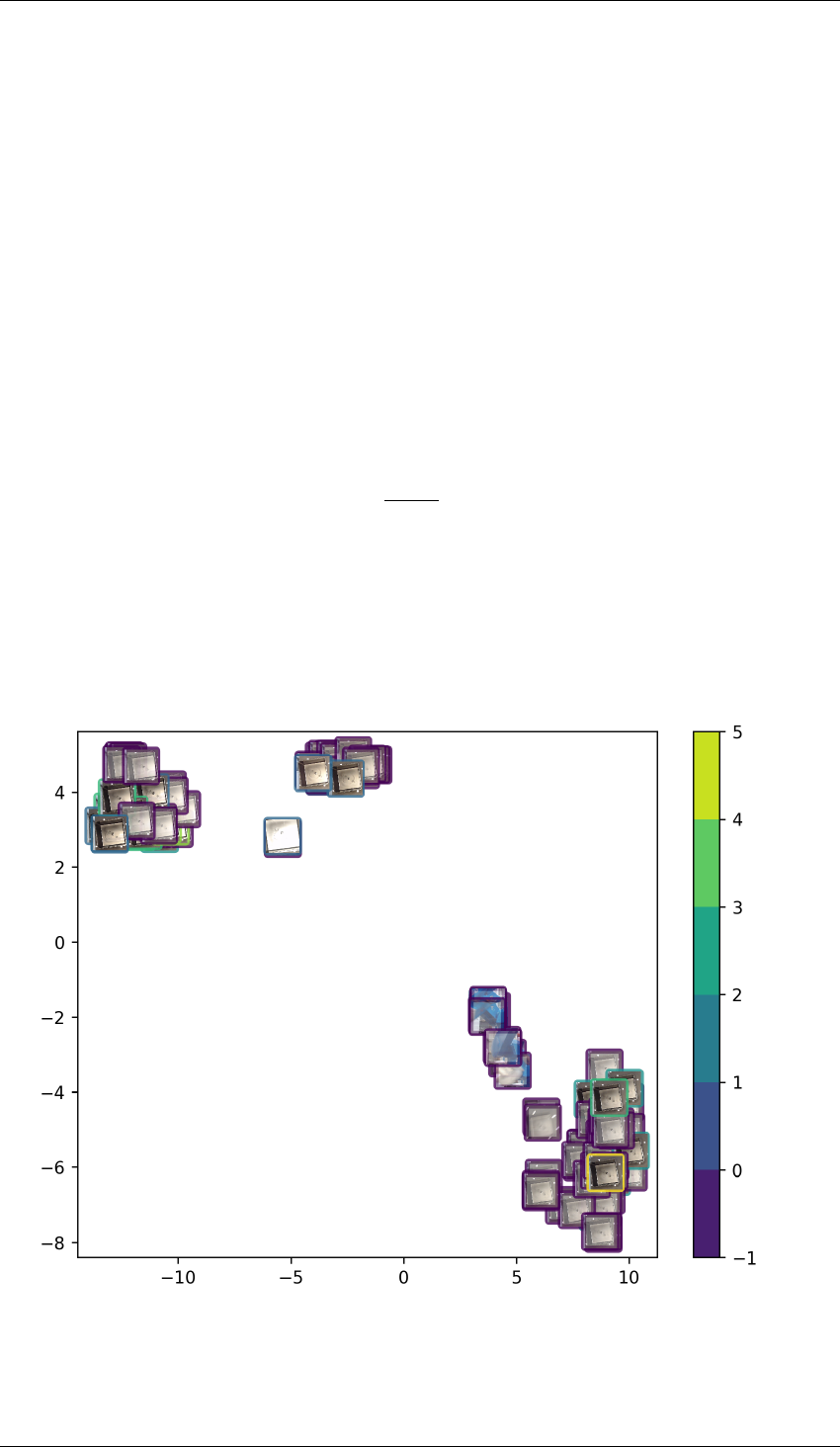

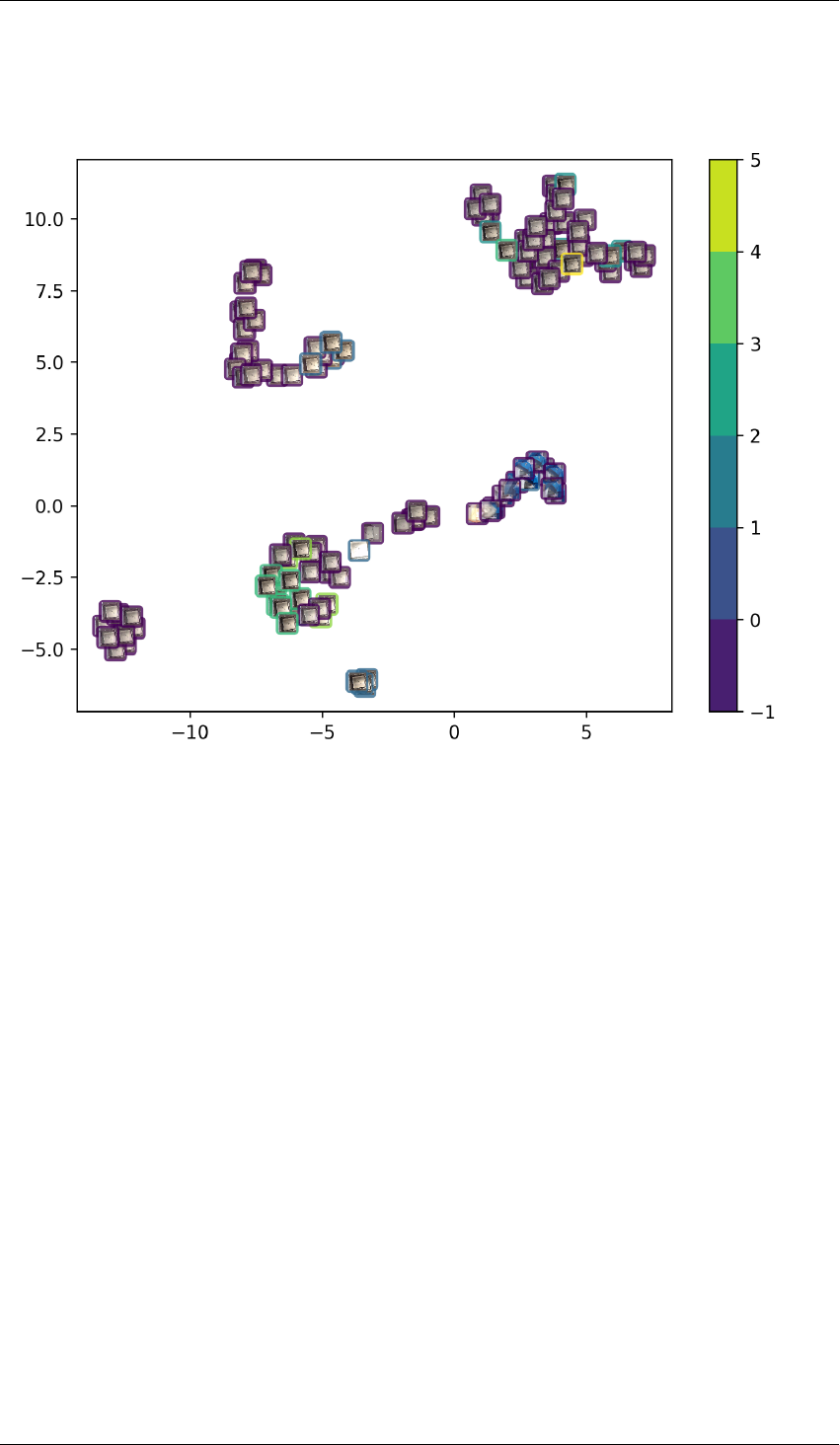

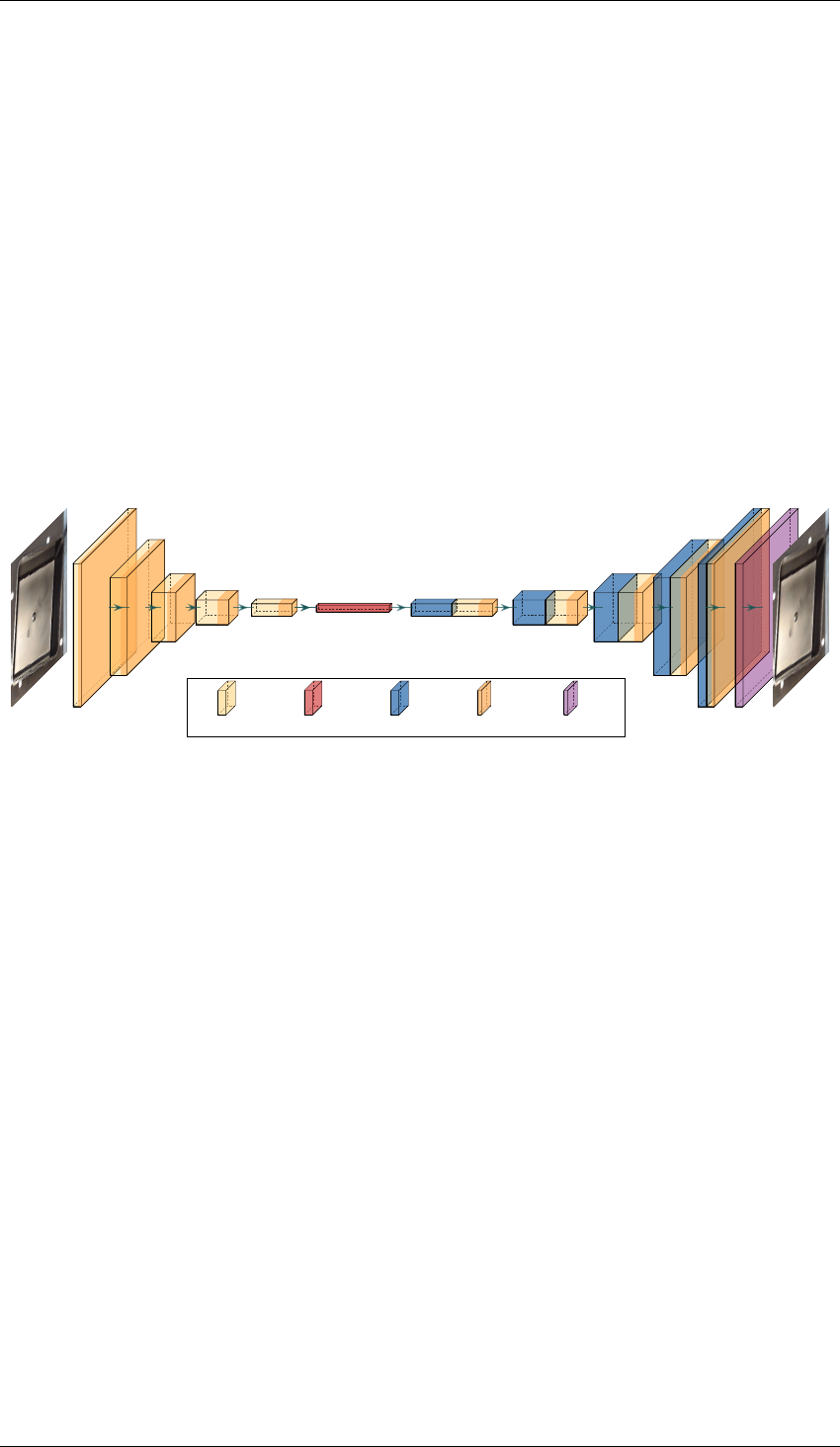

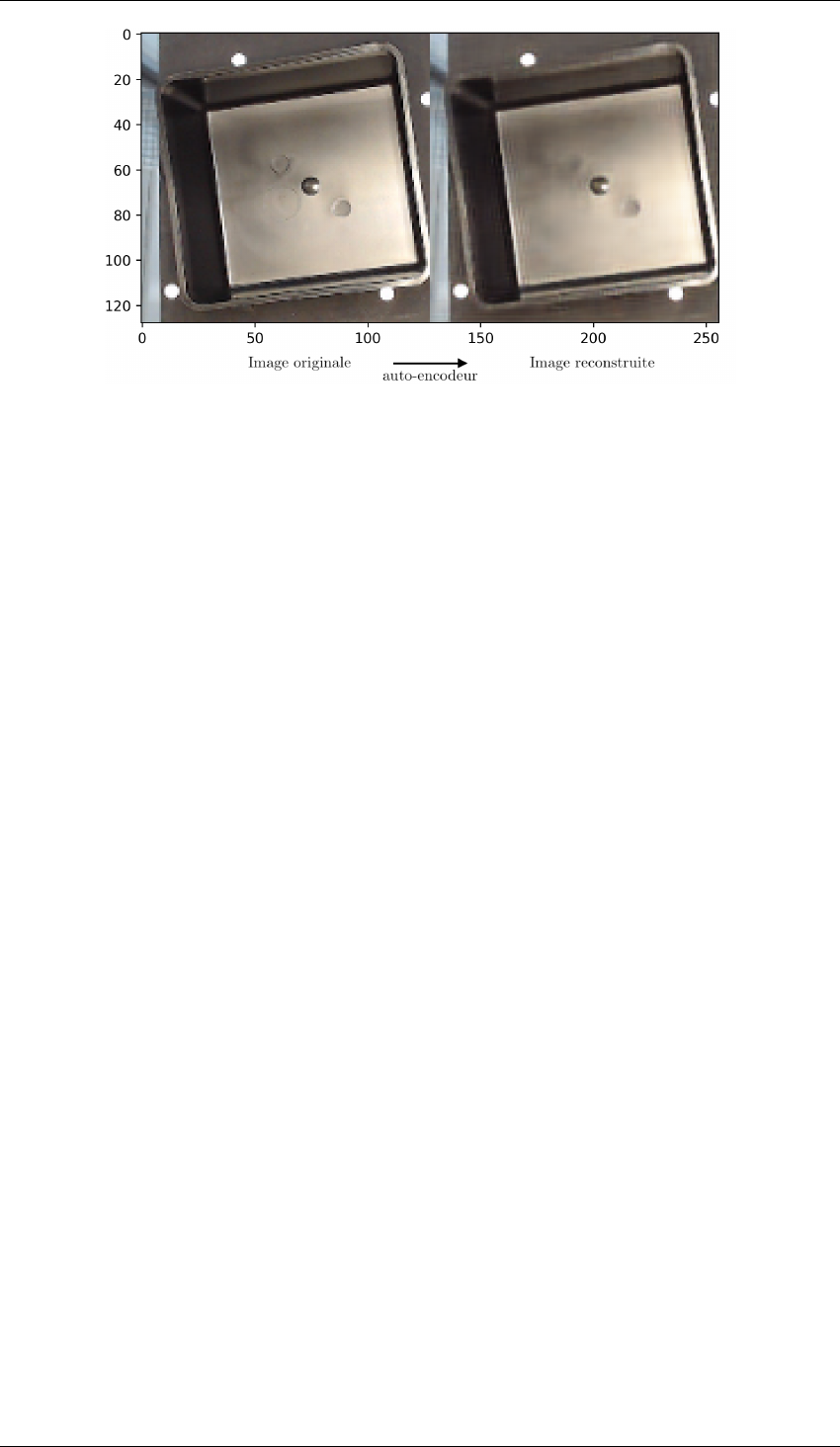

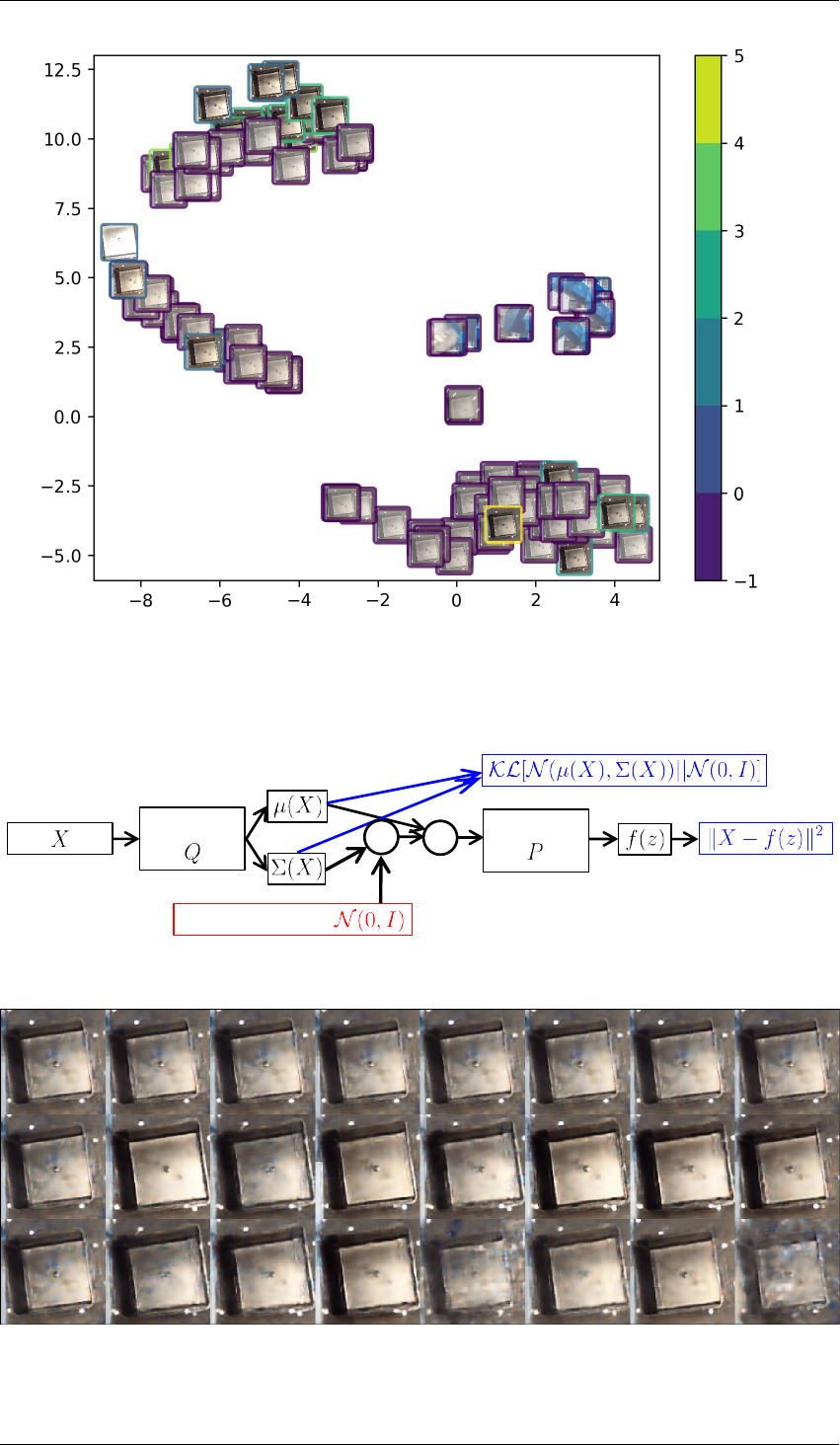

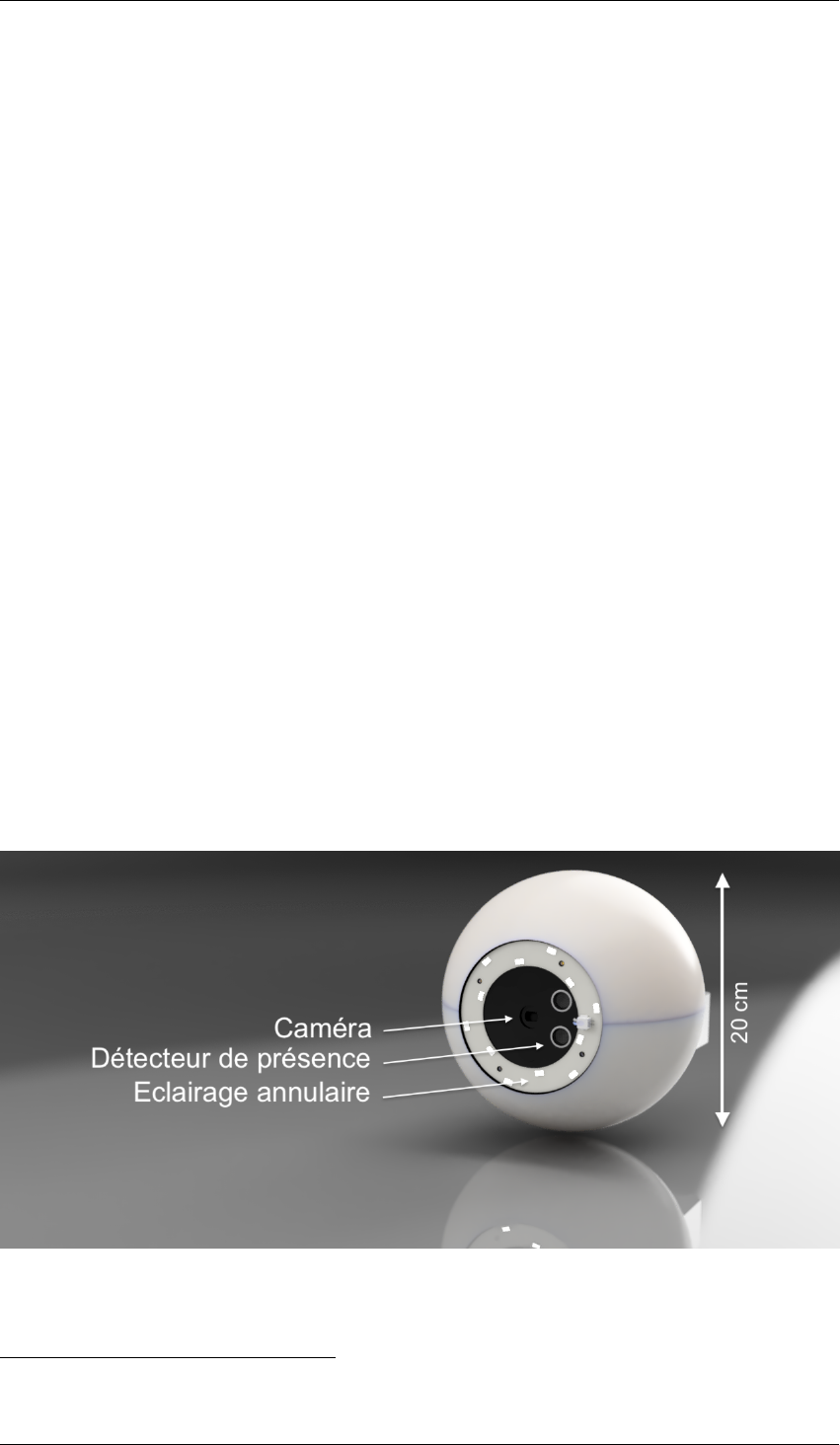

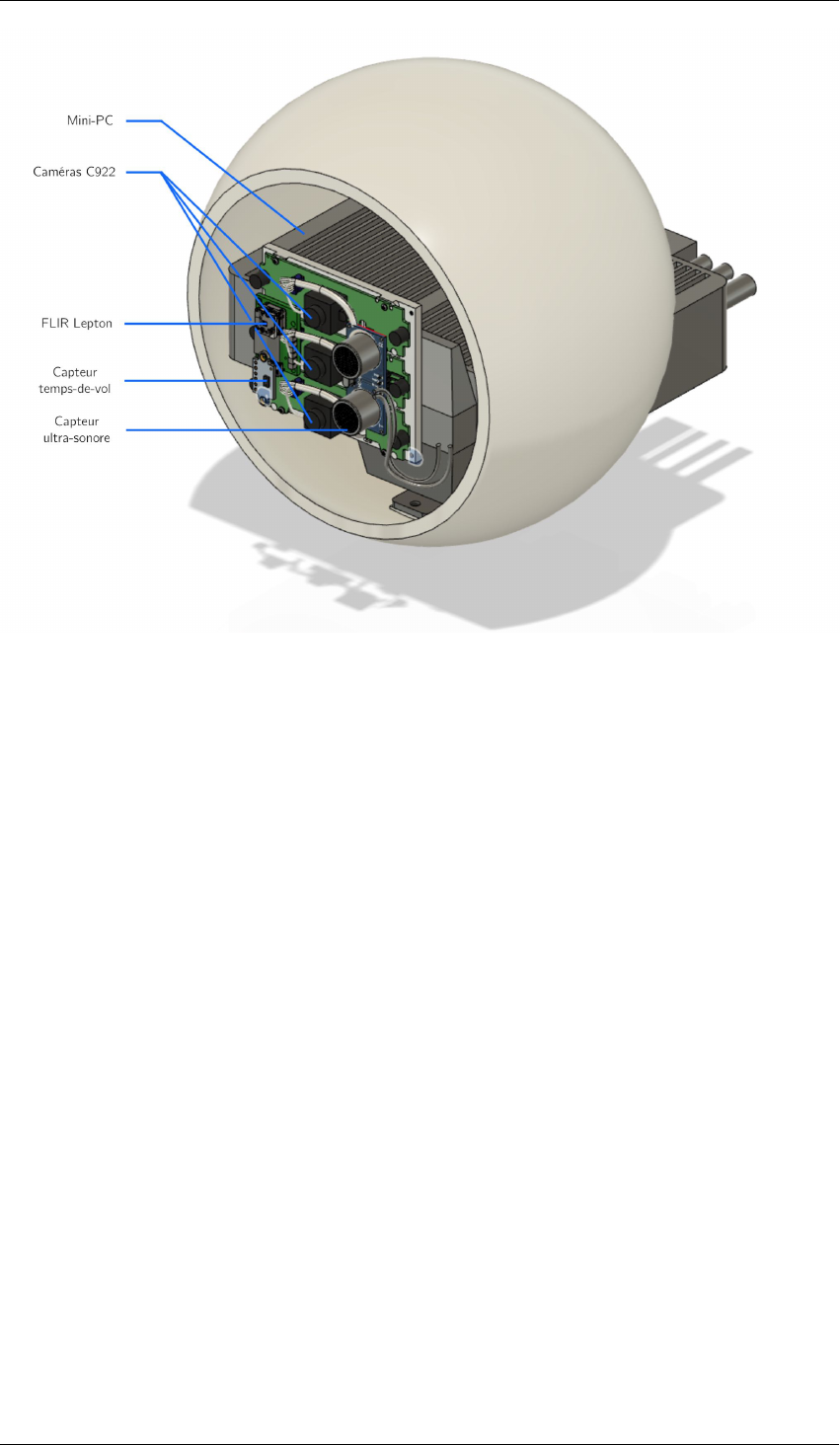

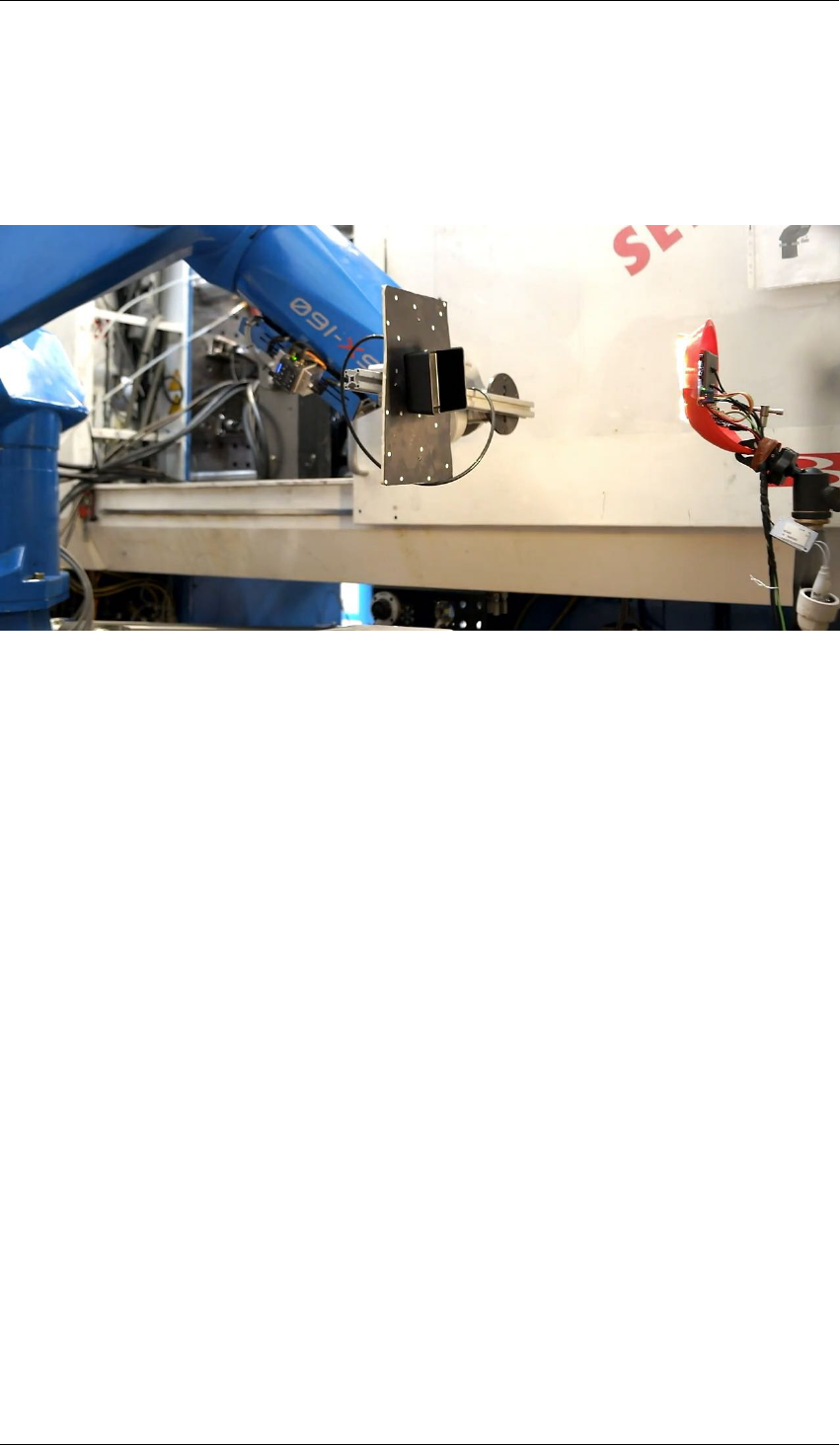

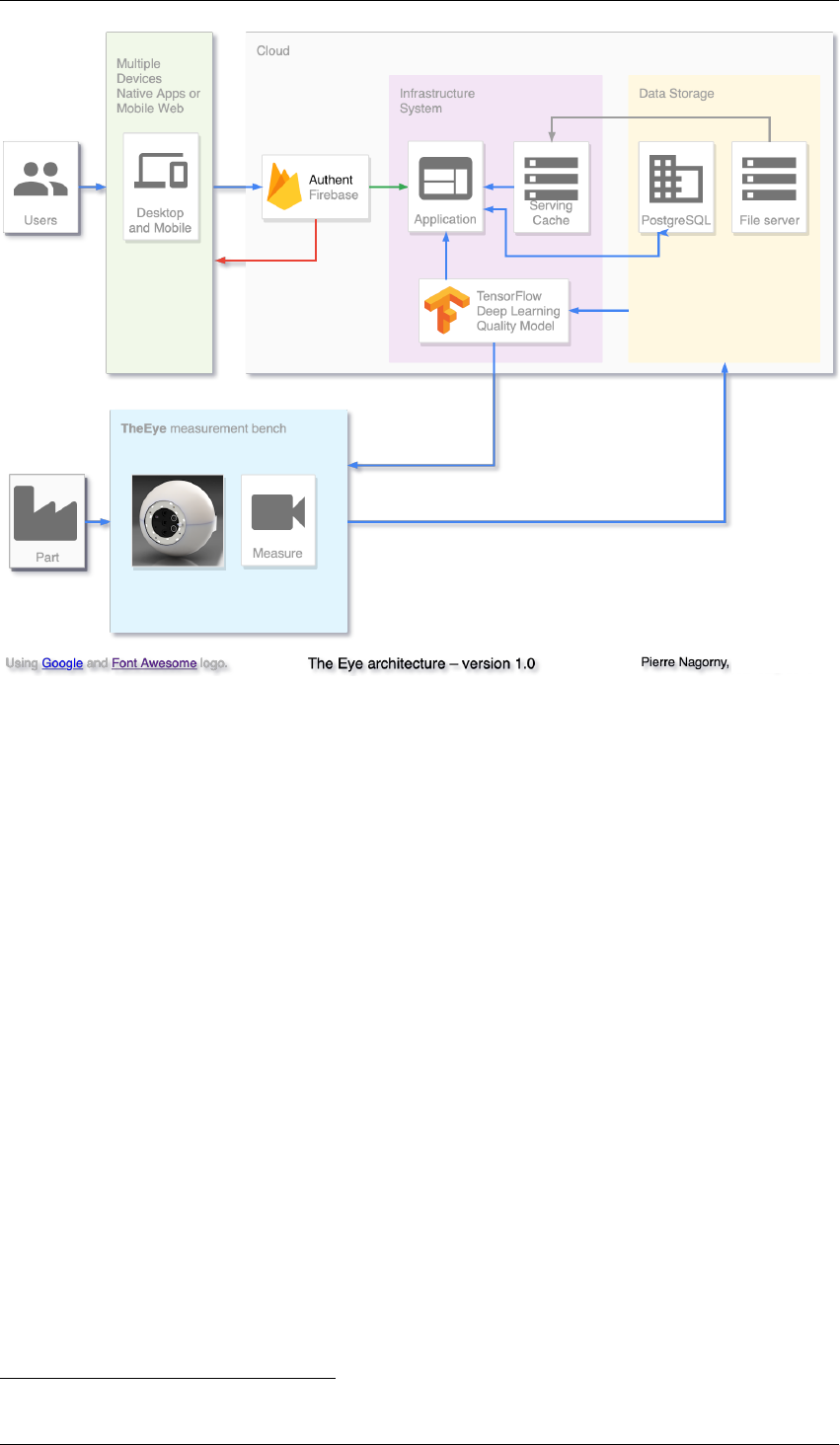

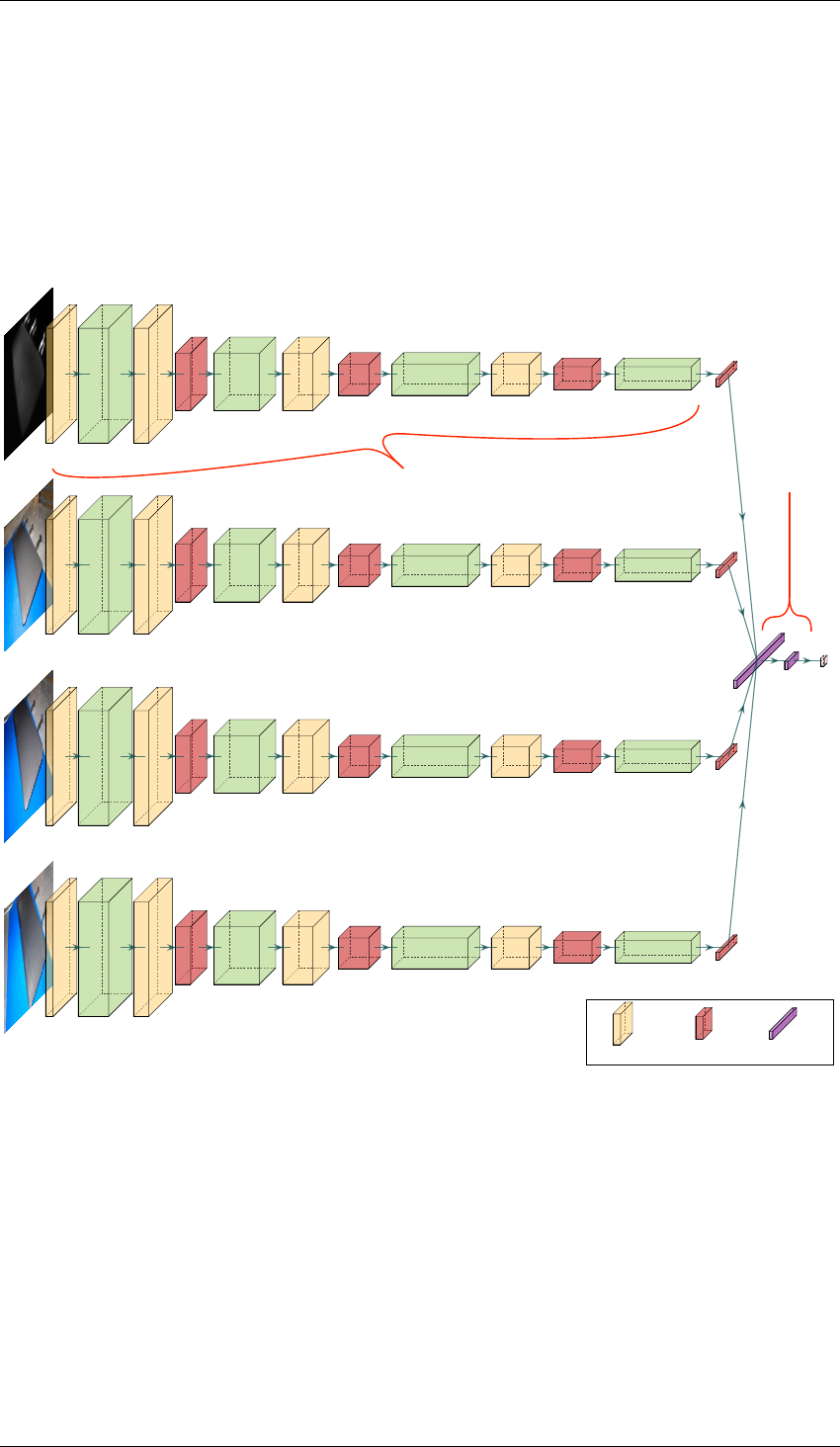

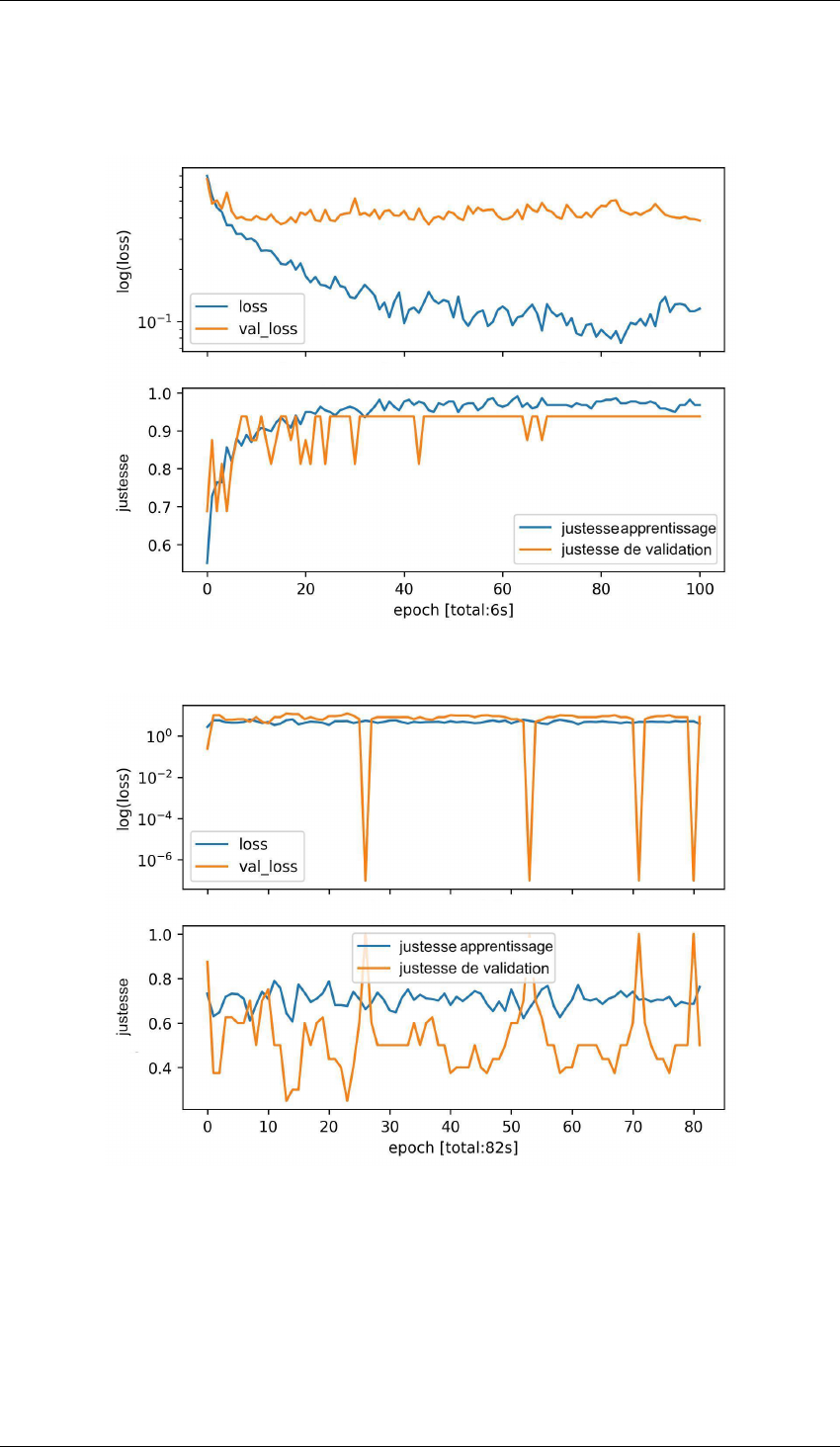

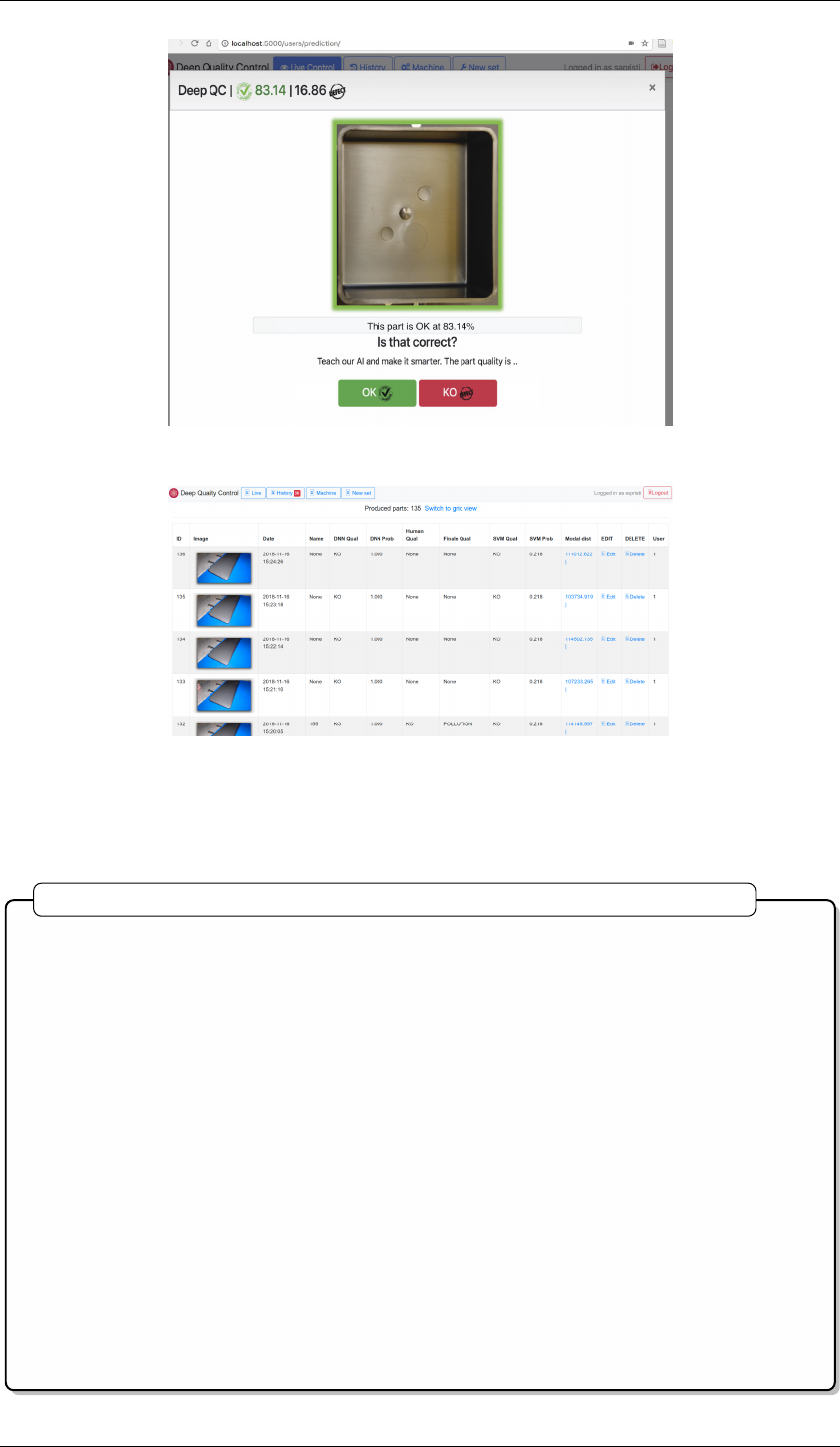

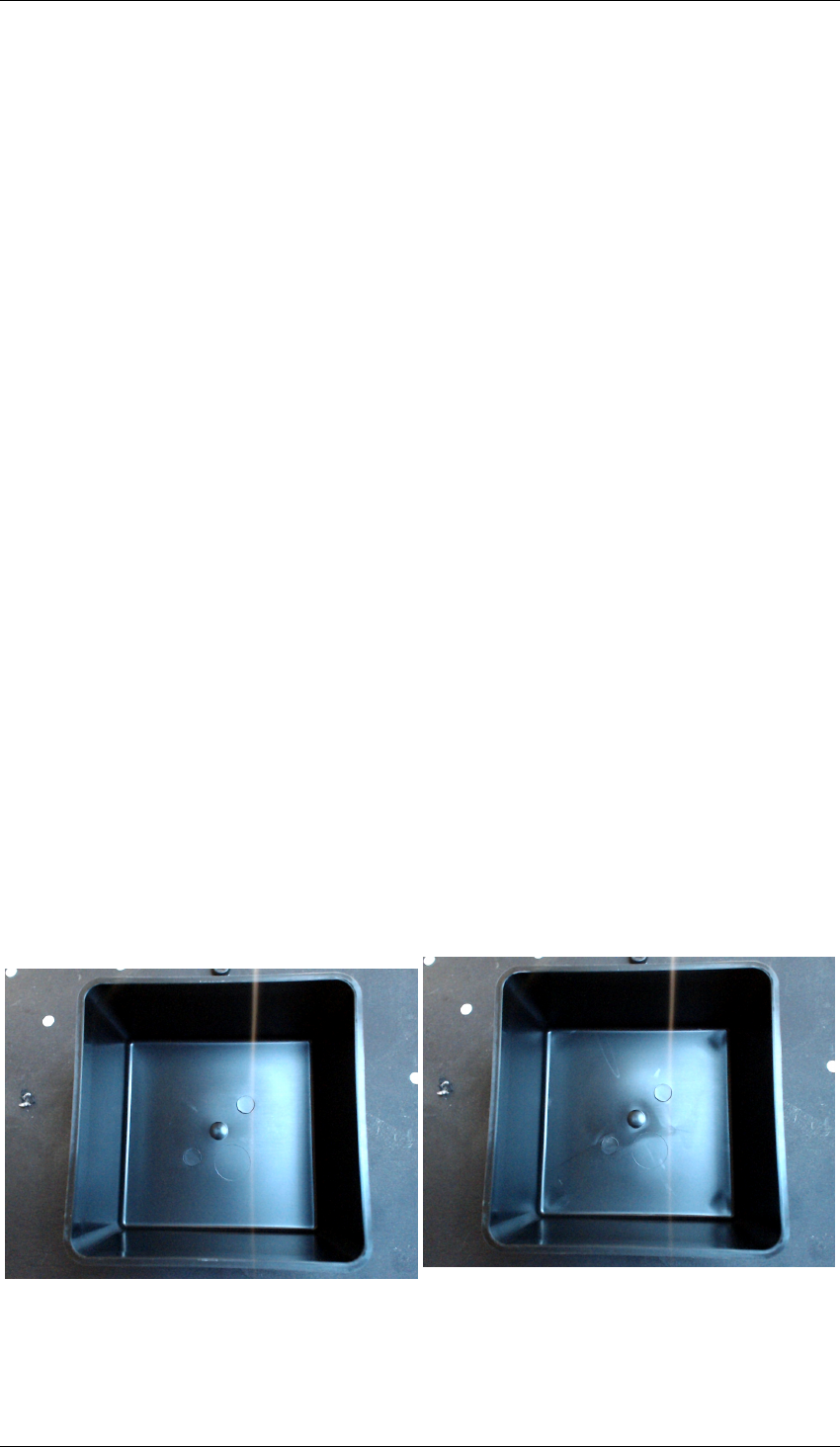

La Figure 1.8 présente ces signaux pour une pièce. On observe pour la pression une valeur